Analiza fișierelor jurnal SEO ajută la înțelegerea comportamentului crawler-ului pe site și la identificarea posibilelor oportunități tehnice de optimizare SEO.

SEO fără a analiza comportamentul crawlerelor este ca un zbor orb. Este posibil să fi trimis site-ul web pe consola de căutare Google și să l-ați indexat, dar fără a studia fișierele jurnal, nu veți avea o idee dacă site-ul dvs. este accesat cu crawlere sau citit corect de roboții motoarelor de căutare sau nu.

De aceea, am adunat tot ce trebuie să știți pentru a analiza fișierele jurnal SEO și a identifica problemele și oportunitățile SEO din acestea.

Cuprins

Ce este analiza fișierelor jurnal?

Analiza fișierelor jurnal SEO este un proces de recunoaștere a modelului de interacțiune a roboților motoarelor de căutare cu site-ul web. Analiza fișierelor de jurnal este o parte a SEO tehnic.

Auditarea fișierelor jurnal este importantă pentru SEO pentru a recunoaște și a rezolva problemele legate de accesarea cu crawlere, indexare, coduri de stare.

Ce sunt fișierele jurnal?

Fișierele jurnal urmăresc cine vizitează un site web și conținutul pe care îl vizualizează. Acestea conțin informații despre cine a solicitat acces la site-ul web (cunoscut și ca „Clientul”).

Informațiile percepute pot fi legate de roboții motoarelor de căutare precum Google sau Bing sau de un vizitator al site-ului web. De obicei, înregistrările fișierelor jurnal sunt colectate și menținute de serverul web al site-ului și, de obicei, sunt păstrate pentru o anumită perioadă de timp.

Ce conține fișierul jurnal?

Înainte de a cunoaște importanța fișierelor jurnal pentru SEO, este esențial să știi ce se află în interiorul acestui fișier. Fișierul jurnal e conține următoarele puncte de date:-

- Adresa URL a paginii pe care o solicită vizitatorul site-ului web

- Codul de stare HTTP al paginii

- Adresa IP a serverului solicitată

- Data și ora loviturii

- Datele agentului utilizator (bot motor de căutare) care face o solicitare

- Metoda de solicitare (GET/POST)

Fișierele jurnal vă pot părea complicate dacă le priviți mai întâi. Totuși, odată ce cunoașteți scopul și importanța fișierelor jurnal pentru SEO, le veți folosi în mod eficient pentru a genera informații SEO valoroase.

Scopul analizei fișierelor jurnal pentru SEO

Analiza fișierelor jurnal ajută la rezolvarea unora dintre problemele tehnice importante de SEO, ceea ce vă permite să creați o strategie SEO eficientă pentru a optimiza site-ul web.

Iată câteva probleme SEO care pot fi analizate folosind fișiere jurnal:

#1. Frecvența cu care Googlebot accesează cu crawlere site-ul

Boții sau crawlerele motoarelor de căutare ar trebui să acceseze cu crawlere paginile dvs. importante în mod frecvent, astfel încât motorul de căutare să știe despre actualizările site-ului dvs. sau despre conținutul nou.

Paginile dvs. importante de produse sau informații ar trebui să apară toate în jurnalele Google. O pagină de produs pentru un produs pe care nu-l mai vindeți, precum și absența oricăreia dintre cele mai importante pagini de categorie sunt indicatori ai unei probleme care poate fi recunoscută folosind fișierele jurnal.

Cum utilizează un robot robot de motor de căutare bugetul de accesare cu crawlere?

De fiecare dată când un motor de căutare accesează site-ul dvs., acesta are un „buget de accesare cu crawlere” limitat. Google definește un buget de accesare cu crawlere ca fiind suma dintre rata de accesare cu crawlere a unui site și cererea de accesare cu crawlere.

Accesarea cu crawlere și indexarea unui site pot fi îngreunate dacă acesta are multe adrese URL cu valoare mică sau adrese URL care nu sunt trimise corect în harta site-ului. Accesarea cu crawlere și indexarea paginilor cheie este mai ușoară dacă bugetul de accesare cu crawlere este optimizat.

Analiza fișierelor jurnal ajută la optimizarea bugetului de accesare cu crawlere care accelerează eforturile SEO.

#2. Probleme și stare de indexare pe mobil mai întâi

Indexarea în primul rând pe mobil este acum importantă pentru toate site-urile web, iar Google o preferă. Analiza fișierului jurnal vă va spune frecvența cu care smartphone-ul Googlebot vă accesează cu crawlere site-ul.

Această analiză îi ajută pe webmasteri să optimizeze paginile web pentru versiunile mobile, dacă paginile nu sunt accesate corect cu crawlere de către smartphone-ul Googlebot.

#3. Codul de stare HTTP returnat de paginile web atunci când este solicitat

Codurile de răspuns recente pe care le returnează paginile noastre web pot fi preluate fie prin fișiere jurnal, fie folosind opțiunea de solicitare de preluare și redare din Google Search Console.

Analizatorii de fișiere jurnal pot găsi paginile cu codurile 3xx, 4xx și 5xx. Puteți rezolva aceste probleme luând măsurile corespunzătoare, de exemplu, redirecționând adresele URL către destinațiile corecte sau schimbând starea 302 codificată la 301.

#4. Analizarea activităților de accesare cu crawlere, cum ar fi adâncimea accesării cu crawlere sau legăturile interne

Google apreciază structura site-ului dvs. pe baza adâncimii de accesare cu crawlere și a legăturilor interne. Motivele din spatele accesării cu crawlere necorespunzătoare a site-ului web pot fi structura proastă a interconexiunii și adâncimea accesării cu crawlere.

Dacă întâmpinați dificultăți cu ierarhia site-ului sau cu structura site-ului sau cu structura interlinkurilor, puteți utiliza analiza fișierelor jurnal pentru a le găsi.

Analiza fișierelor jurnal ajută la optimizarea arhitecturii site-ului web și a structurii interlinkurilor.

#4. Descoperiți paginile orfane

Paginile orfane sunt paginile web de pe site care nu sunt legate de nicio altă pagină. Este dificil ca astfel de pagini să fie indexate sau să apară în motoarele de căutare, deoarece nu sunt ușor de descoperit de către roboți.

Paginile orfane pot fi descoperite cu ușurință de către crawler-uri precum Screaming Frog, iar această problemă poate fi rezolvată prin interconectarea acestor pagini cu celelalte pagini de pe site.

#5. Auditează paginile pentru viteza și experiența paginii

Experiența paginii și elementele vitale web de bază sunt în mod oficial factorii de clasare acum și este important acum ca paginile web să respecte regulile Google privind viteza paginii.

Paginile lente sau mari pot fi descoperite folosind analizoare de fișiere jurnal, iar aceste pagini pot fi optimizate pentru viteza paginii, ceea ce va ajuta la clasarea generală pe SERP.

Analiza fișierelor jurnal vă ajută să obțineți control asupra modului în care site-ul dvs. este accesat cu crawlere și asupra modului în care motoarele de căutare vă gestionează site-ul

Acum, deoarece suntem clari cu elementele de bază ale fișierelor jurnal și analiza acestora, să ne uităm la procesul de auditare a fișierelor jurnal pentru SEO

Cum se face analiza fișierului jurnal

Am analizat deja diferite aspecte ale fișierelor jurnal și importanța SEO. Acum, este timpul să învățați procesul de analiză a fișierelor și cele mai bune instrumente pentru a analiza fișierele jurnal.

Veți avea nevoie de acces la fișierul jurnal al serverului site-ului web pentru a accesa fișierul jurnal. Fișierele pot fi analizate în următoarele moduri:

Există diferiți pași implicați în accesarea manuală a fișierelor jurnal.

- Colectați sau exportați datele de jurnal de pe serverul web, iar datele ar trebui filtrate pentru roboții sau crawlerele motoarelor de căutare.

- Convertiți fișierul descărcat într-un format care poate fi citit folosind instrumente de analiză a datelor.

- Analizați manual datele folosind Excel sau alte instrumente de vizualizare pentru a găsi lacune și oportunități SEO.

- De asemenea, puteți utiliza programe de filtrare și linii de comandă pentru a vă ușura munca

Lucrul manual asupra datelor fișierelor nu este ușor, deoarece necesită cunoștințe de Excel și implică echipa de dezvoltare. Cu toate acestea, instrumentele pentru analiza fișierelor jurnal facilitează munca SEO.

Să ne uităm la instrumentele de top pentru auditarea fișierelor jurnal și să înțelegem cum aceste instrumente ne ajută să analizăm fișierele jurnal.

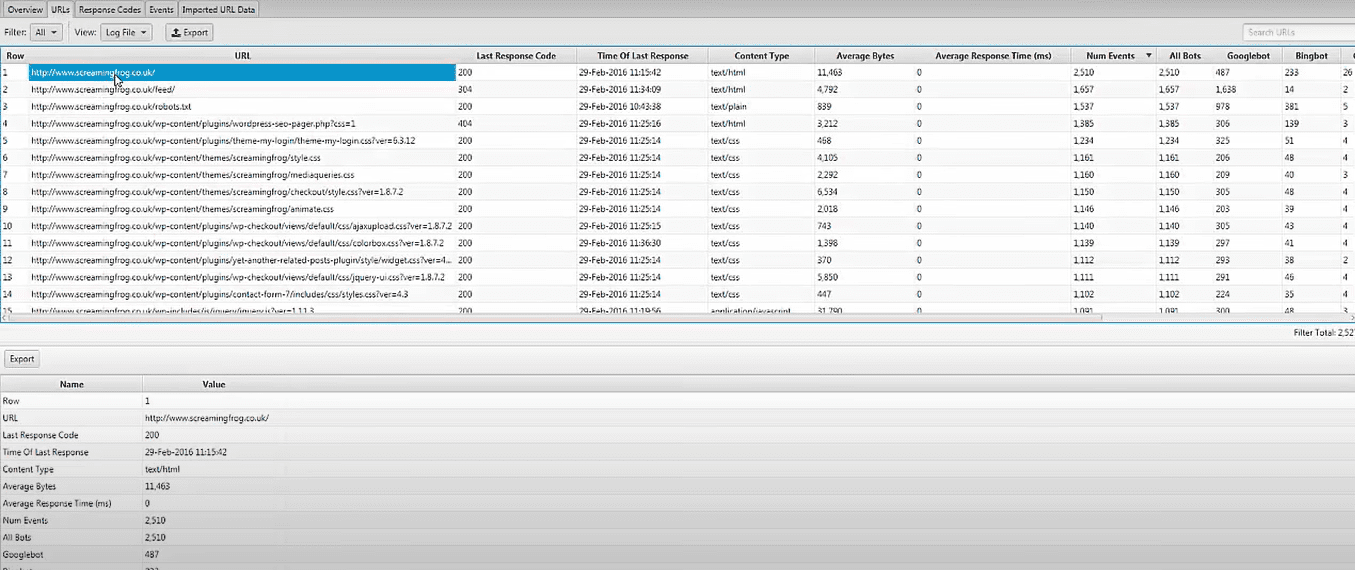

Screaming Frog Analizator de fișiere jurnal

Problemele tehnice SEO pot fi identificate utilizând datele din fișierele jurnal încărcate și roboții motoarelor de căutare verificați folosind Screaming Frog Analizator de fișiere jurnal. De asemenea, puteți face după cum urmează:

- Activitatea botului motorului de căutare și date pentru optimizarea motoarelor de căutare.

- Descoperiți frecvența de accesare cu crawlere a site-ului de către roboții motoarelor de căutare

- Aflați despre toate problemele tehnice SEO și linkurile interne și externe întrerupte

- Analiza adreselor URL care au fost accesate cu crawlere cel mai puțin și cel mai mult pentru a reduce pierderile și a crește eficiența.

- Descoperiți pagini care nu sunt accesate cu crawlere de motoarele de căutare.

- Orice date poate fi comparată și combinată, inclusiv date de link-uri externe, directive și alte informații.

- Vizualizați datele despre adresele URL de referință

Instrumentul de analiză a fișierelor jurnal Screaming Frog este complet gratuit de utilizat pentru un singur proiect, cu o limită de 1000 de evenimente de jurnal de linie. Va trebui să faceți upgrade la versiunea plătită dacă doriți acces nelimitat și asistență tehnică.

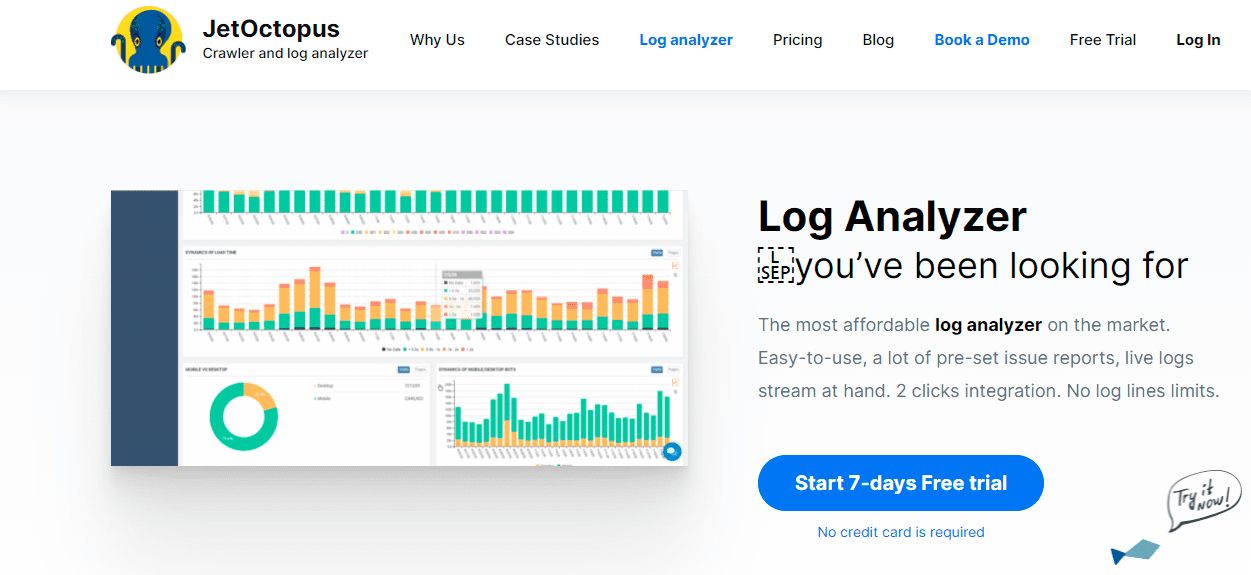

JetOctopus

Când vine vorba de instrumente de analiză a jurnalelor accesibile, JetOctopus este cel mai bun. Are o perioadă de încercare gratuită de șapte zile, nu este necesar un card de credit și o conexiune cu două clicuri. Frecvența accesării cu crawlere, bugetul accesării cu crawlere, cele mai populare pagini și multe altele pot fi identificate folosind Analizor de jurnal JetOctopusla fel ca celelalte instrumente de pe lista noastră.

Cu acest instrument, puteți integra datele fișierului jurnal cu datele Google Search Console, oferindu-vă un avantaj distinct față de concurență. Cu această combinație, veți putea vedea cum interacționează Googlebot cu site-ul dvs. și unde vă puteți îmbunătăți.

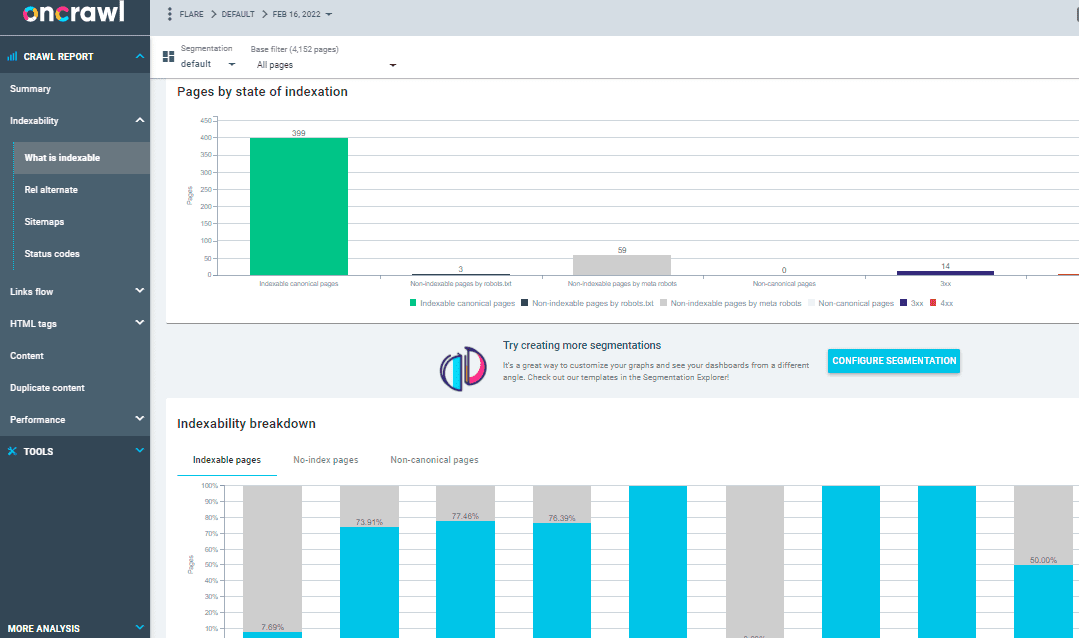

Pe Crawl Log Analyzer

Peste 500 de milioane de linii de jurnal sunt procesate de Analizor de jurnal oncrawl, un instrument conceput pentru site-uri web medii spre mari. Acesta ține un ochi pe jurnalele serverului dvs. web în timp real pentru a se asigura că paginile dvs. sunt indexate și accesate cu crawlere în mod corespunzător.

Oncrawl Log Analyzer este compatibil cu GDPR și foarte sigur. În loc de adrese IP, programul stochează toate fișierele jurnal într-un nor FTP securizat și separat.

Pe lângă JetOctopus și Screaming Frog Log File Analyzer, Oncrawl are câteva caracteristici suplimentare, cum ar fi:

- Acceptă multe formate de jurnal, cum ar fi IIS, Apache și Nginx.

- Instrumentul se adaptează cu ușurință la cerințele dvs. de procesare și stocare pe măsură ce acestea se modifică

- Segmentarea dinamică este un instrument puternic pentru a descoperi modele și conexiuni în datele dvs. prin gruparea adreselor URL și a linkurilor interne pe baza diferitelor criterii.

- Utilizați punctele de date din fișierele dvs. jurnal brute pentru a crea rapoarte SEO acționabile.

- Fișierele jurnal transferate în spațiul dvs. FTP pot fi automatizate cu ajutorul personalului tehnic.

- Toate browserele populare pot fi monitorizate, inclusiv Google, Bing, Yandex și crawlerele Baidu.

OnCrawl Log Analyzer are două instrumente importante:

Oncrawl SEO Crawler: Cu Oncrawl SEO Crawler, vă puteți accesa cu crawlere site-ul web cu viteză mare și cu resurse minime. Îmbunătățește înțelegerea de către utilizator a modului în care criteriile de clasare afectează optimizarea pentru motoarele de căutare (SEO).

Date oncrawl: Datele de accesare cu crawlere analizează toți factorii SEO combinând datele din accesare cu crawlere și analize. Acesta preia datele din fișierele de accesare cu crawlere și din fișierele jurnal pentru a înțelege comportamentul accesării cu crawlere și recomandă bugetul de accesare cu crawlere pentru conținut prioritar sau pagini de clasare.

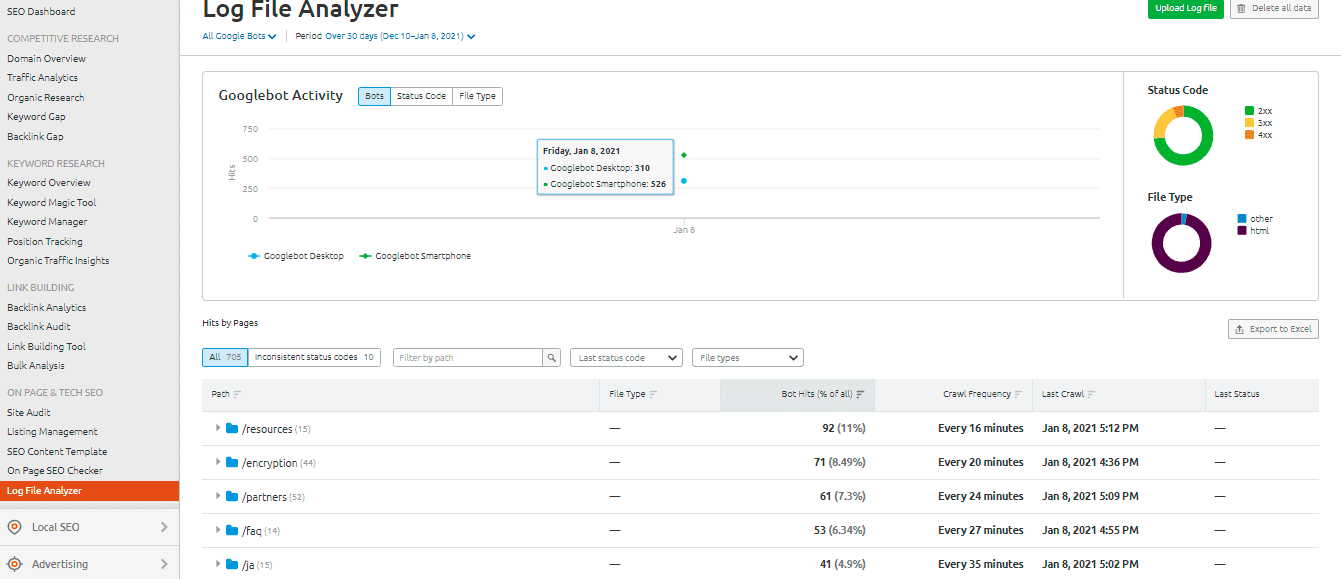

Analizor de fișiere jurnal SEMrush

The Analizor de fișiere jurnal SEMrush este o alegere inteligentă pentru un instrument simplu de analiză a jurnalelor bazat pe browser. Acest analizor nu necesită descărcare și poate fi utilizat în versiunea online.

SEMrush vă prezintă două rapoarte:

Hit-uri ale paginilor: Afișările paginilor raportează interacțiunea crawlerelor web cu conținutul site-ului dvs. web. Vă oferă datele paginilor, folderelor și adreselor URL cu interacțiunile maxime și minime cu roboții.

Activitatea Googlebot: Raportul de activitate Googlebot oferă zilnic informații despre site, cum ar fi:

- Tipurile de fișiere accesate cu crawlere

- Codul general de stare HTTP

- Numărul de solicitări făcute către site-ul dvs. de către diverși roboți

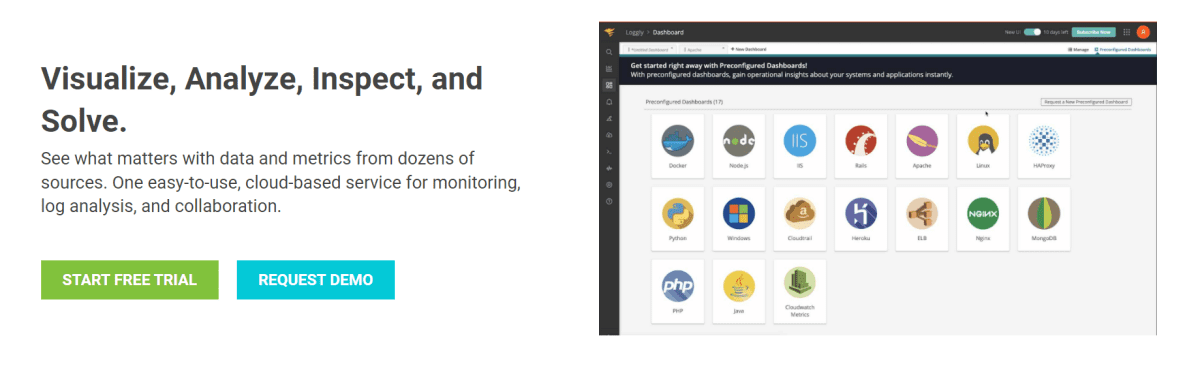

Loggly de la SolarWinds

Loggly al lui SolarWinds examinează jurnalele de acces și erori ale serverului dvs. web, precum și valorile săptămânale ale site-ului. Puteți vedea datele din jurnal în orice moment și are caracteristici care simplifică căutarea prin jurnal.

Un instrument robust de analiză a fișierelor jurnal, cum ar fi SolarWinds Loggly, este necesar pentru a extrage eficient fișierele jurnal de pe serverul dvs. web pentru informații despre succesul sau eșecul solicitărilor de resurse de la clienți.

Loggly poate oferi diagrame care afișează paginile cel mai puțin frecvent vizualizate și poate calcula vitezele medii, minime și maxime de încărcare a paginilor pentru a vă ajuta să optimizați optimizarea pentru motoarele de căutare a site-ului dvs.

Statistici de accesare cu crawlere Google Search Console

Google Search Console a ușurat lucrurile pentru utilizatori, oferind o imagine de ansamblu utilă a practicilor sale. Funcționarea consolei este simplă. Statisticile de accesare cu crawlere vor fi apoi împărțite în trei categorii:

- Kilobytes descărcați pe zi: indică kilobytes descărcați de Googlebots în timpul vizitei site-ului web. Acest lucru indică practic două puncte importante: dacă mediile ridicate sunt afișate în grafic, înseamnă că site-ul este accesat cu crawlere mai des sau poate indica, de asemenea, că botul durează mult să acceseze cu crawlere un site web și nu este ușor.

- Pagini accesate cu crawlere pe zi: vă spune numărul de pagini accesate cu crawlere de Googlebot în fiecare zi. De asemenea, notează starea activității de accesare cu crawlere, indiferent dacă este scăzută, ridicată sau medie. Rata scăzută de accesare cu crawlere indică faptul că site-ul web nu este accesat corect de Googlebot

- Timpul petrecut pentru descărcarea unei pagini (în milisecunde): acesta indică timpul necesar pentru Googlebot pentru a face solicitări HTTP în timpul accesării cu crawlere a site-ului. Mai puțin timpul pe care Googlebot trebuie să-l petreacă pentru a face solicitări, descărcarea paginii va fi mai bine, deoarece indexarea va fi mai rapidă.

Concluzie

Sper că ați obținut multe din acest ghid despre analiza fișierelor jurnal și instrumentele utilizate pentru auditarea fișierelor jurnal pentru SEO. Auditarea fișierelor jurnal poate fi foarte eficientă pentru îmbunătățirea aspectelor tehnice SEO ale site-ului.

Google Search Console și SEMrush Log File Analyzer sunt două opțiuni pentru un instrument de analiză gratuit și de bază. Ca alternativă, verificați Screaming Frog Log File Analyzer, JetOctopus sau Oncrawl Log Analyzer pentru a înțelege mai bine cum interacționează roboții motoarelor de căutare cu site-ul dvs. web; puteți utiliza instrumente mixte premium și gratuite de analiză a fișierelor jurnal pentru SEO.

Puteți, de asemenea, să vă uitați la câteva crawler-uri avansate pentru a îmbunătăți SEO.