Prejudecățile algoritmice pot afecta diferite aspecte ale vieții noastre, de la obținerea de recomandări de conținut online până la găsirea de locuri de muncă și luarea de decizii financiare.

Prejudecata este în natura umană. Oameni diferiți au genuri, rase, educații, medii educaționale, culturi, credințe, experiențe diferite și așa mai departe.

Astfel, opiniile, gândurile, aprecierile și antipatiile și preferințele lor diferă unele de altele. Ei pot dezvolta anumite prejudecăți față de sau împotriva anumitor categorii.

Mașinile nu sunt diferite. De asemenea, aceștia ar putea vedea oamenii, lucrurile și evenimentele în mod diferit din cauza prejudecăților introduse în algoritmii lor. Datorită acestor părtiniri, sistemele AI și ML pot produce rezultate nedrepte, împiedicând oamenii în multe feluri.

În acest articol, voi discuta ce sunt distorsiunile algoritmice, tipurile lor și cum să le detectez și să le reduc pentru a spori corectitudinea rezultatelor.

Sa incepem!

Cuprins

Ce sunt prejudecățile algoritmice?

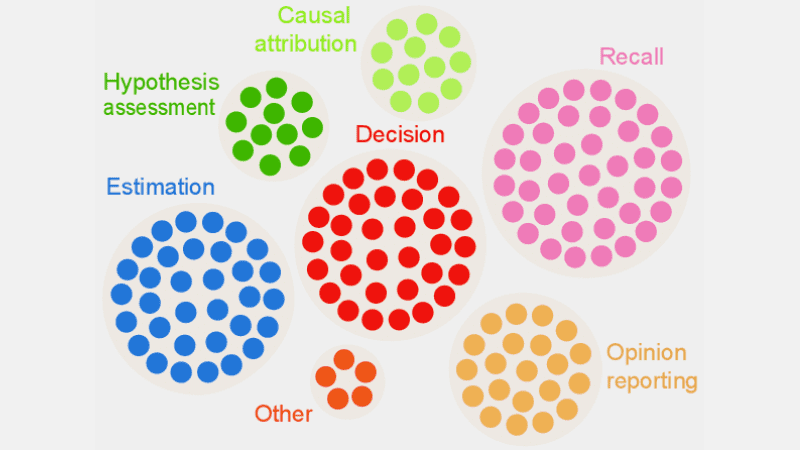

O prejudecată algoritmică este tendința algoritmilor ML și AI de a reflecta părtiniri umane și de a genera rezultate incorecte. Prejudecățile ar putea fi bazate pe gen, vârstă, rasă, religie, etnie, cultură și așa mai departe.

În contextul inteligenței artificiale și al învățării automate, prejudecățile algoritmice sunt erori sistematice, repetabile, introduse într-un sistem care produc rezultate inechitabile.

Prejudecățile algoritmilor pot apărea din mai multe motive, cum ar fi deciziile legate de modul în care datele sunt colectate, alese, codificate sau utilizate în antrenamentul algoritmului, utilizarea prevăzută, proiectarea algoritmului etc.

Exemplu: puteți observa părtinire algoritmică într-un rezultat al unui motor de căutare, ceea ce duce la încălcări ale confidențialității, părtiniri sociale etc.

Există multe cazuri de prejudecăți algoritmice în domenii precum rezultatele alegerilor, răspândirea discursului instigator la ură online, asistența medicală, justiția penală, recrutarea etc. Acest lucru agravează părtinirile existente în materie de gen, rasă, economie și societate.

Tipuri de prejudecăți algoritmice

#1. Disturbirea datelor

Prejudicierea datelor are loc atunci când datele necesare pentru antrenarea unui model AI nu reprezintă în mod corespunzător scenarii sau populații din lumea reală. Acest lucru ar putea duce la seturi de date dezechilibrate sau denaturate.

Sursă: TELUS International

Sursă: TELUS International

Exemplu: Să presupunem că o soluție software de recunoaștere facială este instruită în principal pe populația albă. Deci, poate funcționa slab atunci când este însărcinat să recunoască persoanele cu tonuri de piele mai închise, afectându-i.

#2. Prejudecata de măsurare

Această părtinire poate apărea din cauza unei erori în procesul de măsurare sau de colectare a datelor.

Exemplu: dacă antrenați un algoritm de diagnosticare a asistenței medicale pentru a detecta o boală pe baza unor valori, cum ar fi vizitele anterioare la medic, aceasta poate întuneca raționamentul și poate provoca părtinire în timp ce trece cu vederea simptomele reale.

#3. Model Bias

Prejudecățile modelului apar în timpul proiectării algoritmului sau modelului AI.

Exemplu: Să presupunem că un sistem AI are un algoritm care este conceput pentru a maximiza profiturile, indiferent cum; ar putea ajunge să prioritizeze câștigurile financiare în detrimentul eticii în afaceri, siguranței, corectitudinii etc.

#4. Prejudecata de evaluare

Prejudecățile de evaluare pot apărea atunci când factorii sau criteriile de evaluare a performanței unui sistem AI sunt părtinitoare.

Sursă: Revizuire clară

Sursă: Revizuire clară

Exemplu: Dacă un sistem AI de evaluare a performanței folosește teste standard care favorizează o anumită categorie de angajați dintr-o companie, acesta poate promova inegalitățile.

#5. Prejudecata de raportare

Prejudecățile de raportare pot apărea atunci când setul de date de antrenament nu are o reflectare exactă a realității în frecvența evenimentelor.

Exemplu: dacă un instrument de securitate AI nu funcționează bine într-o anumită categorie, poate semnala întreaga categorie ca suspectă.

Aceasta înseamnă că setul de date pe care a fost antrenat sistemul a marcat fiecare incident istoric legat de acea categorie ca nesigur din cauza frecvenței mai mari a incidentelor.

#6. Prejudecata de selecție

Prejudecățile de selecție apare atunci când datele de antrenament sunt selectate fără o randomizare adecvată sau nu reprezintă bine populația totală.

Exemplu: dacă un instrument de recunoaștere facială este instruit pe date limitate, poate începe să arate o anumită discriminare față de datele pe care le întâmpină mai puțin, cum ar fi identificarea femeilor de culoare în politică decât cea a bărbaților și a persoanelor cu pielea mai deschisă în politică.

#7. Prejudecată implicită

Prejudecățile implicite apar atunci când algoritmul AI face presupuneri bazate pe anumite experiențe personale, care s-ar putea să nu se aplice în mod explicit unor categorii mai largi sau persoanelor.

Exemplu: dacă un cercetător de date care proiectează un algoritm de inteligență artificială crede personal că femeilor le place în primul rând rozul și nu albastrul sau negrul, sistemul poate recomanda produse în consecință, ceea ce nu se aplică fiecărei femei. Mulți iubesc albastrul sau negru.

#8. Prejudecata de atribuire a grupului

Această părtinire se poate întâmpla atunci când proiectanții de algoritmi aplică lucruri care sunt destinate anumitor indivizi unui grup complet, indiferent dacă acești indivizi fac parte din grup sau nu. Prejudecățile de atribuire a grupului sunt frecvente în instrumentele de recrutare și admitere.

Exemplu: un instrument de admitere poate favoriza candidații dintr-o anumită școală, discriminând alți elevi care nu aparțin acelei școli.

#9. Prejudecată istorică

Colectarea seturilor de date istorice este importantă atunci când se colectează seturi de date pentru antrenarea unui algoritm ML. Dar dacă nu acordați atenție, pot apărea părtiniri în algoritmii dvs. din cauza părtinirilor prezente în datele dvs. istorice.

Exemplu: dacă antrenați un model AI cu date istorice de 10 ani pentru a lista candidați pentru posturi tehnice, ar putea fi în favoarea candidaților bărbați dacă datele de formare includ mai mulți bărbați decât femei.

#10. Eticheta Bias

În timp ce antrenați algoritmi ML, s-ar putea să fie nevoie să etichetați o mulțime de date pentru a le face utile. Cu toate acestea, procesul de etichetare a datelor poate varia foarte mult, generând inconsecvențe și introducând părtiniri în sistemul AI.

Exemplu: Să presupunem că antrenați un algoritm AI prin etichetarea pisicilor în imagini folosind casete. Dacă nu acordați atenție, algoritmul ar putea eșua în identificarea unei pisici într-o imagine dacă fața acesteia nu este vizibilă, dar le poate identifica pe cele cu fețe de pisică pe ea.

Aceasta înseamnă că algoritmul este părtinitor în identificarea imaginilor cu pisici cu fața în față. Nu poate identifica pisica dacă imaginea este luată dintr-un unghi diferit atunci când apare corpul, dar nu și fața.

#11. Prejudecata de excludere

Sursă: ResearchGate

Sursă: ResearchGate

Prejudecățile de excludere apare atunci când o anumită persoană, un grup de persoane sau o categorie este exclusă neintenționat sau intenționat în timpul colectării datelor, dacă se consideră că acestea sunt irelevante. Se întâmplă mai ales în timpul etapei de pregătire a datelor din ciclul de viață ML, în momentul curățării datelor și pregătirii lor pentru utilizare.

Exemplu: Să presupunem că un sistem de predicție bazat pe inteligență artificială trebuie să determine popularitatea unui anumit produs în timpul sezonului de iarnă, pe baza ratei sale de achiziție. Deci, dacă un cercetător de date observă unele achiziții în octombrie și elimină acele înregistrări, considerând că sunt eronate și luând durata standard din noiembrie până în ianuarie. Dar există locuri în care iarna depășește acele luni. Deci, algoritmul va fi orientat către țările care primesc iarna din noiembrie până în ianuarie.

Cum sunt introduse prejudecățile în algoritmi?

Date de antrenament

Principala sursă de părtinire algoritmică sunt datele părtinitoare utilizate pentru antrenarea algoritmilor AI și ML. Dacă datele de antrenament în sine au elemente de inegalități și prejudecăți, algoritmul va învăța acele elemente și va perpetua prejudecățile.

Proiecta

Atunci când proiectează algoritmul, dezvoltatorul poate introduce în știință sau fără să știe reflectările gândurilor sau preferințelor personale în sistemul AI. Deci, sistemul AI va fi orientat către anumite categorii.

Luarea deciziilor

De multe ori, oamenii de știință ai datelor și liderii iau decizii pe baza experiențelor personale, a împrejurimilor, a convingerilor și așa mai departe. Aceste decizii se reflectă și în algoritmi, ceea ce provoacă părtiniri.

Lipsa de diversitate

Din cauza lipsei de diversitate în echipa de dezvoltare, membrii echipei ajung să creeze algoritmi care nu reprezintă întreaga populație. Ei nu au experiență sau expunere la alte culturi, medii, credințe, moduri etc., motiv pentru care algoritmii lor pot fi părtinși într-un anumit fel.

Preprocesarea datelor

Metoda utilizată pentru curățarea și procesarea datelor poate introduce părtinire algoritmică. În plus, dacă nu proiectați aceste metode cu atenție pentru a contracara prejudecățile, s-ar putea să devină grav în modelul AI.

Arhitectură

Arhitectura modelului și tipul de algoritm ML pe care îl alegeți pot introduce, de asemenea, părtinire. Unii algoritmi atrag părtinire mai mult decât alții, împreună cu modul în care sunt proiectați.

Selectarea caracteristicilor

Funcțiile pe care le-ați ales pentru a antrena un algoritm AI sunt una dintre cauzele părtinirii. Dacă nu alegeți caracteristicile ținând cont de impactul acestora asupra corectitudinii rezultatelor, pot apărea anumite părtiniri, favorizând anumite categorii.

Istorie și Cultură

Dacă un algoritm este alimentat și antrenat cu date preluate din istorie sau din anumite culturi, acesta poate moșteni părtiniri precum prejudecăți, credințe, norme etc. Aceste părtiniri pot afecta rezultatele AI chiar dacă sunt nedrepte și irelevante în prezent.

Deriva datelor

Datele pe care le utilizați astăzi pentru antrenamentul algoritmilor AI ar putea deveni irelevante, inutile sau învechite în viitor. Acest lucru s-ar putea datora schimbării tehnologiei sau societății. Cu toate acestea, aceste seturi de date pot încă introduce părtiniri și pot împiedica performanța.

Bucle de feedback

Unele sisteme AI nu numai că pot comunica cu utilizatorii, ci și se pot adapta la comportamentele acestora. În acest fel, algoritmul poate stimula părtinirea existentă. Deci, atunci când părtinirile personale ale utilizatorilor intră în sistemul AI, acesta poate genera o buclă de feedback părtinitoare.

Cum se detectează părtinirea algoritmică?

Definiți ce este „echitabil”

Pentru a detecta rezultate nedrepte sau părtiniri în algoritmi, trebuie să definiți ce implică exact „echitabil” pentru sistemul AI. Pentru aceasta, puteți lua în considerare factori precum sexul, vârsta, rasa, sexualitatea, regiunea, cultura etc.

Determinați parametrii pentru a calcula corectitudinea, cum ar fi egalitatea de șanse, paritatea predictivă, impactul etc. Odată ce ați definit „echitatea”, vă devine mai ușor să detectați ceea ce nu este corect și să rezolvați situația.

Date de instruire de audit

Analizați-vă cu atenție datele de antrenament pentru a căuta dezechilibre și inconsecvențe în reprezentarea diferitelor categorii. Trebuie să examinați distribuția caracteristicilor și să verificați dacă reprezintă sau nu datele demografice din lumea reală.

Pentru vizualizarea datelor, puteți crea histograme, hărți termice, diagrame de dispersie etc. pentru a evidenția disparitățile și modelele care nu pot fi dezvăluite doar cu ajutorul analizei statistice.

În afară de auditurile interne, puteți implica experți externi și auditori pentru a evalua părtinirea sistemului.

Măsurați performanța modelului

Pentru a detecta părtiniri, încercați să măsurați performanța modelului dvs. AI pentru diferite categorii demografice și categorii. Ar fi de ajutor dacă împărțiți antrenamentul în diferite grupuri în funcție de rasă, sex etc. Puteți utiliza, de asemenea, valorile de corectitudine pentru a calcula diferențele dintre rezultate.

Utilizați algoritmi adecvați

Alegeți algoritmi care promovează rezultate corecte și care pot aborda prejudecățile în formarea unui model AI. Algoritmii conștienți de corectitudine urmăresc să prevină prejudecățile, asigurând în același timp predicții egale în diferite categorii.

Software de detectare a părtinirii

Puteți utiliza instrumente și biblioteci specializate care sunt conștiente de corectitudine pentru a detecta părtinirile. Aceste instrumente oferă valori de corectitudine, vizualizări, teste statistice și multe altele pentru a detecta părtinirea. Unele populare sunt AI Fairness 360 și IBM Fairness 360.

Căutați feedbackul utilizatorului

Cereți utilizatorilor și clienților feedback-ul lor despre sistemul AI. Încurajați-i să-și dea recenzii sincere dacă au simțit vreun fel de tratament nedrept sau părtinire în sistemul AI. Aceste date vă vor ajuta să identificați problemele care ar putea să nu fie semnalate în instrumentele automate și alte proceduri de detectare.

Cum să reduceți părtinirea în algoritmi

Diversifică-ți compania

Crearea diversității în compania dvs. și în echipa de dezvoltare permite detectarea și eliminarea mai rapidă a părtinirilor. Motivul este că părtinirile pot fi observate rapid de utilizatorii care sunt afectați de acestea.

Așadar, diversificați-vă compania nu numai în demografie, ci și în abilități și expertiză. Includeți persoane de diferite genuri, identități, rase, culori ale pielii, medii economice etc., precum și persoane cu experiențe și medii educaționale diferite.

În acest fel, veți ajunge să colectați perspective, experiențe, valori culturale, aprecieri și antipatii, etc. Acest lucru vă va ajuta să îmbunătățiți corectitudinea algoritmilor dvs. AI, reducând părtinirile.

Promovați transparența

Fii transparent cu echipa ta cu privire la obiectiv, algoritmi, surse de date și decizii cu privire la un sistem AI. Acest lucru va permite utilizatorilor să înțeleagă cum funcționează sistemul AI și de ce generează anumite rezultate. Această transparență va stimula încrederea.

Algoritmi conștienți de corectitudine

Utilizați algoritmi conștienți de corectitudine atunci când dezvoltați modelul pentru a vă asigura că sunt generate rezultate corecte pentru diferite categorii. Acest lucru devine evident dacă creați sisteme AI pentru industrii foarte reglementate, cum ar fi finanțele, sănătatea etc.

Evaluați performanța modelului

Testați-vă modelele pentru a examina performanța AI în diferite grupuri și subgrupuri. Vă va ajuta să înțelegeți problemele care nu sunt vizibile în valorile agregate. De asemenea, puteți simula diferite scenarii pentru a le verifica performanța în acele scenarii, inclusiv în cele complexe.

Urmați orientările etice

Formulați câteva linii directoare etice pentru dezvoltarea sistemelor AI, respectând corectitudinea, confidențialitatea, siguranța și drepturile omului. Trebuie să aplicați aceste orientări în întreaga organizație, astfel încât corectitudinea să crească la nivelul întregii organizații și să se reflecte în rezultatele sistemului AI.

Stabiliți controale și responsabilități

Stabiliți responsabilități clare pentru toți cei din echipa care lucrează la proiectarea, dezvoltarea, întreținerea și implementarea sistemului AI. De asemenea, trebuie să setați controale adecvate cu protocoale și cadre stricte pentru a aborda părtiniri, erori și alte preocupări.

În afară de cele de mai sus, trebuie să efectuați audituri regulate pentru a reduce părtinirile și pentru a depune eforturi pentru îmbunătățiri continue. De asemenea, fiți la curent cu schimbările recente în tehnologie, demografie și alți factori.

Exemple din lumea reală de prejudecăți algoritmice

#1. Algoritmul Amazon

Amazon este lider în industria comerțului electronic. Cu toate acestea, ea instrument de recrutare care a folosit AI pentru evaluarea candidaților de locuri de muncă în funcție de calificările lor au arătat părtinire de gen. Acest sistem AI a fost instruit folosind CV-urile candidaților anteriori în rolurile tehnice.

Din păcate, datele au avut un număr mai mare de aplicanți bărbați, lucru pe care AI a aflat. Așadar, a favorizat în mod neintenționat candidații bărbați în roluri tehnice față de femeile care erau subreprezentate. Amazon a trebuit să întrerupă instrumentul în 2017, în ciuda eforturilor de a reduce părtinirea.

#2. Algoritmi rasişti de asistenţă medicală din SUA

Un algoritm pe care spitalele din SUA l-au folosit pentru a prognoza pacienții care au nevoie de îngrijiri suplimentare a fost puternic părtinitoare față de pacienții albi. Sistemul a evaluat nevoile medicale ale pacienților pe baza istoricului lor de cheltuieli cu asistența medicală, corelând costul cu nevoile medicale.

Algoritmul sistemului nu a luat în considerare modul în care pacienții albi și negri au plătit pentru nevoile lor de asistență medicală. În ciuda bolilor necontrolate, pacienții negri plăteau mai ales pentru urgențe. Astfel, ei au fost clasificați drept pacienți mai sănătoși și nu se calificau pentru îngrijire suplimentară în comparație cu pacienții albi.

#3. Algoritmul de discriminare Google

Sistemul de anunțuri online al Google a fost găsit discriminare. A arătat poziții bine plătite, cum ar fi CEO-uri, bărbaților semnificativ mai mari decât femeilor. Chiar dacă 27% dintre directorii executivi din SUA sunt femei, reprezentarea acestora este mult mai mică în Google, în jur de 11%.

Algoritmul ar fi putut arăta rezultatul prin învățarea comportamentului utilizatorului, cum ar fi oamenii care vizionează și dă clic pe reclame pentru roluri bine plătite sunt bărbați; algoritmul AI va afișa aceste reclame bărbaților mai mult decât femeilor.

Concluzie

Prejudecățile algoritmice în sistemele ML și AI pot duce la rezultate nedrepte. Aceste rezultate pot avea impact asupra persoanelor din diferite domenii, de la asistență medicală, securitate cibernetică și comerț electronic până la alegeri, angajare și multe altele. Poate duce la discriminare pe criterii de gen, rasă, demografie, orientare sexuală și alte aspecte.

Prin urmare, este important să se reducă părtinirile în algoritmii AI și ML pentru a promova corectitudinea rezultatelor. Informațiile de mai sus vă vor ajuta să detectați părtinirile și să le reduceți, astfel încât să puteți crea sisteme AI corecte pentru utilizatori.

Puteți citi și despre guvernarea AI.