Cât de des folosești un chatbot sau un robot bazat pe inteligență artificială (IA) pentru a-ți îndeplini sarcinile sau pentru a găsi răspunsuri la întrebările tale?

Dacă răspunsul tău este „foarte des!” sau „mereu!”, ar trebui să fii puțin îngrijorat 😟.

Indiferent dacă ești un student care se bazează constant pe roboți IA pentru a-ți cerceta lucrările sau un programator care încearcă să genereze cod exclusiv cu ajutorul IA, posibilitatea unor erori în rezultatele generate de IA este destul de mare, mai ales din cauza inconsecvențelor sau a datelor false din seturile de date folosite pentru instruirea inteligenței artificiale.

Deși modelele de IA și învățare automată (ML) transformă lumea, preluând sarcini repetitive și rezolvând multe probleme prin automatizare, mai au încă de lucru când vine vorba de generarea unor rezultate precise, bazate pe cerințele specifice.

Dacă folosești un generator de conținut sau un chatbot suficient timp, vei observa că uneori primești răspunsuri greșite, irelevante sau pur și simplu inventate. Aceste situații sunt numite halucinații sau confabulații ale IA și sunt o problemă serioasă pentru organizațiile și persoanele care se bazează pe roboții IA generativi.

Fie că ai întâmpinat sau nu halucinații ale inteligenței artificiale și vrei să afli mai multe, acest articol explorează profund acest subiect. Vom analiza ce înseamnă halucinația IA, de ce apare, exemple și dacă poate fi corectată.

Să începem!

Ce este halucinația IA?

O halucinație IA apare atunci când un model IA sau un model lingvistic mare (LLM) generează informații false, incorecte sau lipsite de logică. Modelul IA produce un răspuns cu încredere, dar care nu se potrivește sau nu are legătură cu datele de antrenament și prezintă informațiile ca fiind adevărate, chiar dacă nu au sens logic sau raționament!

Se spune că a greși este omenește!😅

Instrumentele și modelele IA, precum ChatGPT, sunt de obicei antrenate să prezică cuvintele care se potrivesc cel mai bine cu solicitarea dată. Deși adesea generează răspunsuri corecte și precise, uneori, acest algoritm îi face să piardă din vedere raționamentul, determinând chatbot-urile să ofere inconsistențe factuale și afirmații false.

Cu alte cuvinte, modelele IA uneori „halucinează” răspunsul, încercând să te mulțumească (pe utilizator) – dorind să fie mai părtinitoare, selective, specializate sau suficiente.

Halucinațiile IA pot varia de la mici inconsecvențe la răspunsuri complet false sau fabricate. Iată câteva tipuri de halucinații IA pe care le poți întâlni:

#1. Contradicția propoziției: Se întâmplă atunci când un model LLM generează o propoziție care contrazice complet o afirmație anterioară.

#2. Contradicție factuală: Acest tip de halucinație apare când modelul IA prezintă informații false sau fictive ca fiind adevărate.

#3. Contradicție a solicitării: Acest tip de halucinație se produce când rezultatul contrazice cerința pentru care generează o ieșire. De exemplu, dacă cerința este „Scrie o invitație pentru prietenii mei la petrecerea mea de ziua de naștere”, modelul poate genera un mesaj ca „La mulți ani, mamă și tată”.

#4. Halucinații aleatorii sau irelevante: Această halucinație apare atunci când modelul generează un răspuns total irelevant pentru cerința inițială. De exemplu, dacă întrebarea este „Ce este special la New York?”, poți primi un mesaj ca: „New York este unul dintre cele mai aglomerate orașe din America. Câinii sunt cele mai loiale animale și cel mai bun prieten al omului.”

Citește și: Cum inteligența artificială generativă schimbă motoarele de căutare

Exemple de halucinații IA

Halucinațiile IA au avut câteva exemple și incidente notabile pe care nu trebuie să le ignori. Iată câteva exemple cunoscute de halucinații IA:

- Chatbot-ul Google, Bard, a afirmat în mod eronat că telescopul spațial James Webb a obținut primele imagini din lume ale unei planete extrasolare care nu aparține sistemului nostru solar.

- Demo-ul Meta LLM, Galactica, din 2022, conceput pentru studenți și cercetători în știință, a oferit utilizatorilor informații inexacte și o lucrare falsă când a fost solicitat să scrie o lucrare despre crearea de avatare.

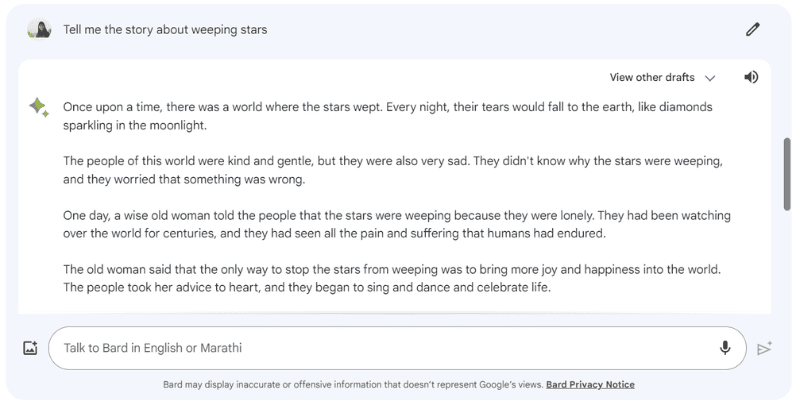

Iată un exemplu în care Google Bard a halucinat un răspuns când l-am întrebat „Spune-mi povestea stelelor plângătoare”, care de fapt nu există.

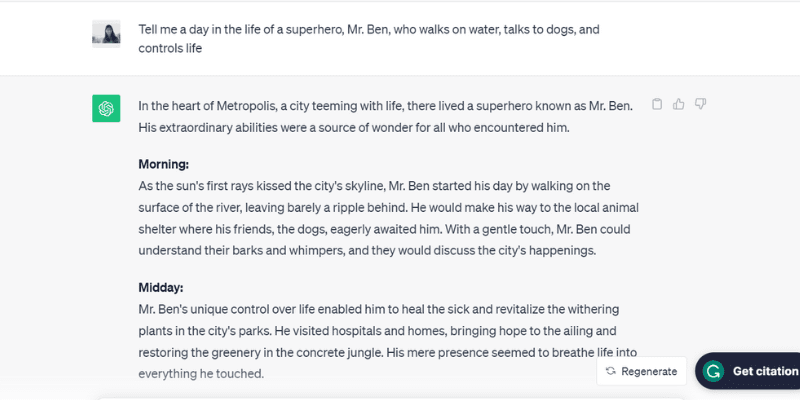

Iată un alt exemplu testat cu ChatGPT (GPT-3.5), care a vorbit despre o persoană fictivă, domnul Ben, când i-am cerut: „Povestește o zi din viața unui supererou, domnul Ben, care merge pe apă, vorbește cu câinii și controlează viața.”

ChatGPT a creat o întreagă zi, de dimineață până seara, pentru domnul Ben, care de fapt nu există, dar a jucat rolul solicitat, care este unul dintre motivele pentru care apar halucinațiile IA.

Vorbește despre a fi prea dornic să te mulțumească!

Ei bine, care sunt motivele? Să analizăm câteva cauze care duc la halucinații ale IA.

De ce apar halucinațiile IA?

Există mai multe motive tehnice și cauze pentru halucinațiile IA. Iată câteva posibile motive:

- Date de calitate slabă, insuficiente sau învechite: Modelele LLM și IA se bazează foarte mult pe datele de instruire. Prin urmare, sunt la fel de bune ca datele pe care sunt antrenate. Dacă instrumentul IA are erori, inconsecvențe, părtiniri sau date ineficiente în setul de date, sau dacă nu înțelege solicitarea, va genera halucinații IA, deoarece instrumentul produce o ieșire din setul limitat de date.

- Supraadaptare: Antrenat pe un set limitat de date, modelul IA poate încerca să memoreze cerințele și rezultatele corespunzătoare, ceea ce îl face incapabil să genereze sau să generalizeze eficient noi date, ducând la halucinații IA.

- Context de intrare: Halucinațiile IA pot apărea și din cauza unor solicitări neclare, incorecte, inconsecvente sau contradictorii. Deși setul de date de instruire al modelului IA nu este controlat de utilizatori, datele introduse de utilizator ca cerință sunt. Prin urmare, este esențial să oferi instrucțiuni clare pentru a evita halucinațiile IA.

- Folosirea expresiilor idiomatice sau a jargonului: Dacă cerința conține expresii idiomatice sau jargon, șansele de halucinații IA sunt mari, mai ales dacă modelul nu este antrenat pentru astfel de cuvinte sau expresii.

- Atacuri adversare: Uneori, atacatorii introduc în mod deliberat solicitări menite să confuze modelele IA, corupându-le datele de instruire și ducând la halucinații IA.

Implicațiile negative ale halucinațiilor IA

Halucinațiile IA reprezintă preocupări etice majore, cu consecințe semnificative pentru indivizi și organizații. Iată motivele pentru care halucinațiile IA sunt o problemă majoră:

- Răspândirea dezinformării: Halucinațiile IA cauzate de cerințe incorecte sau inconsecvențe în datele de instruire pot duce la răspândirea în masă a dezinformării, afectând o gamă largă de indivizi, organizații și agenții guvernamentale.

- Neîncrederea utilizatorilor: Când dezinformarea creată de IA se răspândește ca un incendiu pe internet, făcând-o să pară autoritară și scrisă de oameni, erodează încrederea unui utilizator, făcând dificilă încrederea în informațiile de pe internet.

- Prejudicii pentru utilizatori: Pe lângă preocupările etice și înșelarea oamenilor, halucinațiile IA pot dăuna oamenilor prin răspândirea de informații greșite despre unele probleme și subiecte grave, cum ar fi boli, tratamentele acestora sau sfaturi simple pentru a distinge o ciupercă comestibilă de una otrăvitoare. Chiar și o mică dezinformare sau inexactitate poate pune în pericol viața unei persoane.

Cele mai bune practici pentru a detecta și a preveni halucinațiile IA

Având în vedere implicațiile negative ale halucinațiilor IA, prevenirea lor este crucială. În timp ce companiile care dețin aceste modele IA lucrează pentru a elimina sau reduce halucinațiile IA, este important să luăm măsuri de precauție și noi, ca utilizatori.

Pe baza cercetărilor, a experienței și a încercărilor și erorilor, am inclus câteva strategii pentru a detecta și preveni halucinațiile IA data viitoare când folosești un chatbot sau interacționezi cu un model lingvistic mare (LLM).

#1. Utilizează date de antrenament reprezentative și diversificate

Ca utilizator, este esențial să folosești LLM-uri cu un set divers de date de instruire care să reprezinte realitatea, reducând șansele ca rezultatele să fie părtinitoare, incorecte sau inventate.

În același timp, companiile trebuie să se asigure că actualizează și extind seturile de date de instruire ale modelelor IA în mod regulat, pentru a ține cont și a fi la curent cu evenimentele culturale, politice și alte evenimente în continuă evoluție.

#2. Limitează rezultatele sau răspunsurile

Ca utilizator, poți limita numărul de răspunsuri pe care un instrument IA le poate genera, oferindu-i o cerință specifică despre tipul de răspuns pe care îl dorești.

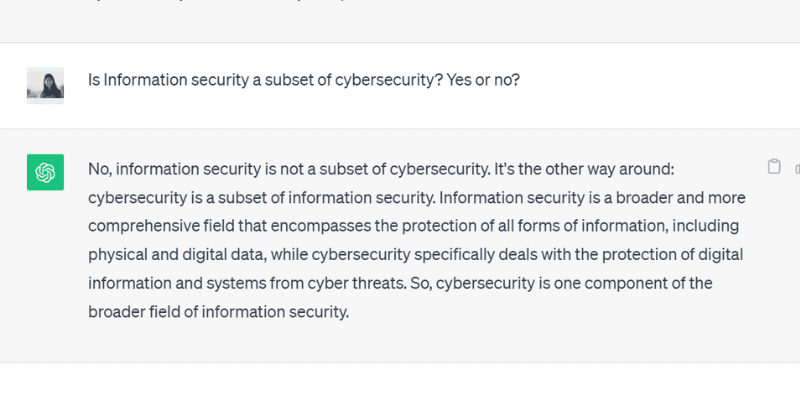

De exemplu, poți cere în mod specific și comanda modelului să răspundă doar cu da sau nu. Sau poți oferi mai multe opțiuni în cerință pentru ca instrumentul să aleagă, limitând posibilitatea de a se abate de la răspunsul corect și de a avea halucinații.

Când am pus o întrebare ChatGPT GPT 3.5 cu un răspuns de tip da sau nu, a generat acest rezultat corect:

#3. Împachetează și bazează modelul cu date relevante

Nu te poți aștepta ca o persoană să ofere o soluție la o problemă sau întrebare fără cunoștințe prealabile sau fără a oferi un context specific. În mod similar, un model de inteligență artificială este la fel de bun ca setul de date de instruire pe care l-ai furnizat.

Bazărea datelor de instruire ale unui model IA cu informații relevante și specifice industriei oferă modelului un context și puncte de date suplimentare. Acest context suplimentar ajută modelul IA să-și îmbunătățească înțelegerea, permițându-i să genereze răspunsuri precise, sensibile și contextuale, în loc de răspunsuri halucinate.

#4. Creează șabloane de date pentru ca modelul IA să le urmeze

Furnizarea unui șablon de date sau a unui exemplu de formulă specifică sau de calcul într-un format predefinit poate ajuta modelul IA să genereze răspunsuri precise, aliniate cu instrucțiunile prescrise.

Bazându-se pe ghiduri și șabloane de date, reduce probabilitatea de halucinație a modelelor IA și asigură consistența și acuratețea răspunsurilor generate. Astfel, furnizarea unui model de referință sub formă de tabel sau exemplu poate ghida modelul IA în calcule, eliminând cazurile de halucinații.

#5. Fii foarte specific cu solicitarea, atribuind modelului un rol specific

Atribuirea unor roluri specifice modelului IA este una dintre cele mai inteligente și eficiente modalități de a preveni halucinațiile. De exemplu, poți da instrucțiuni ca „Ești un chitarist priceput și experimentat” sau „Ești un matematician genial”, urmată de întrebarea ta.

Atribuirea rolurilor ghidează modelul să ofere răspunsul dorit, în loc de răspunsuri halucinate, inventate.

Și nu-ți face griji. Te poți distra în continuare cu IA (fără a genera halucinații). Află cum să creezi singur artă virală în spirală cu IA!

#6. Testează-l cu temperatura

Temperatura joacă un rol important în a determina nivelul de halucinații sau de răspunsuri creative pe care un model IA le poate genera.

În timp ce o temperatură mai scăzută înseamnă de obicei rezultate deterministe sau previzibile, o temperatură mai mare crește șansele ca modelul IA să genereze răspunsuri aleatorii și să halucineze.

Multe companii de IA oferă o bară sau un glisor „Temperatură” cu instrumentele lor, pentru ca utilizatorii să ajusteze setările de temperatură conform preferințelor.

În același timp, companiile pot seta o temperatură implicită, permițând instrumentului să genereze răspunsuri sensibile și atingând un echilibru corect între acuratețe și creativitate.

#7. Verifică întotdeauna

În cele din urmă, să te bazezi 100% pe o ieșire generată de IA, fără o verificare suplimentară, nu este o decizie înțeleaptă.

În timp ce companiile și cercetătorii IA încearcă să rezolve problema halucinațiilor și să dezvolte modele care să prevină această problemă, ca utilizator, este esențial să verifici răspunsurile generate de un model IA, înainte de a le folosi sau de a le accepta complet.

Așadar, pe lângă folosirea celor mai bune practici menționate mai sus, de la formularea unei cerințe specifice până la adăugarea de exemple în cerință pentru a ghida IA, trebuie să verifici întotdeauna rezultatul generat de modelul IA.

Se pot remedia sau elimina complet halucinațiile IA? Opinia unui expert

Deși controlul halucinațiilor IA depinde de cerințele pe care le oferim, uneori, modelul generează rezultate cu atâta încredere, încât este dificil să deosebești ce este fals de ce este adevărat.

Deci, este posibil să se remedieze sau să se prevină complet halucinațiile IA?

Când a fost pusă această întrebare, Suresh Venkatasubramanian, profesor la Universitatea Brown, a răspuns că posibilitatea de a preveni sau nu halucinațiile IA este un „punct de cercetare activă”.

Motivul pentru aceasta, a explicat el în continuare, este natura acestor modele IA – cât de complexe, complicate și fragile sunt aceste modele IA. Chiar și o modificare minoră a cerinței poate schimba semnificativ rezultatele.

În timp ce Venkatasubramanian consideră că rezolvarea problemei halucinațiilor IA este un punct de cercetare, Jevin West, profesor la Universitatea din Washington și co-fondator al Centrului pentru un Public Informat, consideră că halucinațiile IA nu vor dispărea niciodată.

West crede că este imposibil să retragi halucinațiile care apar din roboții IA sau chatbot-uri. Și, prin urmare, halucinațiile IA ar putea fi mereu prezente ca o caracteristică intrinsecă a inteligenței artificiale.

În plus, Sundar Pichai, CEO-ul Google, a declarat într-un interviu cu CBS că toți cei care folosesc IA se confruntă cu halucinații, dar nimeni din industrie nu a rezolvat încă această problemă. Aproape toate modelele IA se confruntă cu această problemă. În continuare, el a susținut că domeniul IA va progresa în curând când vine vorba de depășirea halucinațiilor IA.

În același timp, Sam Altman, CEO-ul OpenAI, producătorul ChatGPT, a vizitat Institutul de Tehnologia Informației Indraprastha din Delhi, India, în iunie 2023, unde a remarcat că problema halucinațiilor IA va fi într-un loc mult mai bun într-un an sau doi.

El a adăugat că modelul ar trebui să învețe diferența dintre acuratețe și creativitate și când să folosească una sau alta.

Concluzie

Halucinațiile IA au atras multă atenție în ultimii ani și sunt un domeniu de interes pentru companiile și cercetătorii care încearcă să le rezolve și să le depășească cât mai curând posibil.

Deși IA a făcut progrese remarcabile, nu este imună la erori, iar problema halucinațiilor IA ridică provocări majore pentru mai multe persoane și industrii, inclusiv sănătatea, generarea de conținut și industria auto.

În timp ce cercetătorii își fac treaba, este responsabilitatea noastră ca utilizatori să oferim instrucțiuni specifice și precise, să adăugăm exemple și să furnizăm șabloane de date pentru a obține răspunsuri corecte și logice, pentru a evita să ne încurcăm cu datele de instruire ale modelului IA și pentru a preveni halucinațiile.

Chiar dacă halucinațiile IA pot fi complet vindecate sau rezolvate, rămâne o întrebare; eu personal cred că există speranță și putem continua să folosim sisteme IA pentru a beneficia lumea în mod responsabil și în siguranță.

În continuare, exemple de inteligență artificială (IA) în viața noastră de zi cu zi.