Dezvoltarea unui model de învățare automată nu este o sarcină complicată, însă gestionarea și repetarea a sute sau chiar mii de modele reprezintă o provocare majoră.

Este foarte ușor să te pierzi într-un haos informațional. Această problemă devine și mai complexă atunci când se lucrează într-o echipă, deoarece este necesară coordonarea tuturor membrilor și monitorizarea activităților. Pentru a aduce ordine în acest haos, este esențial ca întreaga echipă să adopte un proces bine definit și să documenteze fiecare etapă a activității. Aceasta este ideea centrală a MLOps.

Ce reprezintă MLOps?

Sursa: ml-ops.org

Conform MLOps.org, Operaționalizarea Învățării Automate (MLOps) are scopul de a crea un proces complet de dezvoltare a învățării automate, care să permită proiectarea, construirea și gestionarea software-ului ML într-un mod reproductibil, testabil și scalabil. În esență, MLOps reprezintă aplicarea principiilor DevOps în domeniul învățării automate.

La fel ca în cazul DevOps, ideea fundamentală a MLOps este automatizarea, menită să reducă intervențiile manuale și să sporească eficiența. Similar cu DevOps, MLOps include Integrarea Continuă (CI) și Livrarea Continuă (CD). În plus, adaugă și Instruirea Continuă (CT), un aspect esențial care presupune reantrenarea modelelor cu date noi și redestribuirea lor.

Așadar, MLOps reprezintă o cultură inginerească care promovează o abordare metodică în dezvoltarea modelelor de învățare automată, automatizând diverse etape ale procesului. Acesta include, în principal, extragerea, analiza, pregătirea datelor, instruirea modelului, evaluarea, implementarea și monitorizarea continuă a acestuia.

Beneficiile MLOps

În general, avantajele aplicării principiilor MLOps sunt similare cu beneficiile obținute prin utilizarea Procedurilor Standard de Operare. Aceste avantaje includ:

- Un proces bine definit oferă o structură clară, detaliind toți pașii importanți în dezvoltarea unui model. Acest lucru asigură că nu sunt omise etape cruciale.

- Procesul facilitează identificarea etapelor care pot fi automatizate, reducând astfel munca repetitivă și accelerând dezvoltarea. Automatizarea reduce erorile umane și efortul necesar.

- Evaluarea progresului în dezvoltarea unui model devine mai simplă, știind exact în ce stadiu al procesului se află.

- Comunicarea între echipe este îmbunătățită, deoarece există un limbaj comun pentru fiecare etapă a dezvoltării.

- Procesul poate fi aplicat în mod repetat pentru dezvoltarea a numeroase modele, oferind o modalitate eficientă de gestionare a complexității.

În concluzie, rolul MLOps în învățarea automată este de a oferi o abordare sistematică, care să permită automatizarea cât mai multor aspecte ale dezvoltării modelelor.

Platforme pentru crearea de conducte

Pentru a facilita implementarea MLOps în fluxurile de lucru, există numeroase platforme. Deși acestea pot varia în funcționalități, scopul lor principal este de a ajuta în următoarele:

- Stocarea tuturor modelelor împreună cu metadatele relevante (configurații, cod, acuratețe, rezultate ale experimentelor). Platformele includ și gestionarea versiunilor modelelor.

- Stocarea metadatelor seturilor de date, inclusiv informații despre datele utilizate pentru instruirea modelelor.

- Monitorizarea modelelor în producție pentru identificarea problemelor, precum deriva modelului.

- Implementarea modelelor în medii de producție.

- Dezvoltarea de modele folosind medii low-code sau no-code.

Să analizăm cele mai performante platforme MLOps.

MLFlow

MLFlow este o platformă populară pentru gestionarea ciclului de viață al învățării automate. Este o soluție gratuită și open-source, care oferă:

- Urmărirea experimentelor de învățare automată, incluzând codul, datele, configurațiile și rezultatele.

- Proiecte pentru ambalarea codului într-un format ușor de reprodus.

- Capabilități de implementare pentru modelele de învățare automată.

- Un registru pentru stocarea centralizată a tuturor modelelor.

MLFlow se integrează cu biblioteci populare de învățare automată precum TensorFlow și PyTorch, precum și cu platforme precum Apache Spark, H20.ai, Google Cloud, Amazon Sage Maker, Azure Machine Learning și Databricks. De asemenea, funcționează cu diferiți furnizori de cloud, printre care AWS, Google Cloud și Microsoft Azure.

Azure Machine Learning

Azure Machine Learning este o platformă end-to-end pentru învățarea automată, gestionând diversele activități ale ciclului de viață MLOP. Aceste activități includ pregătirea datelor, construirea și antrenarea modelelor, validarea și implementarea, precum și gestionarea și monitorizarea implementărilor.

Azure Machine Learning vă permite să construiți modele folosind IDE-ul și framework-ul preferat, cum ar fi PyTorch sau TensorFlow.

De asemenea, se integrează cu ONNX Runtime și Deepspeed pentru a optimiza antrenamentul și inferența, îmbunătățind performanța. Utilizează infrastructura AI de pe Microsoft Azure, combinând GPU-urile NVIDIA și rețeaua Mellanox pentru a facilita construirea de clustere de învățare automată. Cu AML, puteți crea un registru central pentru a stoca și partaja modele și seturi de date.

Azure Machine Learning se integrează cu Git și GitHub Actions pentru a crea fluxuri de lucru. Suportă o configurare hibridă sau multi-cloud și poate fi integrat cu alte servicii Azure, precum Synapse Analytics, Data Lake, Databricks și Security Center.

Google Vertex AI

Google Vertex AI este o platformă unificată de date și inteligență artificială, oferind instrumentele necesare pentru construirea de modele personalizate și pre-antrenate. De asemenea, servește ca o soluție end-to-end pentru implementarea MLOps. Integrarea cu BigQuery, Dataproc și Spark facilitează accesul la date în timpul antrenamentului.

Pe lângă API, Google Vertex AI oferă un mediu de instrumente low-code și no-code, fiind accesibil atât dezvoltatorilor, cât și analiștilor, inginerilor de afaceri și de date. API-ul permite dezvoltatorilor să integreze platforma cu sistemele existente.

Google Vertex AI facilitează crearea de aplicații AI generative folosind Generative AI Studio, simplificând implementarea și gestionarea infrastructurii. Cazurile ideale de utilizare includ pregătirea datelor, ingineria caracteristicilor, instruirea și reglarea hiperparametrilor, difuzarea, reglarea și înțelegerea modelelor, precum și monitorizarea și gestionarea acestora.

Databricks

Databricks este un lac de date care permite pregătirea și procesarea datelor. Cu această platformă, puteți gestiona întregul ciclu de viață al învățării automate, de la experimentare la producție.

Databricks oferă MLFlow gestionat, funcții precum versiunea publicitară de înregistrare a datelor modelelor ML, urmărirea experimentelor, difuzarea modelelor, un registru de modele și urmărirea valorilor publicitare. Registrul de modele stochează modele pentru reproductibilitate, iar registrul ajută la urmărirea versiunilor și a stadiului ciclului de viață.

Implementarea modelelor folosind Databricks se realizează printr-un singur clic, obținând puncte finale API REST pentru a face predicții. Se integrează cu modelele de limbaj generative și mari pre-antrenate, precum cele din biblioteca de transformatoare Hugging Face.

Databricks oferă notebook-uri colaborative care suportă Python, R, SQL și Scala, simplificând gestionarea infrastructurii prin furnizarea de clustere preconfigurate optimizate pentru sarcinile de învățare automată.

AWS SageMaker

AWS SageMaker este un serviciu AWS Cloud care oferă instrumentele necesare pentru dezvoltarea, instruirea și implementarea modelelor de învățare automată. Scopul principal al SageMaker este de a automatiza munca manuală și repetitivă implicată în construirea unui model de învățare automată.

Drept urmare, oferă instrumente pentru construirea unei conducte de producție pentru modelele de învățare automată, utilizând diferite servicii AWS, cum ar fi instanțele Amazon EC2 și stocarea Amazon S3.

SageMaker funcționează cu notebook-uri Jupyter instalate pe o instanță EC2, împreună cu toate pachetele și bibliotecile comune necesare pentru a codifica un model de învățare automată. Pentru date, SageMaker poate extrage date din Amazon Simple Storage Service.

În mod implicit, oferă implementări ale algoritmilor obișnuiți de învățare automată, cum ar fi regresia liniară și clasificarea imaginilor. SageMaker include și un monitor pentru model, oferind ajustări continue și automate pentru a găsi setul de parametri care oferă cea mai bună performanță pentru modele. Implementarea este simplificată, modelul putând fi implementat pe AWS ca punct final HTTP securizat, monitorizat cu CloudWatch.

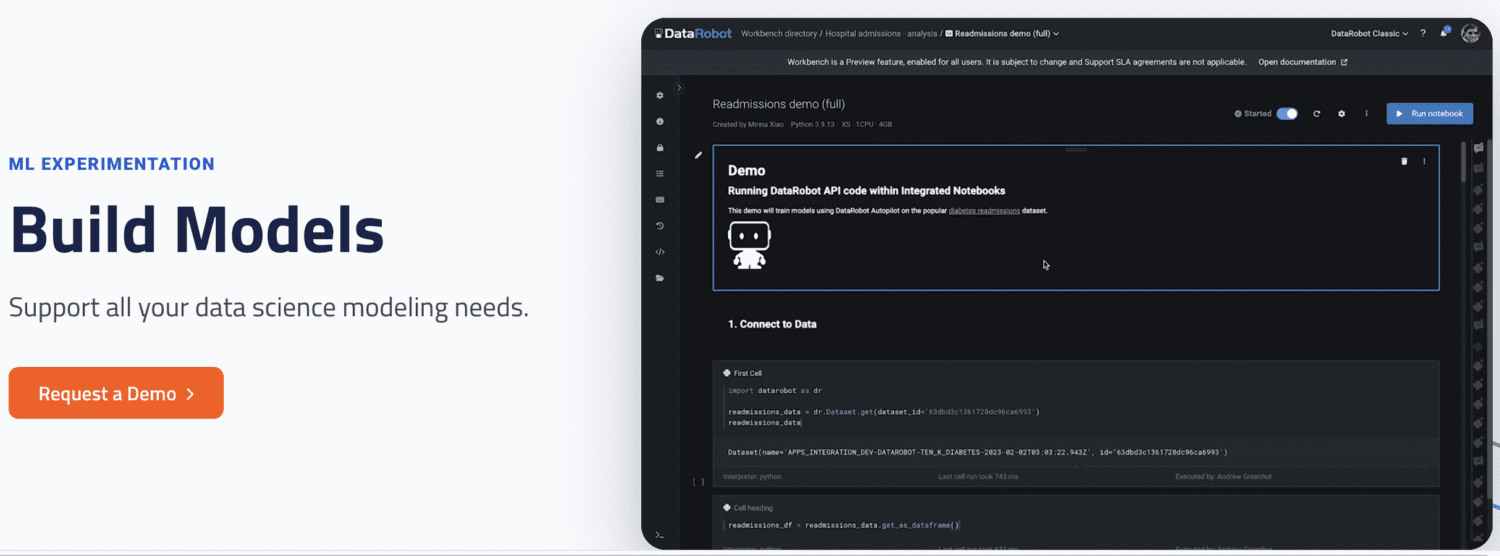

DataRobot

DataRobot este o platformă MLOps populară, permițând gestionarea diferitelor etape ale ciclului de viață al învățării automate, precum pregătirea datelor, experimentarea ML, validarea și modelele de guvernanță.

Are instrumente pentru automatizarea experimentelor cu diferite surse de date, testarea a mii de modele și evaluarea celor mai bune pentru implementarea în producție. Acceptă construirea de modele pentru diverse tipuri de AI, cum ar fi Time Series, Natural Language Processing și Computer Vision.

Cu DataRobot, puteți construi modele gata de utilizare, fără a scrie cod, sau puteți opta pentru o abordare bazată pe cod, implementând modele folosind cod personalizat.

DataRobot include notebook-uri pentru scrierea și editarea codului. Alternativ, puteți utiliza API-ul pentru a dezvolta modele într-un IDE la alegere. Folosind GUI, puteți monitoriza experimentele modelelor.

Run AI

Run AI abordează problema subutilizării infrastructurii AI, în special a GPU-urilor, prin promovarea vizibilității întregii infrastructuri și asigurându-se că aceasta este utilizată eficient în timpul antrenamentului.

Run AI se poziționează între software-ul MLOps și hardware-ul companiei. Toate lucrările de antrenament sunt executate folosind Run AI, iar platforma programează execuția fiecărei sarcini.

Nu există limitări în ceea ce privește locația hardware-ului (cloud, local sau hibrid), platforma oferind un strat de abstractizare pentru echipele de Machine Learning, funcționând ca o platformă de virtualizare GPU. Sarcinile pot fi rulate din Jupyter Notebook, terminalul bash sau PyCharm de la distanță.

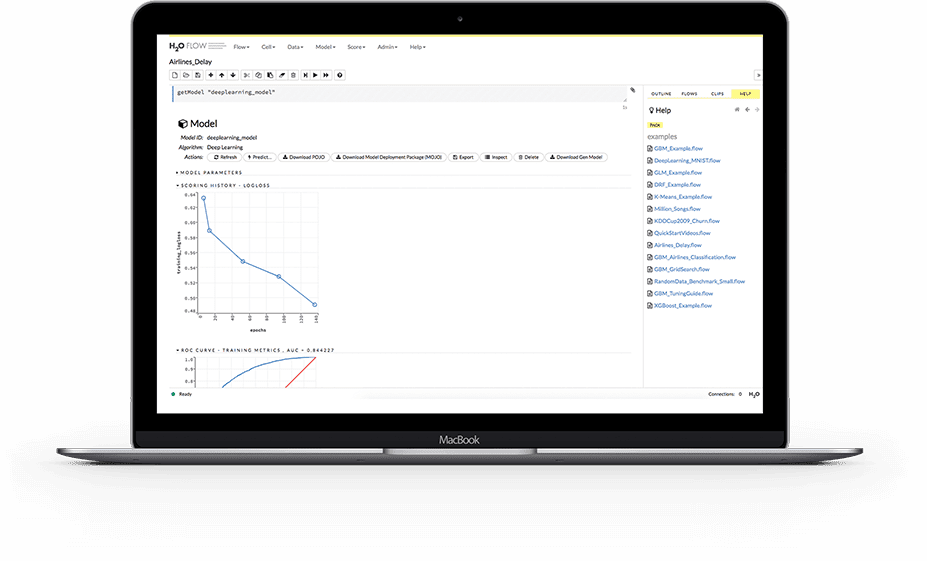

H2O.ai

H2O este o platformă de învățare automată distribuită, open source. Permite echipelor să colaboreze și să creeze un depozit central pentru modele, unde oamenii de știință de date pot experimenta și compara diferite modele.

Ca platformă MLOps, H20 oferă o serie de caracteristici cheie, simplificând implementarea modelului pe un server ca punct final REST, oferind diverse strategii de implementare, cum ar fi testul A/B și modelele Champion-Challenger.

În timpul antrenamentului, stochează și gestionează date, artefacte, experimente, modele și implementări, asigurând reproductibilitatea. Permite gestionarea permisiunilor la nivel de grup și utilizator pentru a guverna modelele și datele. În timpul rulării, H2O oferă monitorizare în timp real pentru deriva modelului și alte valori operaționale.

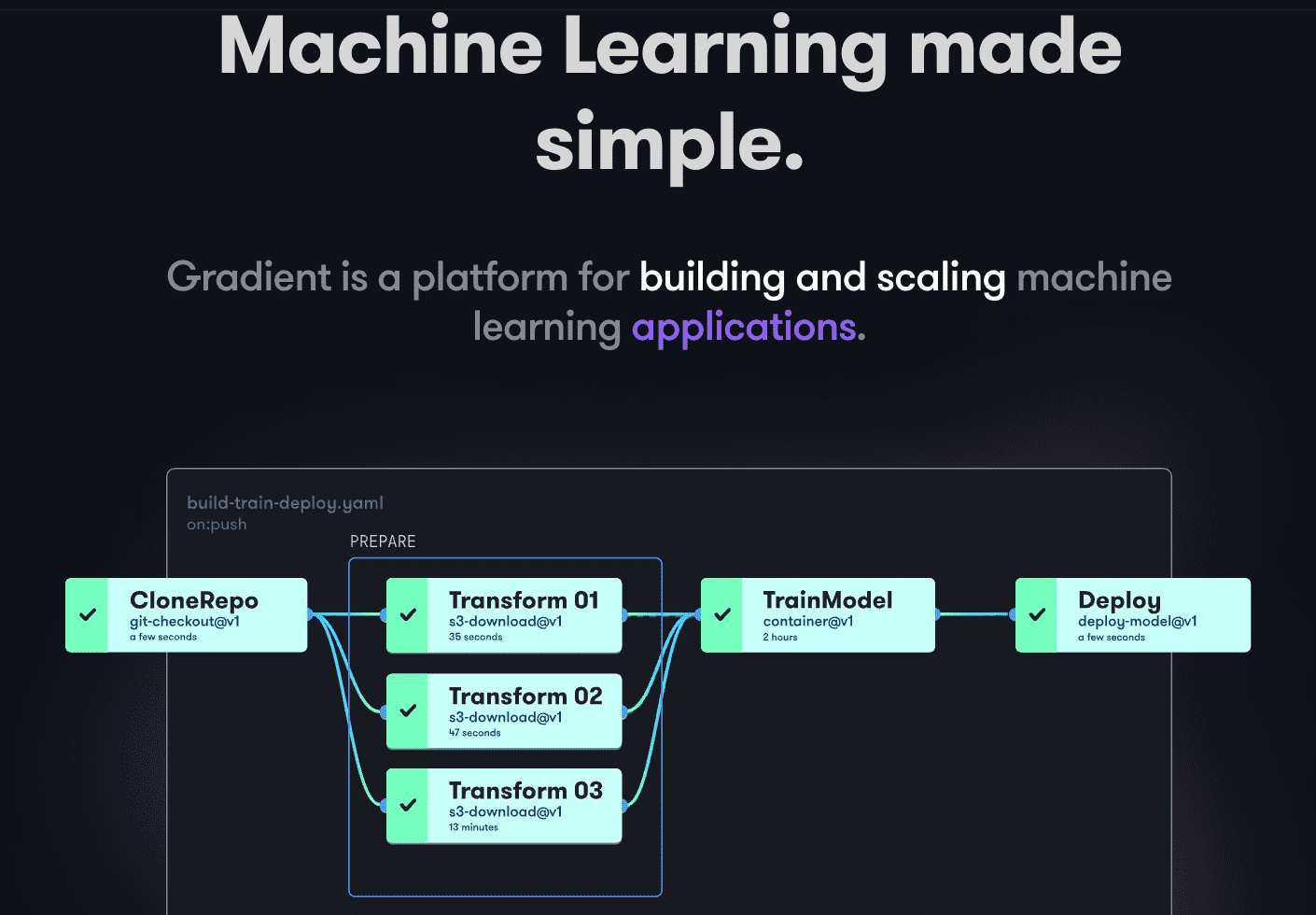

Paperspace Gradient

Gradient ajută dezvoltatorii în toate etapele ciclului de dezvoltare a Machine Learning, oferind notebook-uri Jupyter cu sursă deschisă pentru dezvoltarea de modele și instruire în cloud folosind GPU-uri puternice, facilitând explorarea și prototiparea rapidă a modelelor.

Canalele de implementare pot fi automatizate prin crearea de fluxuri de lucru, descriind sarcinile în YAML. Utilizarea fluxurilor de lucru face ca crearea de implementări și modele de servire să fie ușor de replicat și, prin urmare, scalabilă.

În ansamblu, Gradient oferă containere, mașini, date, modele, metrici, jurnale și secrete pentru a gestiona diferitele etape ale conductei de dezvoltare a modelelor de învățare automată. Conductele rulează pe clustere Gradient, fie pe Paperspace Cloud, AWS, GCP, Azure sau alte servere, oferind interacțiune programatică prin CLI sau SDK.

Concluzie

MLOps reprezintă o abordare eficientă și flexibilă pentru construirea, implementarea și gestionarea modelelor de învățare automată la scară largă, fiind ușor de utilizat, scalabil și sigur pentru organizații de toate dimensiunile.

Acest articol a prezentat MLOps, importanța implementării sale, aspectele cheie și diversele platforme MLOps disponibile.

Pentru aprofundare, vă recomandăm să consultați comparația noastră dintre Dataricks și Snowflake.