Pentru cei care nu sunt familiarizați cu codificarea, crearea unui web scraper ar putea fi dificilă. Din fericire, software-ul web scraping este accesibil atât pentru programatori, cât și pentru non-programatori. Software-ul Web scraping este un software special conceput pentru obținerea de date relevante de pe site-uri web. Aceste instrumente sunt benefice pentru oricine dorește să achiziționeze date de pe Internet într-un fel. Aceste informații sunt înregistrate într-un fișier local de pe computer sau într-o bază de date. Este tehnica de colectare autonomă a datelor pentru web. Aducem la o listă cu cele mai bune 31 de instrumente gratuite de scraping web.

Cuprins

31 de cele mai bune instrumente de răzuire web

O listă selectată cu cele mai bune instrumente de scraping web poate fi găsită aici. Această listă conține atât instrumente comerciale, cât și instrumente open-source, precum și link-uri către site-urile respective.

1. Dezmetic

Outwit este un program de completare pentru Firefox care este ușor de instalat din magazinul de suplimente pentru Firefox.

- Acest instrument de răzuire a datelor face ca strângerea de contacte de pe web și prin e-mail să fie o ușoară.

- În funcție de cerințele dumneavoastră, veți avea trei alternative pentru achiziționarea acestui produs.

- Pro

-

Expert, și

-

Sunt disponibile ediții Enterprise.

- Datele exacte de pe site-uri care utilizează hub Outwit nu necesită cunoștințe de programare.

- Puteți începe să răzuiți sute de pagini web cu un singur clic pe butonul de explorare.

2. PareseHub

ParseHub este un alt dintre cele mai bune instrumente gratuite de scraping web.

- Înainte de a descărca date, curățați textul și HTML.

- Este la fel de simplu ca să alegeți datele pe care doriți să le extrageți folosind web scraper-ul nostru sofisticat.

- Este unul dintre cele mai bune instrumente de răzuire a datelor, deoarece vă permite să stocați datele răzuite în orice format pentru analize ulterioare.

- Interfața grafică ușor de utilizat

- Acest instrument de scraping pe internet vă permite să colectați și să salvați automat date pe servere.

3. Apify

Apify este unul dintre cele mai bune instrumente de automatizare și scraping web care vă permite să construiți un API pentru orice site web, cu proxy rezidențiali și de centre de date încorporați, care facilitează extragerea datelor.

- Apify se ocupă de infrastructură și de facturare, permițând dezvoltatorilor să facă bani pasivi prin proiectarea de instrumente pentru alții.

- Unii dintre conectorii disponibili sunt Zapier, Integromat, Keboola și Airbyte.

- Apify Store are soluții de scraping gata făcute pentru site-uri web populare precum Instagram, Facebook, Twitter și Google Maps.

- JSON, XML, CSV, HTML și Excel sunt toate formulare structurate care pot fi descărcate.

- HTTPS, direcționarea în funcție de locație geografică, rotația inteligentă a IP și proxy-urile Google SERP sunt toate caracteristicile Apify Proxy.

- Probă de proxy gratuită de 30 de zile cu un credit de platformă de 5 USD.

4. Scrapestack

Scrapestack este folosit de peste 2.000 de firme și se bazează pe acest API unic, care este alimentat de apilayer. Este unul dintre cele mai bune instrumente gratuite de web scraping.

- Utilizează un grup mondial de adrese IP de 35 de milioane de centre de date.

- Permite executarea simultană a mai multor solicitări API.

- Sunt acceptate atât decriptarea CAPTCHA, cât și redarea JavaScript.

- Sunt disponibile atât opțiuni gratuite, cât și cu plată.

- Scrapestack este un API REST de scraping online care funcționează în timp real.

- API-ul scrapestack vă permite să răzuiți pagini web în milisecunde folosind milioane de IP-uri proxy, browsere și CAPTCHA.

- Solicitările de scraping web pot fi trimise din peste 100 de locații diferite din întreaga lume.

5. FMiner

Pentru Windows și Mac OS, FMiner este un program popular de scraping online, extracție de date, crawling screen scraping, macro și program de asistență web.

- Datele pot fi colectate de pe site-uri web dinamice Web 2.0 greu de accesat.

- Vă permite să creați un proiect de extragere a datelor folosind editorul vizual, care este simplu de utilizat.

- Utilizează o combinație de structuri de linkuri, meniuri derulante și potrivire a modelelor URL pentru a vă permite să căutați în paginile web.

- Puteți utiliza servicii de decaptcha automate de la terți sau introducerea manuală pentru a viza protecția CAPTCHA a site-ului web.

6. Sequentum

Sequentum este un instrument robust de date mari pentru obținerea de date online de încredere. Este un alt dintre cele mai bune instrumente gratuite de scraping web.

- În comparație cu soluțiile alternative, extragerea datelor online devine din ce în ce mai rapidă.

- Puteți trece între mai multe platforme folosind această funcție.

- Este unul dintre cele mai puternice web scrapers pentru dezvoltarea companiei dvs. Conține caracteristici simple, inclusiv un editor vizual punct-and-click.

- API-ul web dedicat vă va ajuta să dezvoltați aplicații web, permițându-vă să executați date web direct de pe site-ul dvs.

7. Agentie

Agenty este un program de colectare a datelor, extragere de text și OCR care utilizează automatizarea proceselor robotizate.

- Acest program vă permite să reutilizați toate datele dumneavoastră prelucrate în scopuri de analiză.

- Puteți construi un agent cu doar câteva clicuri de mouse.

- Veți primi un mesaj de e-mail după finalizarea misiunii.

- Vă permite să vă conectați la Dropbox și să utilizați FTP securizat.

- Toate jurnalele de activitate pentru toate aparițiile sunt disponibile pentru a le vedea.

- Vă ajută să vă îmbunătățiți succesul companiei dvs.

- Vă permite să implementați cu ușurință regulile de afaceri și logica personalizată.

8. Import.io

Importând date dintr-o anumită pagină web și exportând datele în CSV, aplicația de web scraping import.io vă ajută să vă formați seturile de date. Este, de asemenea, unul dintre cele mai bune instrumente de scraping web. Următoarele sunt caracteristicile acestui instrument.

- Formularele/loginurile web sunt simplu de utilizat.

- Este una dintre cele mai bune soluții de scraping de date pentru utilizarea API-urilor și webhook-urilor pentru a integra datele în aplicații.

- Puteți obține informații prin rapoarte, diagrame și vizualizări.

- Extragerea datelor ar trebui să fie planificată din timp.

- Import.io cloud vă permite să stocați și să accesați date.

- Interacțiunea cu web și fluxurile de lucru poate fi automatizată.

9. Webz.io

Webz.io vă permite să accesați cu crawlere sute de site-uri web și să aveți acces imediat la date structurate și în timp real. Este, de asemenea, unul dintre cele mai bune instrumente gratuite de scraping web.

Puteți achiziționa seturi de date organizate, care pot fi citite de mașină, în formate JSON și XML.

- Vă oferă acces la fluxuri istorice care se întind pe peste zece ani de date.

- Vă permite să aveți acces la o bază de date mare de fluxuri de date fără a fi nevoie să plătiți cheltuieli suplimentare.

- Puteți utiliza un filtru avansat pentru a face analize detaliate și a seturi de date pentru feed.

10. Scrapeowl

Scrape Owl este o platformă de scraping web care este ușor de utilizat și economică.

- Scopul principal al lui Scrape Owl este de a răzui orice tip de date, inclusiv comerțul electronic, panourile de locuri de muncă și listele imobiliare.

- Înainte de a extrage materialul, puteți rula JavaScript personalizat.

- Puteți folosi locații pentru a evita restricțiile locale și pentru a accesa conținut local.

- Oferă o funcție de așteptare de încredere.

- Este acceptată redarea JavaScript pe toată pagina.

- Această aplicație poate fi utilizată direct pe o foaie de calcul Google.

- Oferă o probă gratuită de 1000 de credite pentru a încerca serviciul înainte de a cumpăra orice abonament. Nu este nevoie să folosiți un card de credit.

11. Scrapingbee

Scrapingbee este un API de scraping web care se ocupă de setările proxy și de browserele fără cap.

- Poate executa Javascript pe pagini și poate roti proxy-urile pentru fiecare solicitare, astfel încât să puteți citi HTML brut fără a fi trecut pe lista neagră.

- Un al doilea API pentru extragerea rezultatelor căutării Google este, de asemenea, disponibil.

- Redarea JavaScript este acceptată.

- Are o funcție de rotație automată a proxy-ului.

- Această aplicație poate fi utilizată direct pe Foi de calcul Google.

- Browserul web Chrome este necesar pentru a utiliza programul.

- Este ideal pentru Amazon scraping.

- Vă permite să răzuiți rezultatele Google.

12. Date luminoase

Bright Data este cea mai importantă platformă de date online din lume, oferind o soluție rentabilă pentru a colecta date publice web la scară, pentru a converti cu ușurință datele nestructurate în date structurate și pentru a oferi o experiență superioară pentru clienți, fiind în același timp pe deplin transparentă și conformă.

- Este cel mai adaptabil, deoarece vine cu soluții prefabricate și este extensibil și reglabil.

- Data Collector-ul de ultimă generație al Bright Data oferă un flux automat și personalizat de date pe un singur tablou de bord, indiferent de dimensiunea colecției.

- Este deschis 24 de ore pe zi, șapte zile pe săptămână și oferă asistență clienților.

- De la tendințele comerțului electronic și datele rețelelor sociale până la informații despre concurență și studii de piață, seturile de date sunt adaptate nevoilor afacerii dvs.

- Vă puteți concentra asupra afacerii dvs. principale prin automatizarea accesului la date fiabile din industria dvs.

- Este cel mai eficient, deoarece folosește soluții fără cod și utilizează mai puține resurse.

- Cel mai de încredere, cu date de cea mai bună calitate, timp de funcționare mai mare, date mai rapide și un serviciu mai bun pentru clienți.

13. Scraper API

Puteți utiliza instrumentul API Scraper pentru a gestiona proxy-uri, browsere și CAPTCHA.

- Instrumentul oferă viteză și fiabilitate de neegalat, permițând crearea de web scrapers scalabile.

- Puteți obține codul HTML de pe orice pagină web cu un singur apel API.

- Este simplu de configurat, deoarece tot ce trebuie să faceți este să trimiteți o solicitare GET cu cheia API și adresa URL către punctul final API.

- Permite redarea mai ușor a JavaScript-ului.

- Vă permite să personalizați tipul cererii și anteturile pentru fiecare cerere.

- Rotirea proxy-urilor cu o locație geografică

14. Dexi Intelligent

Dexi intelligent este o aplicație de scraping online care vă permite să transformați orice cantitate de date web în valoare comercială rapidă.

- Acest instrument de răzuire online vă permite să economisiți bani și timp pentru compania dvs.

- Are productivitate, precizie și calitate îmbunătățite.

- Permite cea mai rapidă și eficientă extragere a datelor.

- Are un sistem de captare a cunoștințelor pe scară largă.

15. Diffbot

Diffbot vă permite să obțineți rapid o varietate de fapte importante de pe internet.

- Cu extractoarele AI, veți putea extrage date structurate precise de la orice adresă URL.

- Nu veți fi taxat pentru răzuirea site-ului web care necesită timp sau pentru interogarea manuală.

- Pentru a construi o imagine completă și precisă a fiecărui obiect, multe surse de date sunt îmbinate.

- Puteți extrage date structurate din orice adresă URL cu AI Extractors.

- Cu Crawlbot, vă puteți extinde extracția la zeci de mii de domenii.

- Caracteristica Knowledge Graph oferă internetului date precise, complete și profunde de care BI are nevoie pentru a oferi informații semnificative.

16. Streamer de date

Data Streamer este o tehnologie care vă permite să obțineți materiale de rețele sociale de pe tot internetul.

- Este unul dintre cei mai mari scrapers online care utilizează procesarea limbajului natural pentru a prelua metadate cruciale.

-

Kibana și Elasticsearch sunt folosite pentru a oferi căutare integrată full-text.

- Bazat pe algoritmi de regăsire a informațiilor, eliminarea standardelor integrate și extragerea conținutului.

- Construit pe o infrastructură tolerantă la erori pentru a oferi o disponibilitate ridicată a informațiilor.

17. Mozenda

Puteți extrage text, fotografii și materiale PDF de pe pagini web folosind Mozenda.

- Puteți utiliza instrumentul sau baza de date aleasă de dvs. pentru a aduna și publica date online.

- Este unul dintre cele mai bune instrumente de scraping online pentru organizarea și formatarea fișierelor de date pentru publicare.

- Cu o interfață punct-and-click, puteți crea agenți de scraping web în câteva minute.

- Pentru a aduna date web în timp real, utilizați funcțiile Job Sequencer și Request Blocking.

- Gestionarea conturilor și serviciul pentru clienți sunt printre cele mai bune din industrie.

18. Extensia Chrome Data Miner

Scrapingul web și capturarea datelor sunt simplificate cu pluginul de browser Data Miner.

- Are capacitatea de a accesa cu crawlere mai multe pagini, precum și de extragere dinamică a datelor.

- Selectarea datelor se poate face într-o varietate de moduri.

- Acesta examinează informațiile care au fost răzuite.

- Datele răzuite pot fi salvate ca fișier CSV.

- Stocarea locală este utilizată pentru a stoca date răzuite.

- Suplimentul Chrome Web Scraper extrage date de pe site-uri dinamice.

- Sitemapurile pot fi importate și exportate.

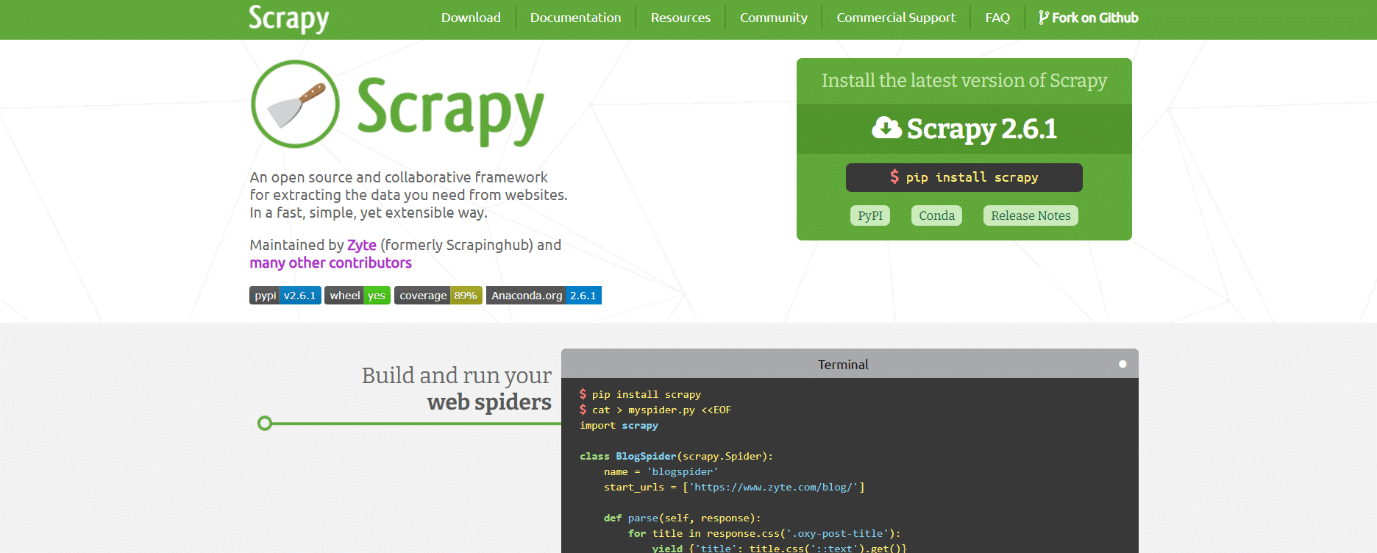

19. Scrapy

Scrapy este, de asemenea, unul dintre cele mai bune instrumente de scraping web. Este un cadru de scraping online open-source bazat pe Python pentru crearea de web scrapers.

- Vă oferă toate instrumentele de care veți avea nevoie pentru a extrage rapid date de pe site-uri web, a le analiza și a le salva în structura și formatul dorit.

- Acest instrument de scraping de date este un must-have dacă aveți un proiect mare de data scraping și doriți să îl faceți cât mai eficient posibil, păstrând în același timp multă flexibilitate.

- Datele pot fi exportate ca JSON, CSV sau XML.

- Linux, Mac OS X și Windows sunt toate acceptate.

- Este dezvoltat pe baza tehnologiei de rețea asincronă Twisted, care este una dintre caracteristicile sale cheie.

- Scrapy se remarcă prin simplitatea utilizării, documentația extinsă și comunitatea activă.

20. ScrapeHero Cloud

ScrapeHero și-a luat anii de cunoștințe de crawling web și le-a transformat în crawlere și API-uri prefabricate economice și ușor de utilizat pentru răzuirea datelor de pe site-uri precum Amazon, Google, Walmart și altele.

- Crawlerele ScrapeHero Cloud includ proxy-uri cu rotire automată și opțiunea de a rula mai multe crawler-uri în același timp.

- Nu este necesar să descărcați sau să învățați cum să utilizați instrumente sau software de scraping pentru a utiliza ScrapeHero Cloud.

- Crawlerele ScrapeHero Cloud vă permit să extrageți instantaneu datele și să le exportați în formate JSON, CSV sau Excel.

- Clienții cu planul Free și Lite ai ScrapeHero Cloud primesc asistență prin e-mail, în timp ce toate celelalte planuri primesc serviciu prioritar.

- Crawlerele ScrapeHero Cloud pot fi, de asemenea, configurate pentru a satisface cerințele specifice ale clienților.

- Este un web scraper bazat pe browser care funcționează cu orice browser web.

- Nu aveți nevoie de cunoștințe de programare sau pentru a dezvolta un scraper; este la fel de ușor ca să dai clic, să copiați și să lipiți!

21. Data Scraper

Data Scraper este o aplicație gratuită de scraping online, care extrage datele dintr-o singură pagină web și le salvează ca fișiere CSV sau XSL.

- Este o extensie de browser care convertește datele într-un format tabelar îngrijit.

- Instalarea pluginului necesită utilizarea browserului Google Chrome.

- Puteți răzui 500 de pagini în fiecare lună cu versiunea gratuită; dar, dacă doriți să răzuiți mai multe pagini, trebuie să faceți upgrade la unul dintre planurile scumpe.

22. Visual Web Ripper

Visual Web Ripper este un instrument automat de colectare a datelor pentru site-uri web.

- Structurile de date sunt colectate de pe site-uri web sau din rezultatele căutării folosind acest instrument.

- Puteți exporta date în fișiere CSV, XML și Excel și are o interfață ușor de utilizat.

- De asemenea, poate colecta date de pe site-uri web dinamice, cum ar fi cele care folosesc AJAX.

- Trebuie pur și simplu să configurați câteva șabloane, iar web scraper se va ocupa de restul.

- Visual Web Ripper oferă opțiuni de programare și chiar vă trimite un e-mail dacă un proiect eșuează.

23. Octoparse

Octoparse este o aplicație de scraping a paginilor web ușor de utilizat, cu o interfață vizuală. Este unul dintre cele mai bune instrumente gratuite de web scraping. Următoarele sunt caracteristicile acestui instrument.

- Interfața sa point-and-click simplifică alegerea informațiilor pe care doriți să le extrageți de pe un site web. Octoparse poate gestiona atât pagini web statice, cât și dinamice datorită AJAX, JavaScript, cookie-uri și alte capabilități.

- Serviciile cloud avansate care vă permit să extrageți cantități mari de date sunt acum accesibile.

- Informațiile răzuite pot fi salvate ca fișiere TXT, CSV, HTML sau XLSX.

- Versiunea gratuită a Octoparse vă permite să construiți până la 10 crawler-uri; cu toate acestea, planurile de membru plătit includ caracteristici precum un API și un număr mare de proxy IP anonimi, care vă vor grăbi extragerea și vă vor permite să descărcați volume mari de date în timp real.

24. Web Harvey

Scraperul web vizual al WebHarvey are un browser încorporat pentru răzuirea datelor de pe site-urile online. Este, de asemenea, unul dintre cele mai bune instrumente de scraping web. Iată câteva caracteristici ale acestui instrument.

- Oferă o interfață punct-and-click care simplifică alegerea articolelor.

- Acest scraper are avantajul de a nu vă cere să scrieți niciun cod.

-

Fișierele CSV, JSON și XML pot fi folosite pentru a salva datele.

- De asemenea, este posibil să îl salvați într-o bază de date SQL. WebHarvey dispune de o funcție de colectare a categoriilor pe mai multe niveluri, care poate extrage datele din paginile de listă urmând fiecare nivel de conexiuni de categorie.

- Expresiile obișnuite pot fi folosite cu instrumentul de răzuire pe internet, oferindu-vă libertate suplimentară.

- Puteți configura servere proxy pentru a vă păstra IP-ul ascuns în timp ce extrageți date de pe site-uri web, permițându-vă să păstrați o măsură de confidențialitate.

25. PySpider

PySpider este, de asemenea, unul dintre cele mai bune instrumente gratuite de scraping web, care este un crawler web bazat pe Python. Câteva caracteristici ale acestui instrument sunt enumerate mai jos.

- Dispune de o arhitectură distribuită și acceptă pagini Javascript.

- Este posibil să aveți mulți crawler în acest fel. PySpider poate stoca date pe orice backend pe care îl alegeți, inclusiv MongoDB, MySQL, Redis și altele.

- Sunt disponibile cozi de mesaje precum RabbitMQ, Beanstalk și Redis.

- Unul dintre avantajele PySpider este interfața sa simplă de utilizator, care vă permite să schimbați scripturile, să monitorizați activitățile care rulează și să examinați rezultatele.

- Informațiile pot fi descărcate în formatele JSON și CSV.

- PySpider este internetul care trebuie luat în considerare dacă lucrați cu o interfață de utilizator bazată pe site-uri web.

- Funcționează și cu site-uri web care folosesc mult AJAX.

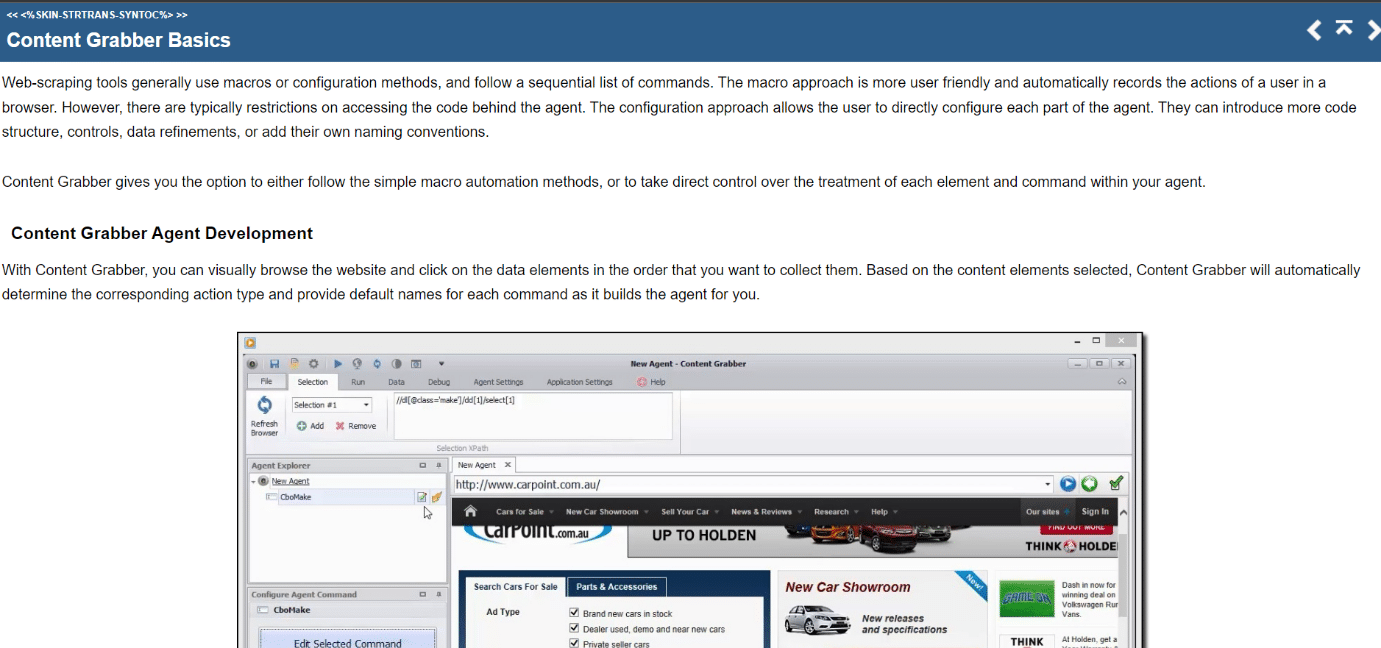

26. Content Grabber

Content Grabber este un instrument vizual de scraping online, cu o interfață ușor de utilizat prin punctare și clic pentru selectarea articolelor. Următoarele sunt caracteristicile acestui instrument.

- CSV, XLSX, JSON și PDF sunt formatele în care datele pot fi exportate. Pentru utilizarea acestui instrument sunt necesare abilități intermediare de programare.

- Paginarea, paginile de defilare fără limite și ferestrele pop-up sunt toate posibile cu interfața sa de utilizator.

- De asemenea, oferă procesare AJAX/Javascript, o soluție captcha, suport pentru expresii regulate și rotație IP (folosind Nohodo).

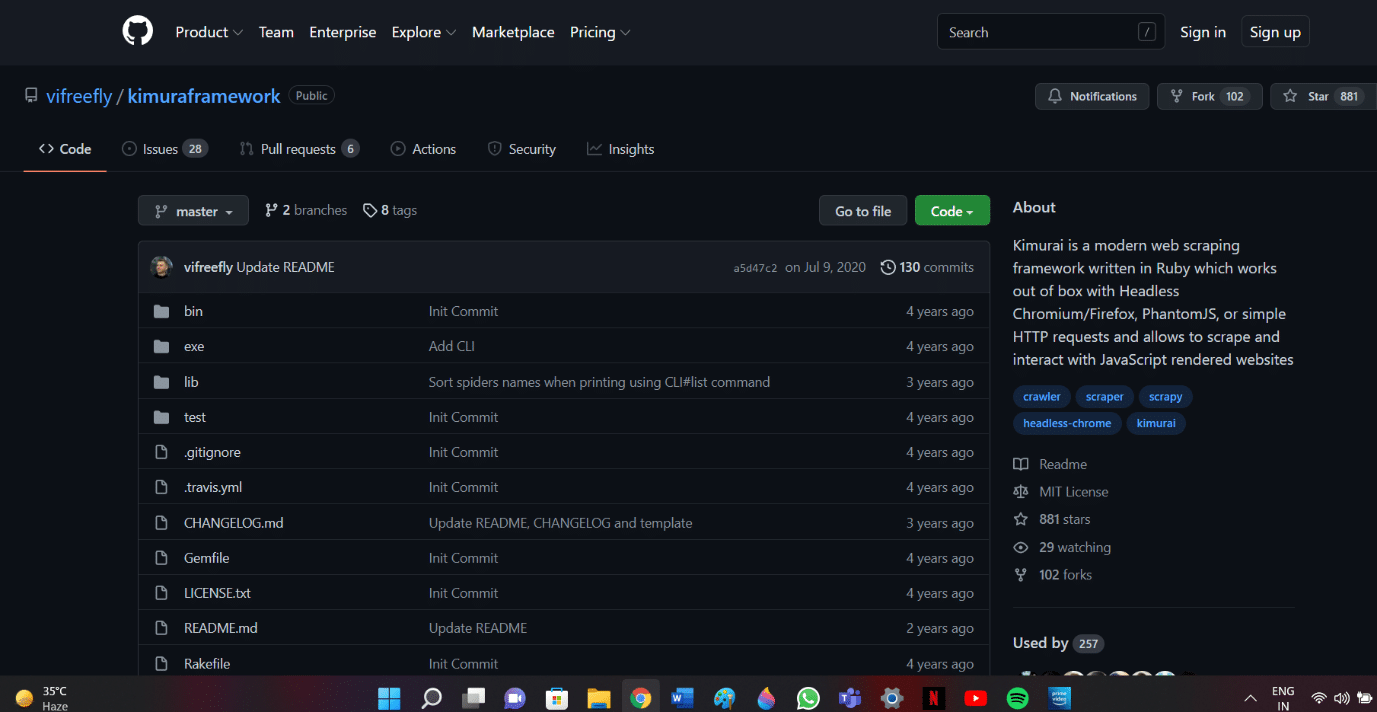

27. Kimurai

Kimurai este un cadru Ruby web scraping pentru crearea de scrapers și extragerea datelor. Este, de asemenea, unul dintre cele mai bune instrumente gratuite de scraping web. Iată câteva caracteristici ale acestui instrument.

- Ne permite să răzuim și să interacționăm cu pagini web produse de JavaScript imediat din cutie, cu interogări Headless Chromium/Firefox, PhantomJS sau HTTP de bază.

- Are o sintaxă similară cu Scrapy și opțiuni configurabile, inclusiv setarea unei întârzieri, rotația agenților utilizator și antetele implicite.

- De asemenea, interacționează cu paginile web folosind cadrul de testare Capybara.

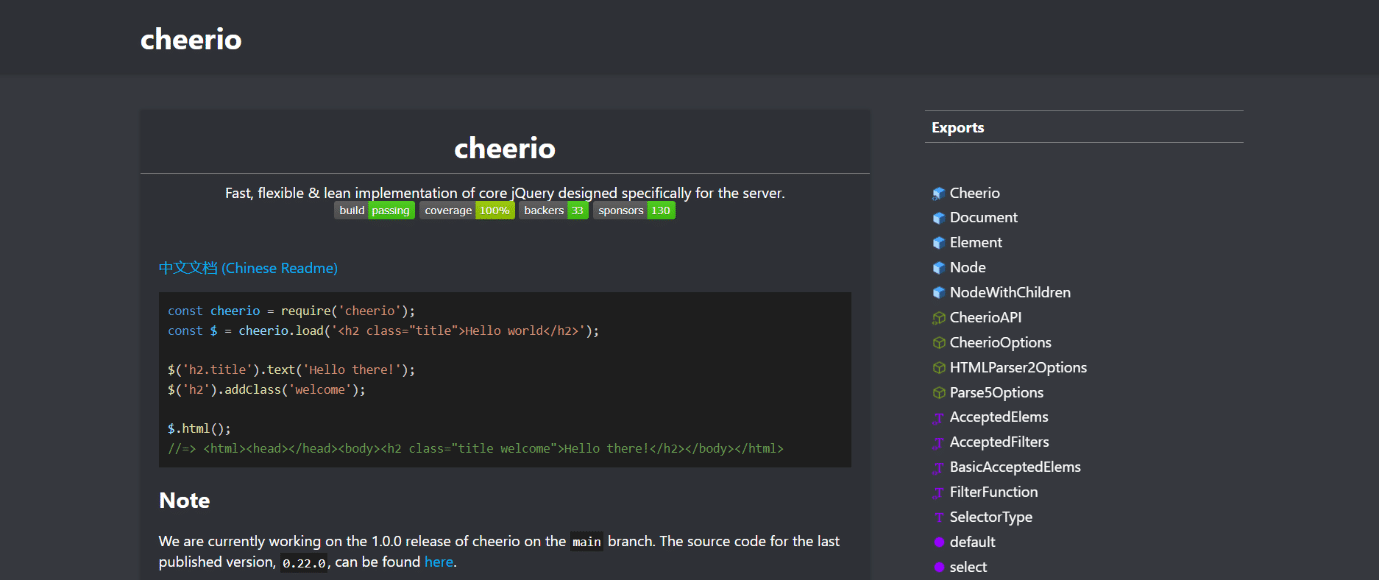

28. Cheerio

Cheerio este un alt dintre cele mai bune instrumente de scraping web. Este un pachet care analizează documente HTML și XML și vă permite să operați cu datele descărcate folosind sintaxa jQuery. Următoarele sunt caracteristicile acestui instrument.

- Dacă dezvoltați un web scraper JavaScript, API-ul Cheerio oferă o alegere rapidă pentru analizarea, modificarea și afișarea datelor.

- Nu redă rezultatul într-un browser web, nu aplică CSS, nu încarcă resurse externe sau nu rulează JavaScript.

- Dacă oricare dintre aceste funcționalități este necesară, ar trebui să vă uitați la PhantomJS sau JSDom.

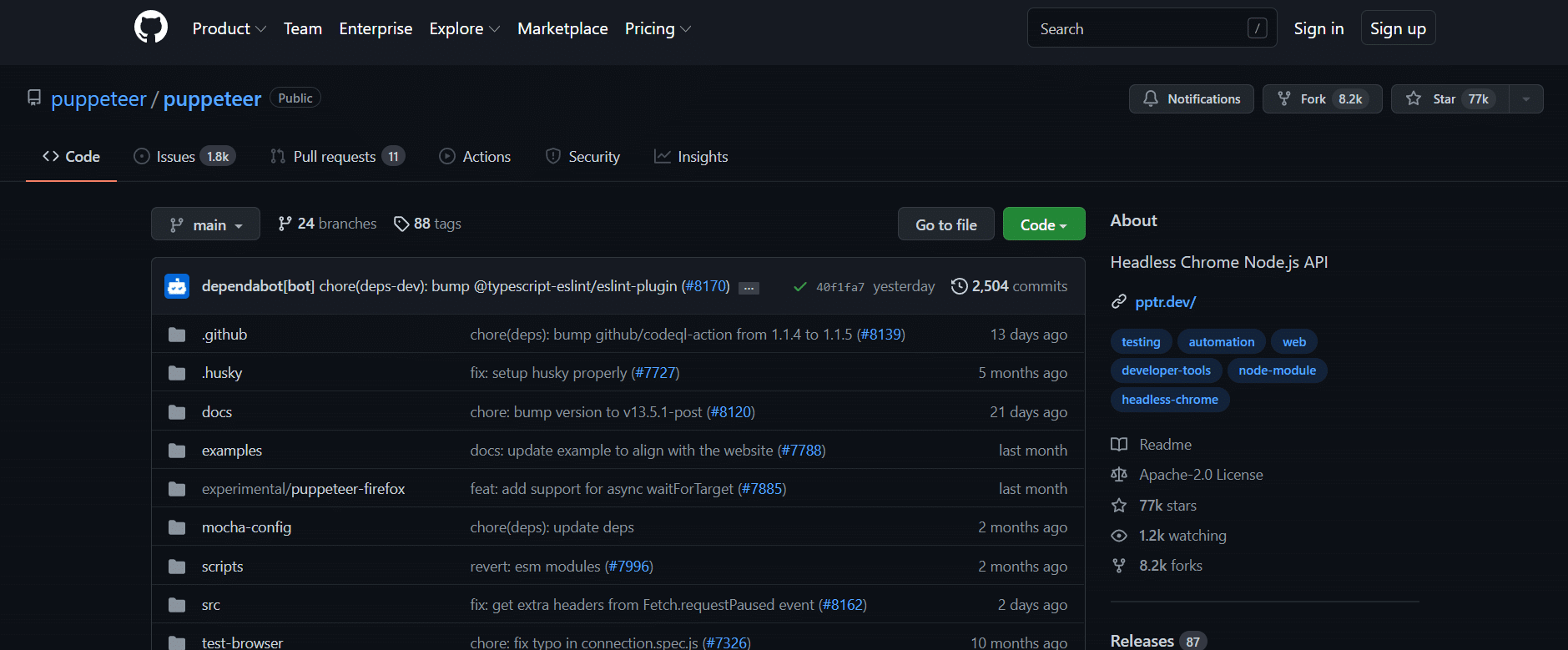

29. Păpușar

Puppeteer este un pachet Node care vă permite să gestionați browserul Chrome fără cap de la Google folosind un API puternic, dar simplu. Câteva caracteristici ale acestui instrument sunt enumerate mai jos.

- Se rulează în fundal, executând comenzi printr-un API.

- Un browser fără cap este unul care este capabil să trimită și să primească solicitări, dar nu are o interfață grafică cu utilizatorul.

- Puppeteer este soluția potrivită pentru sarcină dacă informațiile pe care le cauți sunt generate utilizând o combinație de date API și cod Javascript.

- Puteți imita experiența utilizatorului tastând și făcând clic în aceleași locuri în care fac.

- Puppeteer poate fi, de asemenea, folosit pentru a captura capturi de ecran ale paginilor web care sunt afișate implicit atunci când este deschis un browser web.

30. Dramaturg

Playwright este o bibliotecă Microsoft Node concepută pentru automatizarea browserului. Este un alt dintre cele mai bune instrumente gratuite de scraping web. Iată câteva caracteristici ale acestui instrument.

- Oferă automatizare web competentă, de încredere și rapidă între browsere.

- Dramaturgul a fost menit să îmbunătățească testarea automată a interfeței de utilizator prin eliminarea slăbiciunii, creșterea vitezei de execuție și oferirea de informații despre modul în care funcționează browserul.

- Este o aplicație modernă de automatizare a browserului care este comparabilă cu Puppeteer în multe privințe și vine cu browsere compatibile preinstalate.

- Principalul său avantaj este compatibilitatea între browsere, deoarece poate rula Chromium, WebKit și Firefox.

- Dramaturg se integrează cu Docker, Azure, Travis CI și AppVeyor în mod regulat.

31. PJScrape

PJscrape este un set de instrumente de scraping online bazat pe Python care utilizează Javascript și JQuery. Următoarele sunt caracteristicile acestui instrument.

- Este conceput să funcționeze cu PhantomJS, astfel încât să puteți elimina site-uri din linia de comandă într-un context complet redat, activat cu Javascript, fără a fi nevoie de un browser.

- Aceasta înseamnă că puteți accesa nu doar DOM-ul, ci și variabilele și funcțiile Javascript, precum și conținutul încărcat cu AJAX.

- Funcțiile scraper sunt evaluate în contextul întregului browser.

***

Sperăm că acest ghid a fost util despre cele mai bune instrumente de scraping web. Spuneți-ne ce instrument vi se pare ușor. Continuați să vizitați pagina noastră pentru mai multe sfaturi și trucuri interesante și lăsați-vă comentariile mai jos.