Buna ziua! 🙋Astăzi avem următoarele actualizări de produse pentru tine! 📣

OpenAI, Google, Microsoft și Anthropic colaborează pentru a reglementa dezvoltarea AI

Patru dintre cei mai importanți jucători în domeniul AI. OpenAI, Microsoft, Google și Anthropic s-au unit pentru a stabili Forumul modelului de frontieră. Acest organism industrial are misiunea de a se asigura că dezvoltarea modelelor de AI și de învățare automată, cunoscută sub numele de „IA de frontieră”, se realizează în siguranță și în mod responsabil.

OpenAI a introdus termenul „IA de frontieră” într-o lucrare publicată pe 6 iulie. Se referă la modele care prezintă riscuri pentru siguranța publică.

Obiectivele principale ale acestui forum sunt următoarele;

- Avansarea cercetării privind asigurarea siguranței IA.

- Identificarea practicilor pentru dezvoltarea și implementarea modelelor de frontieră.

- Colaborarea cu părțile interesate.

- Sprijinirea aplicațiilor care abordează provocările.

Înființarea Frontier Model Forum evidențiază atât dedicarea industriei de a aborda problemele legate de siguranță, cât și abordarea proactivă a gigantului tehnologic în gestionarea reglementărilor prin inițiative.

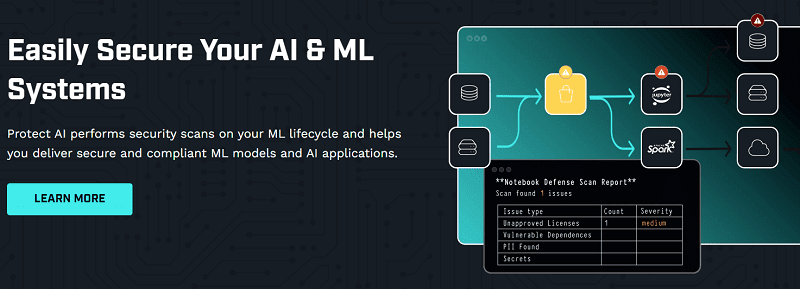

Protejați AI efectuează scanări de securitate și protejează sistemele de învățare automată (ML) și AI pentru a oferi modele de învățare automată și aplicații de inteligență artificială sigure și conforme. Oferă vizibilitate amenințărilor, testare de securitate și remediere a sistemelor Al și ML.

Compania a strâns o rundă de finanțare în valoare de 35 milioane USD, seria A, condusă de Evolution Equity Partners, cu participarea Salesforce Ventures și a investitorilor existenți. Până în prezent, compania a strâns un total de 48,5 milioane USD pentru a ajuta organizațiile să protejeze sistemele ML și aplicațiile AI de vulnerabilități unice de securitate, încălcări ale datelor și amenințări emergente.

NB Defense de la Protect AI securizează notebook-urile Jupyter Lab, sporind productivitatea și colaborarea. Reduce riscurile, scanează pentru probleme de securitate și oferă informații valoroase. Instrumentele AI protejează lanțul de aprovizionare cu software ML, scanează și fixează automat elementele.

Trustmi asigură 17 milioane USD pentru a-și extinde tehnologia de prevenire a fraudei la plăți

Trustmi valorifică inteligența artificială, învățarea automată și datele pentru a identifica și a preveni în mod proactiv tranzacțiile. Platforma oferă o serie de capabilități care permit companiilor să își consolideze securitatea plăților.

Aceste capabilități includ:

- Urmăriți plățile pentru orice activitate, cum ar fi tranzacțiile care implică țări cu risc ridicat sau plăți de la furnizori necunoscuti.

- Validarea plăților prin verificarea încrucișată a acestora cu sursele de date, care includ liste negre de carduri de credit și liste de conformitate a furnizorilor.

- Împuternicirea utilizatorilor cu opțiuni de control al plăților care le permit să aprobe sau să respingă plăți, stabilind în același timp limite pentru anumiți furnizori.

Compania a asigurat 17 milioane de dolari într-o rundă de Seria A, ducând investiția sa totală la 21 de milioane de dolari, condusă de Cyberstarts cu participarea Zeev Ventures.

Pentru mai multe actualizări, consultați categoria Ultima tehnologie.