Dacă sunteți interesat de AI, acest articol vă va ajuta cu siguranță să vă scufundați adânc în complexitățile sale. Sunt aici pentru a vă ghida în călătoria dvs. în domeniul platformelor LLMOps și pentru a oferi claritate cu privire la instrumentele cruciale oferite pentru testarea, îmbunătățirea și implementarea LLM-urilor.

Platformele prezentate în această listă proeminentă joacă un rol esențial în deblocarea întregului potențial al modelelor lingvistice, prezentând soluții inovatoare pentru dezvoltare și management.

Organizații apreciate precum Google, OpenAI și Microsoft folosesc platformele LLMOps pentru a asigura testarea amănunțită, rafinarea continuă și implementarea eficientă a modelelor lor lingvistice, rezultând rezultate fiabile și precise.

Recunoscând că LLMOps ar putea fi nou pentru mulți, să începem prin a obține o înțelegere de bază a LLMOps: semnificația, funcțiile și beneficiile sale.

Cu această bază, putem trece apoi la obiectivul nostru principal – identificarea instrumentelor optime pentru cititorii noștri pe baza cerințelor lor specifice. Lista principală încorporată în acest articol servește drept ghid pentru atingerea acestui obiectiv.

Cuprins

Ce este LLMOps?

LLMOps înseamnă Language Model Operations. Este vorba despre gestionarea, implementarea și îmbunătățirea modelelor de limbaj mari precum cele utilizate în AI. LLMOps implică instrumente și procese pentru instruirea, testarea și întreținerea acestor modele, asigurându-se că funcționează bine și rămân precise în timp.

Deși LLM-urile sunt ușor de prototipat, utilizarea lor în produse comerciale ridică provocări. Ciclul de dezvoltare LLM include pași complexi, cum ar fi pregătirea datelor, reglarea modelului și implementarea, care necesită o muncă în echipă fără întreruperi. LLMOps acoperă acest ciclu, asigurând experimentarea, implementarea și îmbunătățirea fără probleme.

Și, în sfârșit, aș dori să înțelegeți ce este Platforma LLMOps, deoarece vă va oferi o claritate precisă, iar trecerea pe această cale vă va oferi cu siguranță un rezultat bun după ce o citiți.

Platforma LLMOps încurajează colaborarea între oamenii de știință și inginerii de date, ajutând explorarea iterativă a datelor. Permite colaborarea în timp real, urmărirea experimentelor, gestionarea modelelor și implementarea controlată a LLM. LLMOps automatizează operațiunile, sincronizarea și monitorizarea de-a lungul ciclului de viață ML.

Cum funcționează LLMOps?

Platformele LLMOps simplifică întregul ciclu de viață al modelelor de limbaj. Acestea centralizează pregătirea datelor, permit experimentarea și permit reglarea fină pentru sarcini specifice. Aceste platforme facilitează, de asemenea, implementarea fără probleme, monitorizarea continuă și tranziția fără probleme a versiunilor.

Colaborarea este promovată, erorile sunt minimizate prin automatizare și rafinarea continuă este susținută. În esență, LLMOps optimizează managementul modelului de limbaj pentru diverse aplicații.

Beneficiile LLMOps

Avantajele principale pe care le consider semnificative includ eficiența, acuratețea și scalabilitatea. Iată o versiune elaborată a beneficiilor pe care LLMOps le oferă:

- Eficiență: Platformele LLMOps optimizează ciclul complet de dezvoltare, testare și implementare a modelului de limbaj, ceea ce duce la economii de timp și efort.

- Colaborare: Aceste platforme promovează cooperarea fără întreruperi între oamenii de știință ai datelor, inginerii și părțile interesate, promovând munca în echipă eficientă.

- Precizie: LLMO-urile mențin și îmbunătățesc precizia modelului în timp prin monitorizarea și rafinarea continuă a modelelor.

- Automatizare: LLMOps automatizează mai multe sarcini, inclusiv preprocesarea și monitorizarea datelor, reducând nevoia de intervenție manuală.

- Scalabilitate: prin extinderea eficientă a modelelor, platformele LLMOps pot adapta cu ușurință sarcini sau cerințe crescute.

- Ușurință de implementare: LLMOps asigură că modelele sunt integrate fără probleme în aplicații sau sisteme, minimizând provocările legate de implementare.

În esență, LLMO-urile îmbunătățesc eficiența, acuratețea și scalabilitatea, promovând în același timp colaborarea, automatizarea și implementarea fără probleme.

Acum, să trecem la lista noastră de platforme. Această listă este un ghid de la tipstrick.ro, dar decizia de a-l alege pe cel mai potrivit pentru tine, în funcție de cerințele și nevoile tale, este în mâinile tale.

Difică

Sunteți intrigat de progresele rapide ale tehnologiilor LLM precum GPT-4 și sunteți încântat de potențialul lor practic? Difică este conceput pentru a vă satisface. Dă putere dezvoltatorilor și chiar celor fără un fundal tehnic puternic să creeze rapid aplicații valoroase folosind modele de limbaj extinse. Aceste aplicații nu sunt doar ușor de utilizat; sunt pregătite pentru îmbunătățirea continuă.

Caracteristici cheie:

- Platformă LLMOps ușor de utilizat: dezvoltați fără efort aplicații AI folosind GPT-4 și gestionați-le vizual.

- AI contextuală cu datele dvs.: utilizați documente, conținut web sau note Notion ca context AI. Dify se ocupă de preprocesare și nu numai, economisind timp de dezvoltare.

- Dezlănțuiți potențialul LLM: Dify asigură accesul perfect la model, încorporarea contextului, controlul costurilor și adnotarea datelor pentru o creare fără probleme a AI.

- Șabloane gata făcute: alegeți dintre șabloane de dialog și de generare de text, gata de personalizare pentru aplicațiile dvs. specifice.

Agenta

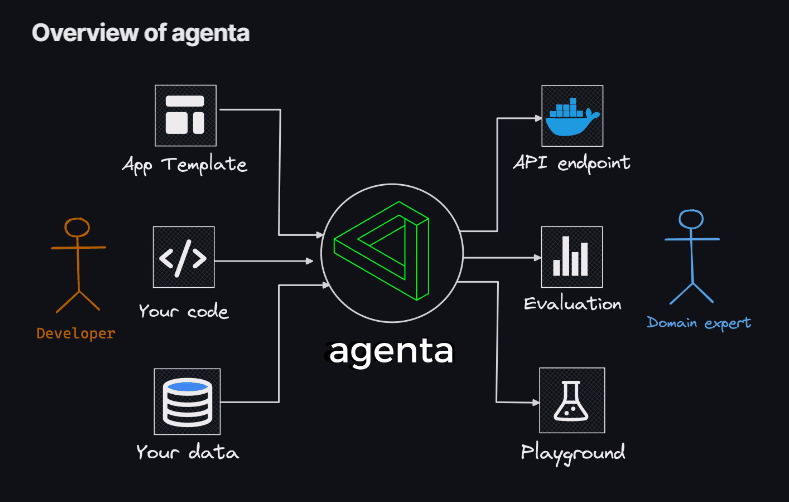

Dacă sunteți în căutarea flexibilității de a utiliza codificarea pentru crearea de aplicații LLM, fără constrângerile modelelor, bibliotecilor sau cadrelor, atunci Agenta este soluția ta. Agenta apare ca o platformă open-source, end-to-end, concepută pentru a eficientiza procesul de introducere în producție a aplicațiilor complexe de model de limbă mare (aplicații LLM).

Cu Agenta, puteți experimenta rapid și versiunea prompturi, parametri și strategii complicate. Aceasta include învățarea în context cu încorporare, agenți și logica de afaceri personalizată.

Caracteristici cheie:

- Explorarea parametrilor: specificați parametrii aplicației dvs. direct în codul dvs. și experimentați fără efort cu ei printr-o platformă web intuitivă.

- Evaluarea performanței: Evaluați eficacitatea aplicației dvs. pe seturile de testare folosind o varietate de metodologii, cum ar fi potrivirea exactă, AI Critic, evaluare umană și multe altele.

- Cadrul de testare: creați seturi de testare fără efort folosind interfața cu utilizatorul, fie că este vorba de încărcarea fișierelor CSV sau de conectarea perfectă la datele dvs. prin API-ul nostru.

- Mediu de colaborare: promovați munca în echipă, partajând aplicația dvs. cu colaboratorii și invitându-le feedback și perspective.

- Implementare fără efort: Lansați aplicația dvs. ca API cu un singur clic, simplificând procesul de implementare.

În plus, Agenta încurajează colaborarea cu experți din domeniu pentru inginerie și evaluare prompte. Un alt punct culminant este capacitatea Agentei de a evalua sistematic aplicațiile LLM și de a facilita implementarea aplicației cu un singur clic.

Phoenix

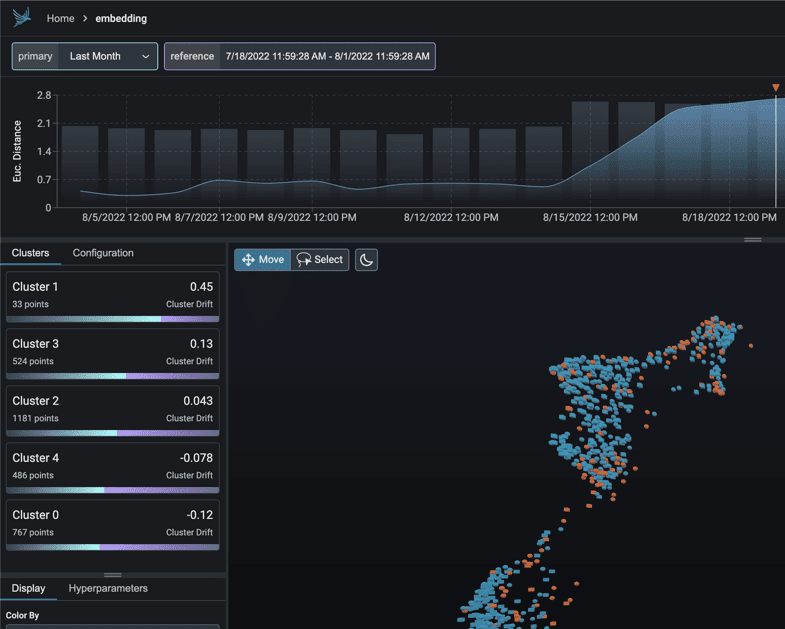

Imbarcați-vă într-o călătorie instantanee în statisticile MLOps alimentate de Phoenix. Acest instrument ingenios deblochează perfect observabilitatea în performanța modelului, deriva și calitatea datelor, toate fără povara configurațiilor complicate.

Ca o bibliotecă Python de avangardă centrată pe notebook-uri, Phoenix valorifică potența înglobărilor pentru a descoperi complexități ascunse din LLM, CV, NLP și modele tabulare. Crește-ți modelele cu capacitățile de neegalat pe care Phoenix le aduce la masă.

Caracteristici cheie:

- Investigarea derivei încorporate: scufundați-vă în norii de puncte UMAP în cazurile de distanță euclidiană substanțială și punctele de derive precise.

- Derivarea și analiza performanței prin clusterizare: Deconstruiți-vă datele în clustere cu o deviere semnificativă sau performanță inferioară prin HDBSCAN.

- Analiza exploratorie a datelor bazată pe UMAP: umbriți norii de puncte UMAP pe baza atributelor modelului dvs., a deriva și a performanței, dezvăluind segmente problematice.

LangKit

LangKit reprezintă un set de instrumente open-source pentru metrici de text conceput pentru a monitoriza în mod eficient modelele mari de limbă.

Forța motrice din spatele creării LangKit provine din conștientizarea faptului că transformarea modelelor de limbaj, inclusiv LLM, în producție implică diverse riscuri. Nenumăratele combinații potențiale de intrare, care conduc la rezultate la fel de numeroase, reprezintă o provocare considerabilă.

Caracteristici cheie:

- Analiza injectării prompte: Evaluați scorurile de similitudine cu atacuri de injecție rapide recunoscute.

- Analiza sentimentelor: Evaluează tonul sentimentelor din text.

- Evaluarea calității textului: Evaluați lizibilitatea, complexitatea și scorurile.

- Detectare jailbreak: identificați scorurile de similaritate cu încercările de jailbreak cunoscute.

- Analiza de toxicitate: detectează nivelurile de toxicitate în conținutul furnizat.

Natura nestructurată a textului complică și mai mult chestiunile din domeniul observabilității ML – o provocare care merită rezolvată. La urma urmei, absența unei perspective asupra comportamentului unui model poate avea repercusiuni semnificative.

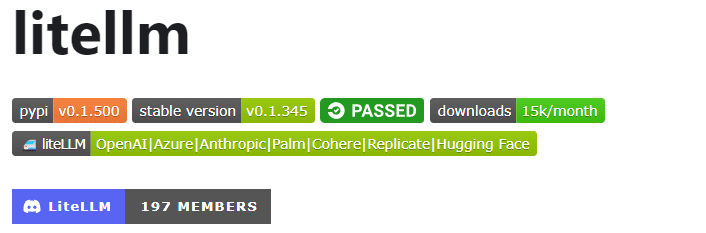

LiteLLM

Cu LiteLLMsimplificați-vă interacțiunile cu diferite API-uri LLM – Anthropic, Huggingface, Cohere, Azure OpenAI și multe altele – folosind un pachet ușor în format OpenAI.

Acest pachet simplifică procesul de apelare a punctelor finale API de la furnizori precum OpenAI, Azure, Cohere și Anthropic. Traduce intrările la finalizarea și încorporarea furnizorului relevant, asigurând rezultate uniforme. Puteți accesa oricând răspunsurile text la [‘choices’][0][‘message’][‘content’].

Caracteristici cheie:

- Apelare API LLM simplificată: simplifică interacțiunea cu API-urile LLM precum Anthropic, Cohere, Azure OpenAI etc.

- Pachet ușor: o soluție compactă pentru apelarea punctelor finale OpenAI, Azure, Cohere, Anthropic și API.

- Traducerea intrărilor: Gestionează traducerea intrărilor către punctele finale de completare și încorporare ale furnizorului respectiv.

- Maparea excepțiilor: mapează excepțiile comune între furnizori la tipurile de excepții OpenAI pentru gestionarea standardizată a erorilor.

În plus, pachetul include o funcție de mapare a excepțiilor. Aliniază excepțiile standard de la diferiți furnizori cu tipurile de excepții OpenAI, asigurând coerența în gestionarea erorilor.

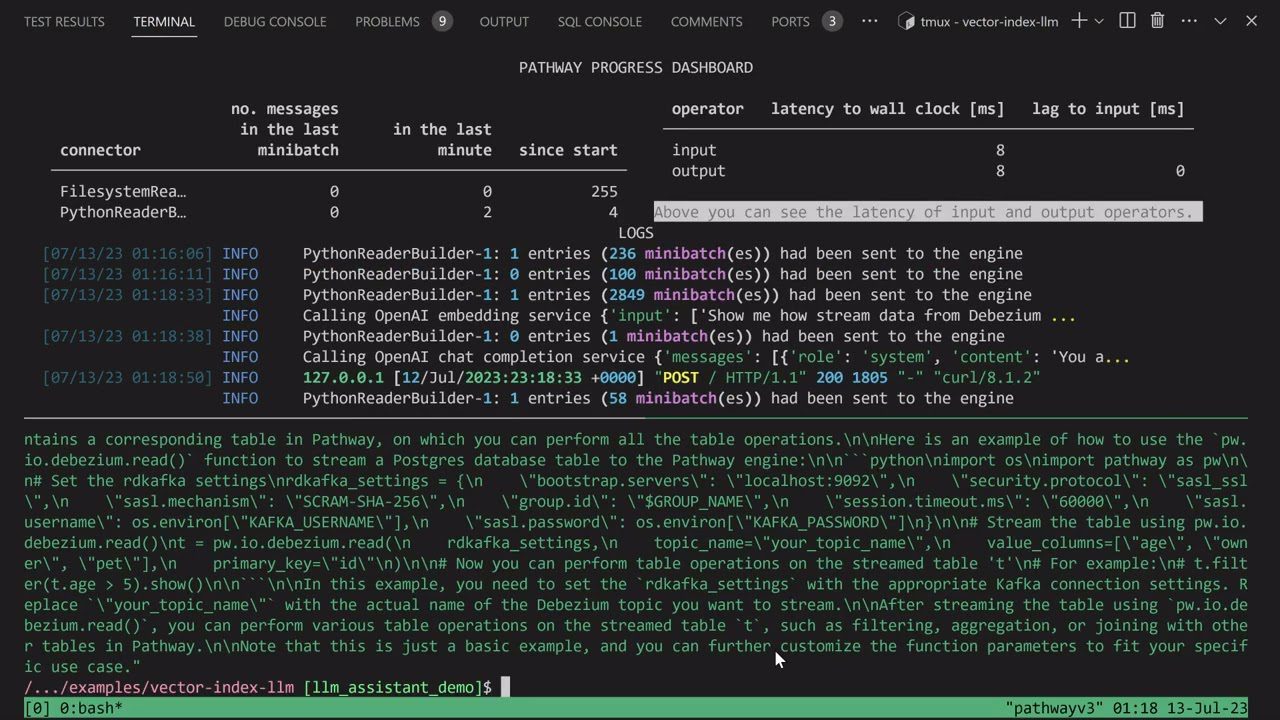

Aplicația LLM

Porniți-vă în călătoria creării unui chatbot Discord AI unic, îmbogățit cu priceperea de a răspunde la întrebări sau aruncați-vă în explorarea unor idei similare de bot AI. Toate aceste funcționalități captivante converg prin Aplicația LLM.

Vă prezint Pathways LLM-App – o bibliotecă Python concepută meticulos pentru a accelera dezvoltarea aplicațiilor AI inovatoare.

Caracteristici cheie:

- Creat pentru modele ML locale: Aplicația LLM este configurată să ruleze cu modele ML on-premise, rămânând în limitele organizației.

- Gestionarea datelor în timp real: această bibliotecă gestionează în mod abil sursele de date live, inclusiv fluxurile de știri, API-urile și fluxurile de date Kafka, cu permisiuni de utilizator și securitate solidă.

- Sesiuni fluide pentru utilizatori: procesul de creare a interogărilor din bibliotecă gestionează eficient sesiunile utilizatorilor, asigurând interacțiuni fără întreruperi.

Acest activ excepțional vă permite să oferiți răspunsuri instantanee care oglindesc interacțiunile umane atunci când adresați interogările utilizatorilor. Realizează această performanță remarcabilă utilizând în mod eficient cele mai recente informații ascunse în sursele dvs. de date.

LLMFlows

LLMFlows apare ca un cadru adaptat pentru a simplifica, clarifica și aduce transparență dezvoltării de aplicații cu model de limbaj mare (LLM), cum ar fi chatbot-uri, sisteme de răspuns la întrebări și agenți.

Complexitatea poate fi amplificată în scenariile din lumea reală datorită relațiilor complicate dintre solicitări și apeluri LLM.

Creatorii LLMFlows au imaginat un API explicit care le permite utilizatorilor să creeze cod curat și ușor de înțeles. Acest API eficientizează crearea de interacțiuni LLM complicate, asigurând un flux continuu între diferite modele.

Caracteristici cheie:

- Configurați fără probleme clasele LLM, selectând meticulos modele, parametri și setări specifice.

- Asigurați interacțiuni LLM robuste cu reîncercări automate în cazul eșecurilor apelului de model, asigurând fiabilitatea.

- Optimizați performanța și eficiența utilizând fluxuri asincrone pentru execuția paralelă a LLM-urilor atunci când intrările sunt disponibile.

- Infuzați funcții personalizate de manipulare a șirurilor direct în fluxuri, facilitând transformările personalizate ale textului dincolo de apelurile LLM.

- Mențineți controlul și supravegherea completă asupra aplicațiilor bazate pe LLM cu apeluri inverse, oferind monitorizare cuprinzătoare și vizibilitate asupra proceselor de execuție.

Clasele LLMFlows oferă utilizatorilor o autoritate nelimitată fără solicitări ascunse sau apeluri LLM.

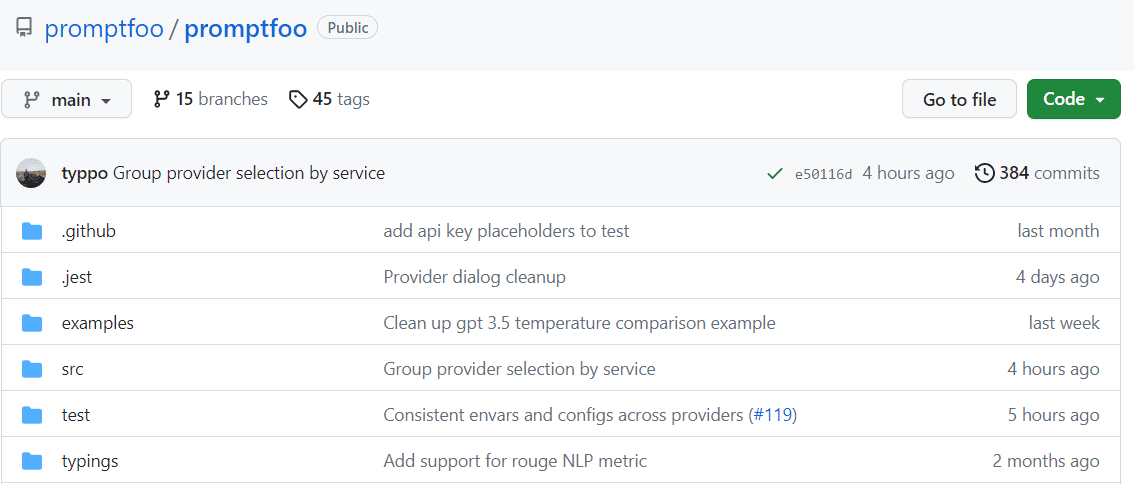

Promptfoo

Accelerați evaluările prin memorarea în cache și prin testarea concomitentă promptfoo. Oferă interfață de linie de comandă (CLI) și o bibliotecă, împuternicește evaluarea calității rezultatelor LLM.

Caracteristici cheie:

- Fiabilitate testată în luptă: Promptfoo a fost creat cu meticulozitate pentru a evalua și îmbunătăți aplicațiile LLM care se adresează a peste 10 milioane de utilizatori într-un mediu de producție. Instrumentele furnizate sunt flexibile și adaptabile la diverse configurații.

- Cazuri de testare ușor de utilizat: definiți evaluările fără a codifica sau a vă lupta cu notebook-uri greoaie. O abordare simplă, declarativă, eficientizează procesul.

- Flexibilitatea limbii: Indiferent dacă utilizați Python, Javascript sau orice altă limbă, promptfoo se potrivește preferințelor dvs.

În plus, promptfoo permite testarea sistematică a solicitărilor împotriva cazurilor de testare predefinite. Acest lucru ajută la evaluarea calității și la identificarea regresiilor, facilitând compararea directă paralelă a rezultatelor LLM.

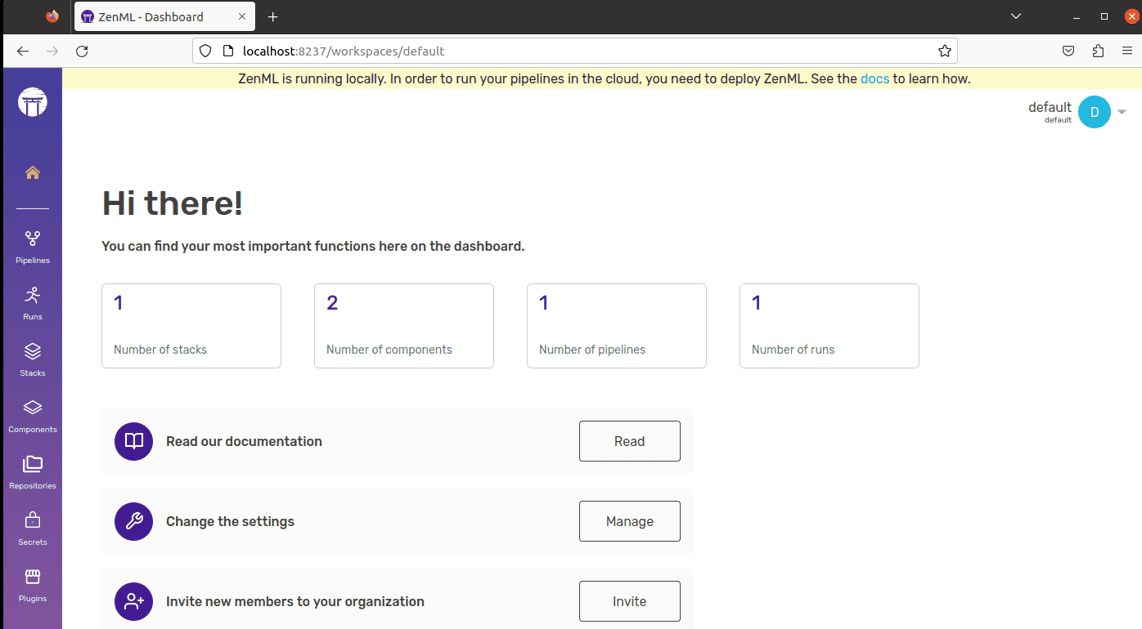

ZenML

Salută-l pe ZenML – un instrument adaptabil, open-source, conceput pentru a face lumea conductelor de învățare automată mai ușoară pentru profesioniști și organizații. Imaginați-vă că aveți un instrument care vă permite să creați conducte de învățare automată gata pentru utilizare în lumea reală, indiferent cât de complex este proiectul dvs.

ZenML separă elementele tehnice de cod, făcându-le mai simplu pentru dezvoltatori, oamenii de știință de date, experții MLOps și inginerii ML să lucreze împreună. Acest lucru înseamnă că proiectele dvs. pot trece de la etapa de idee la a fi pregătite pentru acțiune mai ușor.

Caracteristici cheie:

- Pentru oamenii de știință de date: concentrați-vă pe crearea și testarea modelelor în timp ce ZenML vă pregătește codul pentru utilizarea în lumea reală.

- Pentru experții în infrastructură MLOps: configurați, gestionați și implementați rapid sisteme complexe, astfel încât colegii să le poată folosi fără probleme.

- Pentru inginerii ML: gestionați fiecare pas al proiectului dvs. de învățare automată, de la început până la sfârșit, cu ajutorul ZenML. Acest lucru înseamnă mai puține transferuri de muncă și mai multă claritate în călătoria organizației dvs.

ZenML este creat pentru toată lumea, indiferent dacă sunteți profesionist sau parte dintr-o organizație. Vine cu un mod de scriere a codului conceput pentru sarcinile de învățare automată și funcționează bine cu orice serviciu sau instrument cloud pe care îl utilizați. În plus, vă ajută să vă gestionați proiectul într-un singur loc, astfel încât să nu vă faceți griji să jonglați cu diferite lucruri. Doar scrieți codul o dată și utilizați-l cu ușurință pe alte sisteme.

Gândul final

În această odisee emoționantă, rețineți întotdeauna că fiecare platformă prezintă o cheie distinctă capabilă să vă deblocheze aspirațiile AI. Selecția ta deține puterea de a-ți modela calea, așa că alege cu înțelepciune!

De asemenea, puteți explora unele instrumente AI pentru dezvoltatori pentru a crea aplicații mai rapid.