Deblocatoarele web reprezintă instrumente avansate de extragere a datelor de pe internet, specializate în colectarea informațiilor de pe diverse site-uri. Acestea sunt dotate cu funcționalități moderne, menite să optimizeze operațiunile afacerii tale.

Informațiile comerciale joacă un rol esențial în identificarea oportunităților de creștere și în obținerea de date valoroase.

Pentru o strategie de marketing eficientă, este necesară extragerea datelor de pe web, un proces pe care îl poți realiza cu ajutorul deblocatoarelor web. Dacă alegi să efectuezi manual această operațiune, vei consuma o cantitate semnificativă de timp și resurse.

Utilizarea unui deblocator web contribuie nu doar la creșterea eficienței, productivității și acurateței, ci și la ghidarea afacerii tale către succes prin automatizarea proceselor de extragere a informațiilor.

În acest articol, vom explora importanța extragerii datelor de pe web și modul în care un deblocator web poate eficientiza acest proces.

Ce este Web Scraping?

Web scraping este un proces automatizat și simplu de colectare a datelor structurate de pe paginile web. Spre deosebire de extragerea manuală a datelor, care consumă mult timp, web scraping utilizează tehnologii de automatizare avansate pentru a colecta cantități masive de date de pe internet.

Majoritatea informațiilor de pe internet se află în format HTML, adesea nestructurat. Prin web scraping, poți extrage aceste date și le poți transforma în date structurate, care pot fi stocate într-o bază de date sau într-o foaie de calcul. Aceste date pot fi ulterior utilizate în diverse aplicații pentru a înțelege strategiile și a-ți crea propria strategie.

Multe companii și persoane folosesc web scraping pentru a obține informații publice de pe site-uri web, cu scopul de a genera rapoarte și de a lua decizii informate. Exemple comune de utilizare includ analiza competitorilor, monitorizarea prețurilor, cercetarea de piață, monitorizarea știrilor și generarea de potențiali clienți.

Provocările Web Scraping

Deși web scraping este o tehnologie utilă pentru extragerea datelor specifice, aceasta se confruntă cu anumite dificultăți.

Roboții

Site-urile web au libertatea de a permite sau restricționa accesul roboților web scraper în scopuri de extragere a datelor. Multe site-uri interzic procesul de web scraping deoarece, de cele mai multe ori, roboții consumă excesiv resursele serverului în timp ce extrag date, afectând indirect performanța site-ului.

Modificări Structurale Frecvente

Pentru a îmbunătăți interfața cu utilizatorul și experiența generală, site-urile web sunt actualizate frecvent din punct de vedere structural. Scriptele web scraper sunt create specific pentru elementele codului paginii web existente la momentul configurării lor. Schimbările structurale frecvente îngreunează funcționarea acestor scripturi.

Deși nu toate modificările structurale afectează configurarea, unele pot duce la pierderea datelor. De asemenea, este dificil pentru web scraperi să mențină o evidență a modificărilor pentru a rămâne funcționali în timp ce un utilizator extrage date.

Captcha

Rolul principal al sistemului captcha este de a distinge între oameni și roboți prin prezentarea unor teste logice. Astfel, protejează site-urile de spam nedorit. Prezența unui captcha împiedică funcționarea scripturilor de bază folosite de scraperi.

Interzicerea

Când un robot web scraper trimite solicitări în paralel în mod repetat sau efectuează un număr nefiresc de cereri, există riscul ca acesta să depășească limita dintre scrapingul etic și cel neetic și să fie semnalat. Un web scraper trebuie să fie suficient de inteligent pentru a gestiona astfel de situații, respectând regulile și atingându-și obiectivele.

Scraping de Date în Timp Real

Pentru multe companii, rafinarea datelor în timp real este crucială pentru a obține informații esențiale și a lua decizii optime. De la variațiile prețurilor acțiunilor la schimbările de preț ale produselor, extragerea datelor ajută la obținerea de capital pentru afacerea ta.

Achiziționarea unor seturi mari de date poate fi copleșitoare, iar luarea deciziilor pe baza acestora poate fi o provocare. Astfel, scraperii web în timp real utilizează API-uri REST pentru a monitoriza și a extrage date dinamice disponibile. Cu toate acestea, rămâne o provocare. Gestionarea neglijentă a datelor poate provoca daune site-ului și internetului, având un impact negativ asupra afacerii tale.

Capcane Honeypot

Proprietarii de site-uri web creează capcane pe paginile lor pentru a detecta scraperii. Aceste capcane pot fi link-uri pe care scraperii le pot vedea, dar utilizatorii obișnuiți nu. Când un scraper cade în capcană, site-ul utilizează informațiile obținute pentru a bloca roboții scraper.

Cerințe de Conectare

Uneori, este necesar să te autentifici pentru a accesa anumite informații. După ce introduci datele de conectare, browserul adaugă un cookie la solicitările tale, care sunt transmise și către alte site-uri. Astfel, site-ul poate identifica că ești același utilizator care s-a conectat anterior și s-ar putea să te blocheze.

Cum poate ajuta Web Unlocker?

Un deblocator web este o variantă avansată a unui web scraper. Acesta ajută agenții de marketing digital, analiștii de date și cercetătorii de pe internet să acceseze site-uri web (chiar și cele blocate) în scopul cercetării. Deblochează întregul internet, ocolind blocările, interdicțiile, sistemele captcha și restricțiile, în timp ce automatizează procesul de web scraping.

Accesul la informații publice este legal conform anumitor reguli. Deblocatoarele web au fost dezvoltate ca o soluție pentru a facilita procesul de scraping. Cu ajutorul unui deblocator web, poți trimite cereri fără a-ți face griji în legătură cu capcanele sau blocările.

Un deblocator web oferă următoarele funcționalități:

- Utilizează automat o adresă IP rezidențială sau un proxy al centrului de date pentru a eluda sistemele de detectare a roboților

- Permite vizualizarea ca un utilizator obișnuit al site-urilor web

- Rezolvă problemele de conectare

- Oferă acces la conținut localizat din întreaga lume

- Protejează de capcanele de tip „honeypot”

- Gestionează rotația adreselor IP

- Personalizează amprenta digitală în timp real

- Deblochează și rezolvă problemele legate de captcha

- Oferă acces la site-uri web cu restricții geografice pentru extragerea datelor

- Se adaptează pentru a rămâne nedetectabil

- Algoritmii de învățare automată ai Web Unlocker facilitează extragerea datelor

- Permite utilizarea funcției de scraping API.

- Asigură nedetectabilitatea prin intermediul extinderii depozitului de cookie-uri de navigare, dispozitivelor emulate și solicitărilor de antet HTTP

- Permite efectuarea unui număr nelimitat de cereri pentru a obține datele necesare

Cum funcționează un program de deblocare web?

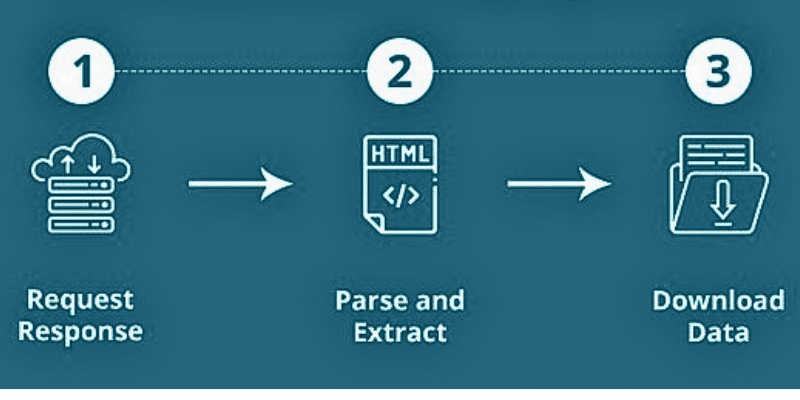

Pentru a extrage datele necesare, trebuie să le specifici cu exactitate, astfel încât programul de deblocare web să le extragă cu precizie și rapiditate.

De exemplu, dacă dorești o listă cu storcătoare disponibile pe un site de cumpărături, nu recenziile clienților, poți specifica cerința ta pentru a obține doar lista de storcătoare.

Atunci când un program de deblocare web efectuează scraping pe un site, sunt furnizate mai întâi URL-urile. Apoi, programul încarcă coduri HTML pentru site-uri web similare. Un scraper avansat poate extrage și elementele JavaScript și CSS. Ulterior, scraperul transformă datele din codul HTML într-un format simplu și ușor de înțeles.

Sursa: Quora

Sursa: Quora

De obicei, formatul de ieșire este un fișier CSV sau o foaie de calcul Excel. Datele pot fi stocate și în alte formate, inclusiv fișiere JSON.

Web scraping include două componente:

- Crawler-ul, un algoritm AI care navighează pe internet pentru a căuta anumite informații solicitate prin intermediul link-urilor de pe web.

- Scraper-ul, un instrument specific creat pentru a colecta date de pe site. Designul variază în funcție de complexitatea și scopul proiectului tău.

În acest mod, programul poate extrage datele cu precizie și rapiditate.

Importanța unui program de deblocare web

Indiferent dacă ești la început de drum în afaceri sau te afli într-o fază de creștere, extragerea datelor poate contribui semnificativ la dezvoltarea afacerii tale. Dezvoltatorii, analiștii și companiile preferă să utilizeze un program de deblocare web în locul proxy-urilor autogestionate și a gestionării captcha datorită caracteristicilor și capabilităților sale. Haide să vedem cum ajută companiile procesul de web scraping realizat cu ajutorul unui deblocator web.

Simplificarea extragerii datelor

Cu ajutorul tehnologiilor moderne, cum ar fi deblocatoarele web, poți simplifica procesul de extragere a datelor. Acesta permite oricui să extragă date cu ușurință la scară largă. În plus, poți avea acces la roboți care îți permit să colectezi date la orice scară.

Inovație Rapidă

Procesele de crawling și scraping permit companiilor să inoveze și să creeze mai rapid produse noi. Multe companii se dezvoltă prin colectarea și utilizarea datelor din diverse surse. Cu ajutorul web scraping-ului, îți poți îmbunătăți propunerea de valoare. Mai mult, web scraping te ajută să testezi și să implementezi idei noi utilizând datele extrase de pe site-uri web.

Generarea de Clienți Potențiali

Cu ajutorul unui program de deblocare web, poți accesa cu ușurință datele de afaceri ale competitorilor tăi. Acest lucru te ajută să construiești și mașini de vânzări automate. Poți căuta și agrega date în funcție de calitatea și nivelul de precizie de care ai nevoie. Odată ce ai datele necesare, poți genera clienți potențiali și poți menține creșterea.

Automatizarea Marketingului

Scrapingul de date este strâns legat de automatizarea marketingului. Să presupunem că observi profilul unui competitor pe Instagram, care are peste 18.000 de urmăritori. Dacă produsul tău este mai bun, iar utilizatorii află despre el, ei s-ar putea schimba. Pentru asta, ai nevoie de un marketing mai bun.

Pentru a face acest lucru, poți extrage datele care conțin lista urmăritorilor, poți începe să îi urmărești și să le trimiți mesaje directe. Poți face acest lucru și pe Twitter, Facebook etc. În plus, poți proceda în același mod și în cazul site-urilor concurente. Acest lucru te va ajuta să te dezvolți mai rapid pe piață, știind de ce are nevoie clientul tău și oferindu-i exact ceea ce își dorește.

Monitorizarea Mărcii

Primul pas pe care îl fac majoritatea clienților înainte de a cumpăra un produs este verificarea recenziilor. Companiile trebuie să recomande produse în funcție de nevoile clienților și să îi convingă că fac alegerea corectă. Cu ajutorul unui program de deblocare web, îți poți înțelege clienții și le poți oferi oferte mai bune.

În plus, poți monitoriza rețelele sociale și le poți combina cu analiza sentimentelor pentru a răspunde și a recompensa rapid utilizatorii.

Analiza Pieței

În lumea competitivă de astăzi, calitatea este mai importantă decât cantitatea. În loc de volume mari de date, ai nevoie de date relevante.

De exemplu, dacă vinzi piese de schimb pentru mașini, trebuie să specifici scopul achiziției pieselor. În acest caz, trebuie doar să aduni date de pe anumite site-uri web care distribuie astfel de piese de schimb.

Acum, este rândul tău să îți îmbunătățești vânzările folosind datele pe care le-ai extras. Acest lucru te ajută să analizezi destul de bine piața și să îți crești vânzările.

Funcționarea cu Învățarea Automată și Învățarea Profundă

Ai nevoie de un volum mare de date pentru a-ți antrena mașinile să construiască un model în funcție de datele introduse. Datele sunt elementul principal atunci când dorești ca mașina ta să facă treaba.

Indiferent dacă vrei să prevezi piața bursieră sau strategia de vânzări a produselor concurente, extragerea datelor de pe site-uri web folosind ML și DL și specificarea motivului tău reprezintă un pas important spre succes.

SEO

Experții SEO utilizează diverse instrumente pentru a găsi cuvântul cheie potrivit pentru conținut. Cu extragerea datelor folosind un deblocator web, acest proces devine mai ușor. Experții SEO efectuează extragerea de date despre eforturile SEO ale concurenților pentru a înțelege cum funcționează conținutul acestora. Acest lucru te ajută să înțelegi ce modificări trebuie să faci pentru a-ți îmbunătăți SEO.

Testare End-to-End

Dacă ești dezvoltator, extragerea datelor din diferite surse te ajută să îți îmbunătățești eforturile de testare și să economisești timp în procesele care nu vor oferi rezultate.

Deblocatoare Web

Iată câteva dintre cele mai performante programe de deblocare web pe care le poți utiliza pentru a începe să extragi datele necesare.

#1. Date Strălucitoare (Bright Data)

Bright Data oferă un instrument de deblocare web care îți permite să eviți blocările site-urilor în timp real. Deblocatorul web automat gestionează agenții de utilizare a browserului, rezolvarea captcha și cookie-urile. De asemenea, extrage date de pe site-urile web țintă în mod constant, cu ajutorul rotației adreselor IP.

Pentru a utiliza acest program de deblocare web:

- Alege site-ul pe care dorești să îl deblochezi

- Trimite o solicitare proxy simplă împreună cu adresa URL a site-ului și

- Obține datele pe care le cauți

Cu ajutorul deblocatorului web de la Bright Data, nu vei mai fi blocat. Instrumentul dezvoltă automat metode noi pentru a menține site-urile web deschise pentru extragerea datelor în orice moment. De asemenea, gestionează ratele de utilizare a IP-urilor, astfel încât să nu soliciți niciodată prea multe date de la aceeași adresă IP. În plus, emulează dispozitivele pe care serverele doresc să le vadă.

Vei beneficia de o emulare automată a utilizatorului, care include clicuri pe link-urile paginii de pornire vizate, efectuarea de mișcări de mouse umane și multe altele. Web Unlocker asigură că site-ul țintă va percepe că navigarea ta provine de pe un site popular. Mai mult, identifică capcanele „honeypot” și le evită.

#2. Oxylabs

Obține un proces de scraping de date fără blocaje la scară largă cu Web Unblocker de la Oxylabs și accesează date publice de pe site-uri web dificile, plătind doar pentru extragerea cu succes a datelor. Vei beneficia de gestionarea proxy-urilor bazată pe ML, amprentă dinamică a browserului, funcționalitate de reîncercare automată și recunoaștere a răspunsului bazată pe ML.

Oxylabs se asigură că adresa ta IP nu este blocată datorită unei soluții de proxy bazată pe inteligență artificială. Evită sistemele anti-bot cu o rată de succes ridicată și economisește resurse. Amprenta sa dinamică îți permite să vizualizezi conținutul ca un utilizator real.

Web Unblocker de la Oxylabs selectează cookie-urile, anteturile, redarea JavaScript și multe altele potrivite pentru tine, astfel încât să poți obține rezultate fiabile, o navigare similară cu cea a unui utilizator real și să nu te confrunți cu probleme legate de captcha. Indiferent de locația ta, poți accesa conținut localizat din orice loc de pe glob.

Vei găsi peste 102 milioane de proxy-uri generate etic. Instrumentul îți permite să colectezi date publice fără nicio problemă. În plus, vei obține controlul sesiunii, un panou de bord convenabil, scalare ușoară, redare JavaScript și multe altele.

Concluzie

Web scraping este un proces util pentru companii în vederea colectării datelor importante de afaceri și utilizării acestora pentru a-și îmbunătăți operațiunile. Web scrapingul manual este plictisitor și consumă timp, motiv pentru care organizațiile moderne utilizează instrumente de web scraping pentru a automatiza sarcinile de extragere a datelor.

Cu toate acestea, instrumentele de web scraping se confruntă și cu anumite provocări, deoarece tehnologia avansează, iar site-urile web devin mai abile în detectarea și blocarea scraperelor web mai puțin performante. În acest context, un deblocator web poate fi de ajutor, deoarece este o formă avansată de scraper web, care poate ocoli restricțiile, blocările și interdicțiile, contribuind la îmbunătățirea eficienței și eficacității proceselor de web scraping.

Așadar, dacă ești în căutarea unui instrument puternic de web scraping, ia în considerare utilizarea unui deblocator web. Mai sus, am menționat câteva dintre cele mai performante deblocatoare web disponibile pe piață, pe care le poți alege în funcție de cerințele afacerii tale.

De asemenea, poți explora și cele mai bune instrumente de scraping de pe rețelele sociale pentru a extrage date valoroase.