Limbile folosite de oameni reprezintă o provocare considerabilă pentru computere, din cauza complexității lor, incluzând abrevieri, multiple interpretări, subtilități, reguli gramaticale, context, argou și alte aspecte nuanțate.

Cu toate acestea, numeroase operațiuni și procese din sfera afacerilor se bazează pe computere și implică interacțiunea continuă dintre oameni și mașini.

Prin urmare, era necesară o tehnologie care să permită mașinilor să înțeleagă limbajul uman, simplificând procesul de învățare a acestuia de către computere.

Astfel, a apărut procesarea limbajului natural, sau algoritmii NLP. Aceasta a oferit programelor capacitatea de a înțelege diverse limbi umane, indiferent dacă cuvintele sunt scrise sau rostite.

NLP utilizează diverși algoritmi pentru a procesa limbajele. Odată cu introducerea acestor algoritmi, tehnologia a devenit esențială în inteligența artificială (AI), ajutând la gestionarea eficientă a datelor nestructurate.

În acest articol, vom explora NLP și unii dintre cei mai discutați algoritmi din acest domeniu.

Să începem!

Ce este NLP?

Procesarea limbajului natural (NLP) este un domeniu care combină informatica, lingvistica și inteligența artificială, axându-se pe interacțiunea dintre limbajul uman și computere. Scopul principal este de a programa mașinile să analizeze și să proceseze cantități mari de date asociate cu limbajele naturale.

În esență, NLP reprezintă o tehnologie modernă care permite computerelor să înțeleagă, să analizeze și să interpreteze limbajul uman. Aceasta oferă mașinilor abilitatea de a înțelege texte și limbajul vorbit. Prin NLP, computerele pot realiza traduceri, recunoașterea vorbirii, rezumare, segmentarea subiectelor și multe altele, acționând ca un instrument puternic pentru dezvoltatori.

Un aspect remarcabil al NLP este că realizează aceste sarcini în timp real, utilizând o varietate de algoritmi, ceea ce îi conferă o eficiență sporită. Această tehnologie combină învățarea automată, învățarea profundă și modele statistice cu modelarea lingvistică computațională bazată pe reguli.

Algoritmii NLP permit computerelor să prelucreze limbajul uman prin texte sau date vocale și să descifreze semnificația acestuia pentru diverse scopuri. Capacitatea de interpretare a computerelor a evoluat considerabil, permițându-le să înțeleagă chiar și sentimentele și intențiile din spatele unui text. NLP poate anticipa, de asemenea, cuvintele sau propozițiile următoare, pe care un utilizator le are în minte atunci când scrie sau vorbește.

Această tehnologie este prezentă de zeci de ani și a fost continuu îmbunătățită, obținând o precizie tot mai mare. Rădăcinile NLP sunt strâns legate de domeniul lingvisticii, contribuind la dezvoltarea motoarelor de căutare web. Pe măsură ce tehnologia a avansat, aplicațiile NLP s-au extins.

Astăzi, NLP se regăsește într-o gamă largă de domenii, de la finanțe, motoare de căutare și informații de afaceri, până la asistență medicală și robotică. Mai mult, NLP a devenit parte integrantă a sistemelor moderne, fiind folosită în numeroase aplicații populare, cum ar fi GPS-ul vocal, chatbot-urile de servicii pentru clienți, asistența digitală și conversia vorbirii în text.

Cum funcționează NLP?

NLP este o tehnologie dinamică ce utilizează diverse metodologii pentru a traduce limbajul uman complex într-un format inteligibil pentru mașini. Aceasta utilizează în principal inteligența artificială pentru a procesa și transforma cuvintele scrise sau rostite, astfel încât să poată fi înțelese de computere.

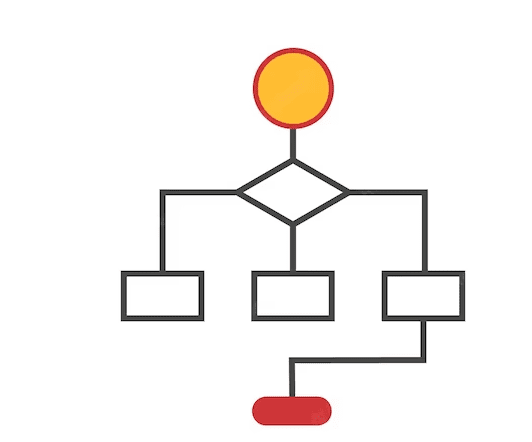

Similar cu modul în care oamenii au un creier pentru procesarea informațiilor, computerele folosesc un program specializat care le ajută să proceseze datele de intrare și să genereze o ieșire ușor de înțeles. NLP funcționează în două etape: procesarea datelor și dezvoltarea algoritmului.

Procesarea datelor este prima etapă, în care datele text introduse sunt pregătite și curățate pentru a fi analizate de mașină. Datele sunt procesate pentru a evidenția toate caracteristicile relevante și a le face potrivite pentru algoritmii de calculator. În esență, această etapă pregătește datele într-o formă pe care mașina o poate înțelege.

Tehnicile implicate în această etapă sunt:

Sursa: Amazinum

- Tokenizare: Textul introdus este segmentat în unități mai mici, numite token-uri, pentru a fi prelucrat de NLP.

- Eliminarea cuvintelor de legătură: Această tehnică îndepărtează cuvintele comune din text (de exemplu, „și”, „sau”, „a”) pentru a reduce zgomotul și a permite algoritmului să se concentreze pe cuvintele cheie.

- Lemmatizare și stemming: Aceste procese reduc cuvintele la forma lor de bază (lemă) sau la rădăcina lor, simplificând analiza și procesarea.

- Etichetarea părților de vorbire: Cuvintele introduse sunt etichetate în funcție de rolul lor gramatical (substantiv, adjectiv, verb), ceea ce ajută la o înțelegere mai profundă a contextului.

După ce datele de intrare trec prin prima fază, mașina dezvoltă un algoritm prin care le poate procesa. Dintre toți algoritmii NLP utilizați pentru procesarea cuvintelor preprocesate, sistemele bazate pe reguli și pe învățare automată sunt utilizate pe scară largă:

- Sisteme bazate pe reguli: Aici, sistemul utilizează reguli lingvistice definite pentru a procesa cuvintele. Este o abordare mai veche, dar încă folosită pe scară largă.

- Sisteme bazate pe învățare automată: Aceste sisteme avansate combină rețele neuronale, învățarea profundă și învățarea automată pentru a stabili propriile reguli de procesare a cuvintelor. Algoritmul ia decizii pe baza datelor de antrenament și se adaptează continuu.

Categorii de algoritmi NLP

Algoritmii NLP sunt instrucțiuni bazate pe învățare automată (ML) utilizate pentru procesarea limbajului natural. Ei se concentrează pe dezvoltarea de protocoale și modele care permit mașinilor să înțeleagă limbajele umane.

Algoritmii NLP pot varia în funcție de abordarea inteligenței artificiale și de datele de antrenament utilizate. Sarcina principală a acestor algoritmi este de a transforma datele nestructurate și ambigue în informații utile, din care mașina poate învăța.

Alături de diverse tehnici, algoritmii NLP aplică principii lingvistice pentru a face datele de intrare mai ușor de înțeles pentru mașini. Ei ajută mașina să înțeleagă valoarea contextuală a datelor de intrare, lucru esențial pentru a executa cererile.

Algoritmii NLP se împart în trei categorii de bază, modelele AI alegând categoria adecvată în funcție de abordarea cercetătorului. Aceste categorii sunt:

#1. Algoritmi simbolici

Algoritmii simbolici reprezintă o parte fundamentală a procesării limbajului natural. Ei analizează semnificația fiecărui text introdus și stabilesc relații între diverse concepte.

Acești algoritmi folosesc simboluri pentru a reprezenta cunoștințe și relații între concepte. Prin aplicarea logicii și atribuirea de semnificații cuvintelor în funcție de context, se poate obține un nivel înalt de acuratețe.

Graficele de cunoștințe joacă un rol crucial în definirea conceptelor și a relațiilor dintre ele. Datorită capacității sale de a defini corect conceptele și de a înțelege contextul, acest algoritm este util în construirea inteligenței artificiale explicabile (XAI).

Cu toate acestea, algoritmii simbolici sunt dificil de extins din cauza diverselor limitări.

#2. Algoritmi statistici

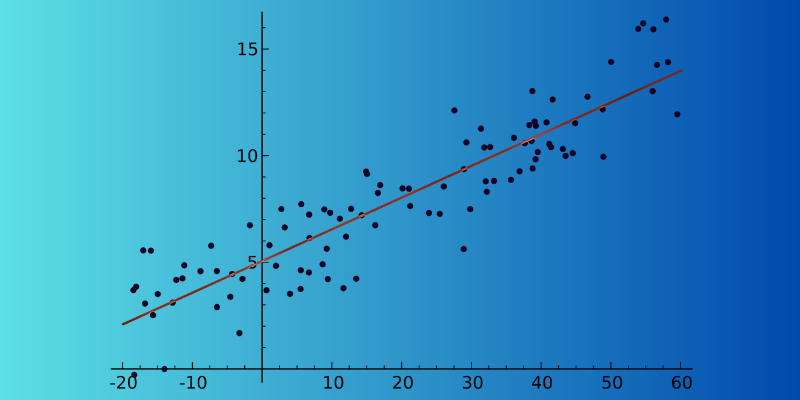

Algoritmii statistici ușurează procesul de înțelegere a textelor pentru mașini, ajutându-le să recunoască tiparele și tendințele din datele introduse. Această analiză permite mașinilor să anticipeze cuvintele următoare în timp real.

De la recunoașterea vorbirii, analiza sentimentelor și traducerea automată până la sugestiile de text, algoritmii statistici sunt folosiți în multe aplicații. Un motiv important pentru utilizarea lor extinsă este capacitatea lor de a procesa seturi mari de date.

Acești algoritmi pot determina dacă două propoziții dintr-un paragraf au înțelesuri similare și pe care să o folosească. Un dezavantaj este că depind parțial de o inginerie complexă a caracteristicilor.

#3. Algoritmi hibrizi

Acești algoritmi combină avantajele algoritmilor simbolici și statistici pentru a produce rezultate eficiente. Prin concentrarea pe beneficiile și caracteristicile principale, pot atenua limitările oricărei abordări, lucru esențial pentru o precizie ridicată.

Există mai multe moduri în care cele două abordări pot fi combinate:

- Suport simbolic pentru învățarea automată

- Învățarea automată susține abordarea simbolică

- Învățarea simbolică și învățarea automată funcționează în paralel

Algoritmii simbolici pot susține învățarea automată, ajutând la antrenarea modelului astfel încât să fie mai ușor să învețe limba. Învățarea automată poate genera un set inițial de reguli pentru abordarea simbolică, scutind cercetătorul de date de la crearea manuală a acestora.

Când învățarea simbolică și învățarea automată funcționează împreună, rezultatele sunt mai bune, asigurând că modelele înțeleg corect un anumit pasaj.

Cei mai buni algoritmi NLP

Există numeroși algoritmi NLP care ajută computerele să simuleze limbajul uman pentru înțelegere. Iată câțiva dintre cei mai utili algoritmi NLP:

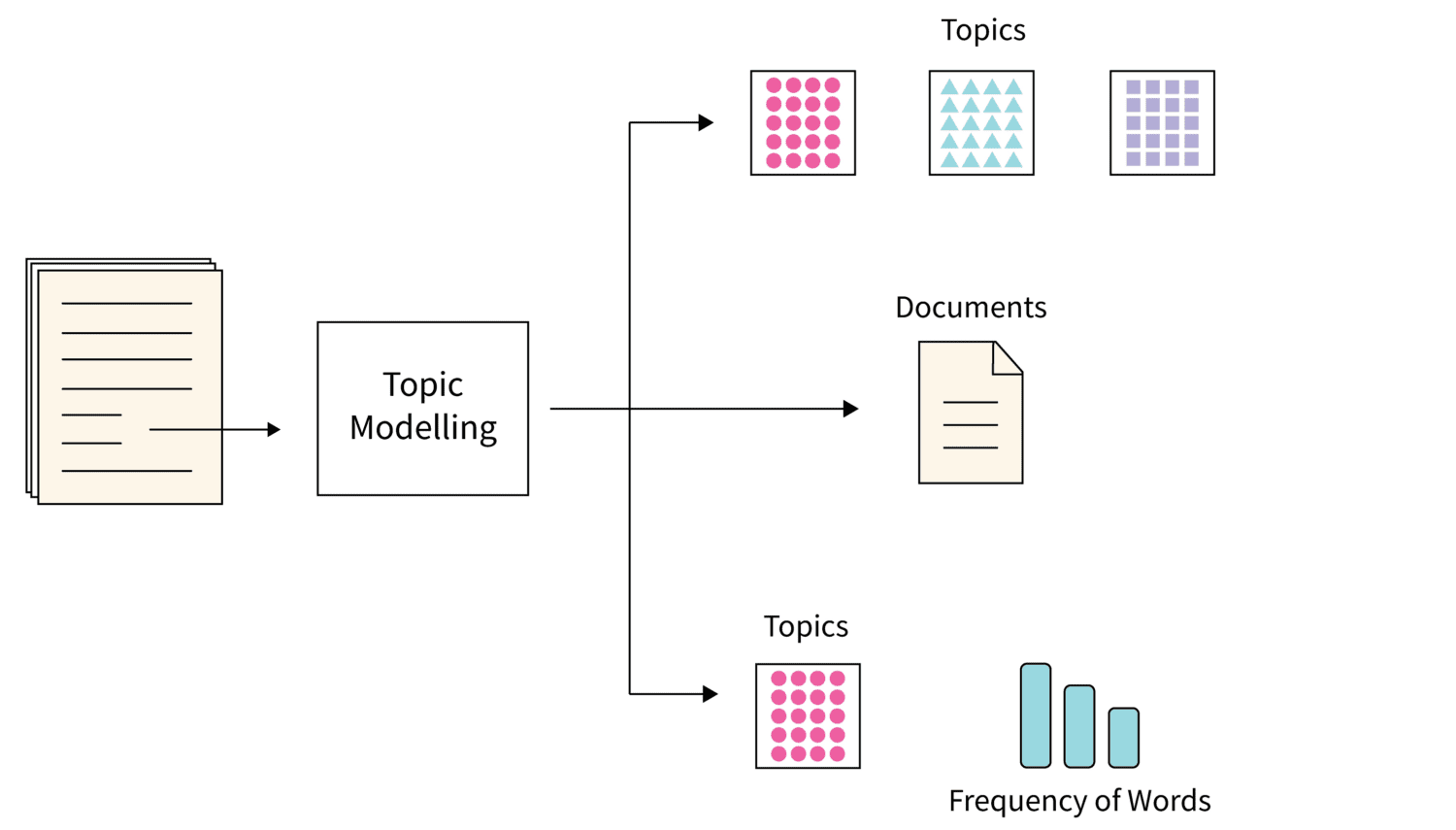

#1. Modelarea topicelor

Sursa imagine: Scaler

Sursa imagine: Scaler

Modelarea topicelor utilizează tehnici statistice NLP pentru a descoperi temele sau subiectele principale dintr-un set mare de documente text.

Această tehnică ajută mașinile să identifice subiectul care definește un anumit set de texte. Algoritmul utilizează diverse tehnici pentru a descoperi subiectele, evaluând seturi specifice de cuvinte.

Alocarea Dirichlet latentă este o tehnică populară pentru modelarea topicelor, fiind un algoritm de învățare automată nesupravegheată care ajută la organizarea arhivelor de date, lucru dificil de realizat manual.

#2. Rezumatul textului

Aceasta este o tehnică NLP care condensează un text lung într-un rezumat fluent. Rezumarea permite extragerea rapidă a informațiilor cheie, fără a citi fiecare cuvânt.

Rezumarea se poate face în două moduri:

- Rezumat bazat pe extracție: Algoritmul extrage cuvintele și frazele principale din text, fără a le modifica.

- Rezumat bazat pe abstracție: Sunt create cuvinte și fraze noi din documentul text original, care prezintă informațiile principale.

#3. Analiza sentimentelor

Acest algoritm NLP ajută o mașină să înțeleagă sensul sau intenția unui text, fiind foarte folosit în diverse modele de afaceri AI, deoarece ajută companiile să înțeleagă opinia clienților despre produse sau servicii.

Prin înțelegerea sentimentelor clienților din diverse surse, modelele AI oferă informații valoroase, ajutând companiile să răspundă eficient.

#4. Extragerea cuvintelor cheie

Extragerea cuvintelor cheie este un alt algoritm NLP popular care identifică cuvinte și expresii relevante dintr-un set mare de date text.

Există diverși algoritmi de extragere a cuvintelor cheie, precum TextRank, Term Frequency și RAKE. Unii algoritmi pot include cuvinte suplimentare, în timp ce alții se concentrează pe cuvintele cheie bazate pe conținutul textului.

Fiecare algoritm are propriile metode teoretice. Această tehnică este utilă pentru organizații, deoarece ajută la stocarea, căutarea și preluarea informațiilor din seturi mari de date nestructurate.

#5. Grafice de cunoștințe

Algoritmii de grafic de cunoaștere sunt o tehnică excelentă pentru stocarea informațiilor prin tripleți (subiect, predicat și entitate). Aceștia sunt compuși din mai multe tehnici NLP pentru a fi eficienți și detaliați, permițând extragerea de informații structurate din texte nestructurate.

#6. TF-IDF

TF-IDF este un algoritm statistic NLP care evaluează importanța unui cuvânt într-un document dintr-o colecție mare. Această tehnică implică multiplicarea a două valori:

- Frecvența termenului: Numărul de apariții ale unui cuvânt într-un anumit document. Cuvintele de legătură au, de obicei, o frecvență mare.

- Frecvența inversă a documentelor: Aceasta evidențiază cuvintele specifice unui document sau cuvintele care apar mai rar într-un set mare de documente.

#7. Norul de cuvinte

Norul de cuvinte este un algoritm NLP unic care vizualizează datele, evidențiind cuvintele importante într-un tabel. Cuvintele esențiale apar cu fonturi mai mari, în timp ce cuvintele mai puțin importante sunt afișate cu fonturi mai mici sau chiar sunt omise din tabel.

Resurse de învățare

Pentru a aprofunda cunoștințele despre procesarea limbajului natural (NLP), puteți consulta următoarele cursuri și cărți:

#1. Știința datelor: Procesarea limbajului natural în Python

Acest curs de pe Udemy, creat de Lazy Programmer Inc., oferă o introducere completă în NLP și algoritmii NLP, învățându-vă cum să realizați analiza sentimentelor. Cu o durată de 11 ore și 52 de minute, cursul include 88 de lecții.

#2. Procesarea limbajului natural: NLP cu transformatoare în Python

Acest curs de pe Udemy oferă o perspectivă aprofundată asupra NLP cu modele transformatoare, cu posibilitatea de a crea modele transformatoare personalizate. Cursul cuprinde 11,5 ore de videoclipuri la cerere și 5 articole, oferind o acoperire completă a NLP și a tehnicilor de preprocesare a datelor text.

#3. Procesarea limbajului natural cu transformatoare

Această carte din 2017 ajută cercetătorii și programatorii să învețe despre NLP. Veți învăța cum să construiți și să optimizați modele transformatoare pentru diverse sarcini NLP, dar și cum să folosiți transformatoare pentru învățarea prin transfer interlingvistic.

#4. Procesarea practică a limbajului natural

În această carte, autorii explică sarcinile, problemele și abordările de soluționare din domeniul NLP, împreună cu implementarea și evaluarea diferitelor aplicații NLP.

Concluzie

NLP este o componentă esențială a inteligenței artificiale moderne, ajutând mașinile să înțeleagă și să interpreteze limbajele umane. Algoritmii NLP sunt utili într-o gamă largă de domenii, de la motoarele de căutare și IT până la finanțe, marketing și altele.

În plus, am inclus câteva dintre cele mai bune cursuri și cărți NLP care vă vor ajuta să vă aprofundați cunoștințele în acest domeniu.