Pentru cei care nu sunt inițiați în programare, construirea unui instrument de web scraping poate părea o sarcină complexă. Din fericire, există soluții software accesibile, concepute special pentru această activitate, atât pentru experți, cât și pentru cei fără cunoștințe tehnice avansate. Aceste programe facilitează extragerea eficientă a datelor de pe diverse site-uri web, oferind posibilitatea de a le salva local pe computer sau într-o bază de date. În esență, web scraping-ul este o tehnică automată de colectare a informațiilor de pe internet, iar noi vă prezentăm o listă cu 31 dintre cele mai bune instrumente gratuite disponibile.

Top 31 Instrumente de Web Scraping

Mai jos veți găsi o selecție atentă a celor mai performante instrumente de web scraping, incluzând atât soluții comerciale, cât și open-source, alături de link-uri către site-urile lor oficiale.

1. Outwit

Outwit este un add-on pentru Firefox, ușor de instalat direct din magazinul de extensii.

- Acest instrument simplifică extragerea informațiilor de contact, atât de pe paginile web, cât și din e-mailuri.

- Oferă trei variante de achiziție, adaptate diferitelor necesități:

- Ediția Pro

- Ediția Expert

- Ediția Enterprise

- Nu necesită cunoștințe de programare pentru a extrage date precise de pe site-uri web folosind hub-ul Outwit.

- Cu un singur clic pe butonul de navigare, puteți începe procesul de scraping pe sute de pagini web.

2. ParseHub

ParseHub este un alt instrument de top pentru web scraping gratuit.

- Permite curățarea textului și a codului HTML înainte de a descărca datele.

- Extragerea datelor dorite este simplă, datorită interfeței intuitive.

- Datele colectate pot fi stocate în diverse formate, facilitând analiza ulterioară.

- Interfață grafică ușor de utilizat.

- Acest instrument permite colectarea și salvarea automată a datelor pe servere.

3. Apify

Apify este un instrument avansat de automatizare și web scraping, care vă permite să creați API-uri pentru orice site web. Include proxy-uri rezidențiale și de centre de date, facilitând extragerea eficientă a informațiilor.

- Apify se ocupă de infrastructură și facturare, oferind dezvoltatorilor posibilitatea de a genera venituri pasive prin crearea de instrumente pentru alții.

- Oferă conexiuni cu diverse platforme, inclusiv Zapier, Integromat, Keboola și Airbyte.

- Magazinul Apify conține soluții de scraping preconfigurate pentru platforme populare precum Instagram, Facebook, Twitter și Google Maps.

- Permite descărcarea datelor în formate structurate precum JSON, XML, CSV, HTML și Excel.

- Caracteristicile Apify Proxy includ HTTPS, direcționarea geografică, rotația inteligentă a IP-urilor și proxy-urile Google SERP.

- Ofera o perioadă de probă gratuită de 30 de zile, cu un credit de 5 USD.

4. Scrapestack

Scrapestack, folosit de peste 2000 de companii, este un API unic bazat pe tehnologia apilayer, fiind un instrument excelent pentru web scraping.

- Utilizează o rețea globală de 35 de milioane de adrese IP din centre de date.

- Permite executarea simultană a mai multor cereri API.

- Suportă atât decriptarea CAPTCHA, cât și redarea JavaScript.

- Oferă atât planuri gratuite, cât și plătite.

- Scrapestack este un API REST pentru scraping online care funcționează în timp real.

- API-ul scrapestack vă permite să preluați date de pe pagini web în câteva milisecunde folosind milioane de adrese IP proxy, browsere și funcții de decriptare CAPTCHA.

- Solicitările de web scraping pot fi efectuate din peste 100 de locații din întreaga lume.

5. FMiner

FMiner este un software popular pentru Windows și Mac OS, conceput pentru web scraping, extragere de date, crawling, macro-uri și automatizarea sarcinilor web.

- Poate colecta date de pe site-uri web dinamice, de tip Web 2.0.

- Permite crearea de proiecte de extragere a datelor folosind un editor vizual intuitiv.

- Folosește o combinație de structuri de link-uri, meniuri derulante și potrivire de modele URL pentru a naviga prin paginile web.

- Integrează servicii automate de decriptare captcha terțe sau permite introducerea manuală a acestora.

6. Sequentum

Sequentum este un instrument eficient pentru gestionarea datelor mari, oferind o soluție de încredere pentru colectarea de informații online.

- Permite extragerea rapidă a datelor online.

- Oferă funcționalitatea de a comuta între diferite platforme.

- Dispune de un editor vizual simplu de tip punct-și-clic.

- API-ul web dedicat ajută la dezvoltarea de aplicații web, permițând executarea directă a datelor web de pe site-ul dvs.

7. Agenty

Agenty este un instrument de colectare a datelor, extragere a textului și OCR care utilizează automatizarea robotică a proceselor.

- Permite reutilizarea datelor prelucrate în scopuri de analiză.

- Oferă posibilitatea de a construi un agent în doar câteva clicuri de mouse.

- Trimite notificări prin e-mail la finalizarea sarcinilor.

- Permite conectarea cu Dropbox și utilizarea FTP securizat.

- Oferă acces la jurnalele de activitate.

- Ajută la îmbunătățirea performanțelor afacerii.

- Permite implementarea cu ușurință a regulilor de business și a logicii personalizate.

8. Import.io

Import.io este o aplicație de web scraping care vă ajută să creați seturi de date prin importul informațiilor de pe o pagină web și exportul acestora în format CSV.

- Simplifică utilizarea formularelor și login-urilor web.

- Oferă integrarea datelor în aplicații prin intermediul API-urilor și webhook-urilor.

- Permite obținerea de informații prin rapoarte, grafice și vizualizări.

- Oferă funcții de planificare a extragerii datelor.

- Import.io cloud permite stocarea și accesarea datelor.

- Permite automatizarea interacțiunii cu web-ul și fluxurilor de lucru.

9. Webz.io

Webz.io oferă acces la date structurate și în timp real prin crawling-ul a sute de site-uri web. Este un instrument excelent pentru web scraping gratuit.

Permite achiziționarea de seturi de date organizate, în formate JSON și XML, care pot fi citite de mașină.

- Oferă acces la date istorice de peste zece ani.

- Permite accesul la o bază de date vastă de fluxuri de date fără costuri suplimentare.

- Utilizează un filtru avansat pentru a efectua analize detaliate.

10. Scrapeowl

Scrape Owl este o platformă de web scraping ușor de utilizat și economică.

- Este conceput pentru a prelua diverse tipuri de date, inclusiv din magazine online, site-uri de recrutare și liste imobiliare.

- Permite rularea de scripturi JavaScript personalizate înainte de extragerea datelor.

- Utilizează localizarea geografică pentru a ocoli restricțiile și a accesa conținut local.

- Oferă o funcție de așteptare fiabilă.

- Suportă redarea JavaScript pe întreaga pagină.

- Poate fi utilizat direct într-o foaie de calcul Google.

- Ofera o perioadă de probă gratuită de 1000 de credite.

11. Scrapingbee

Scrapingbee este un API pentru web scraping care gestionează setările proxy și browserele fără interfață grafică.

- Poate executa Javascript pe pagini și rotește proxy-urile pentru fiecare solicitare.

- Oferă un API separat pentru extragerea rezultatelor din căutările Google.

- Suportă redarea JavaScript.

- Oferă rotație automată a proxy-urilor.

- Poate fi utilizat direct în Google Sheets.

- Utilizează browser-ul Chrome.

- Este ideal pentru scraping-ul Amazon.

- Permite colectarea rezultatelor de căutare Google.

12. Bright Data

Bright Data este o platformă lider în domeniul datelor online, oferind soluții eficiente pentru colectarea datelor publice de pe web, conversia datelor nestructurate în date structurate și o experiență superioară pentru clienți, respectând totodată transparența și conformitatea.

- Oferă soluții preconfigurate, extensibile și personalizabile.

- Permite un flux automat și personalizat de date prin intermediul unui tablou de bord unic.

- Oferă asistență pentru clienți 24/7.

- Furnizează seturi de date adaptate nevoilor afacerii dvs., de la tendințe în comerțul electronic la informații despre concurență.

- Permite automatizarea accesului la date fiabile din industrie, permițându-vă să vă concentrați asupra activității principale.

- Folosește soluții fără cod și consumă mai puține resurse.

- Oferă date de înaltă calitate, timp de funcționare mare și servicii superioare pentru clienți.

13. Scraper API

API Scraper este un instrument care vă ajută să gestionați proxy-urile, browserele și CAPTCHA.

- Oferă viteză și fiabilitate, permițând construirea de web scrapere scalabile.

- Permite obținerea codului HTML al oricărei pagini web printr-un singur apel API.

- Este simplu de configurat, prin trimiterea unei cereri GET cu cheia API și adresa URL.

- Facilitează redarea JavaScript.

- Oferă posibilitatea de personalizare a tipului de cerere și a antetelor.

- Asigură rotația proxy-urilor cu localizare geografică.

14. Dexi Intelligent

Dexi intelligent este o aplicație de web scraping care vă permite să transformați cantități mari de date web în valoare comercială rapidă.

- Ajută la economisirea de timp și bani.

- Îmbunătățește productivitatea, precizia și calitatea.

- Oferă o extragere rapidă și eficientă a datelor.

- Dispune de un sistem de captare a cunoștințelor la scară largă.

15. Diffbot

Diffbot vă permite să obțineți rapid informații importante de pe internet.

- Extractoarele AI permit extragerea datelor structurate precise de la orice adresă URL.

- Nu se percepe taxă pentru scraping sau interogări manuale.

- Datele din mai multe surse sunt combinate pentru a oferi o imagine completă și precisă a fiecărui element.

- Crawlbot permite extinderea extragerii pe zeci de mii de domenii.

- Knowledge Graph oferă date precise pentru BI.

16. Data Streamer

Data Streamer este o tehnologie care permite preluarea datelor de pe rețelele sociale de pe internet.

- Utilizează procesarea limbajului natural pentru a prelua metadate importante.

- Folosește Kibana și Elasticsearch pentru a oferi căutare integrată full-text.

- Este bazat pe algoritmi de regăsire a informațiilor, eliminarea standardelor integrate și extragerea conținutului.

- Oferă o infrastructură rezistentă la erori pentru a asigura o disponibilitate ridicată a informațiilor.

17. Mozenda

Mozenda permite extragerea textului, fotografiilor și materialelor PDF de pe pagini web.

- Permite colectarea și publicarea datelor folosind instrumentul sau baza de date dorită.

- Facilitează organizarea și formatarea fișierelor de date pentru publicare.

- Oferă o interfață punct-și-clic pentru a crea agenți de scraping în câteva minute.

- Folosește funcțiile Job Sequencer și Request Blocking pentru a colecta date web în timp real.

- Oferă gestionarea conturilor și asistență pentru clienți de înaltă calitate.

18. Data Miner – Extensie Chrome

Plugin-ul de browser Data Miner simplifică web scraping-ul și capturarea datelor.

- Oferă crawling pe mai multe pagini și extragere dinamică de date.

- Permite selectarea datelor în diverse moduri.

- Analizează informațiile colectate.

- Datele extrase pot fi salvate în format CSV.

- Utilizează stocarea locală pentru datele colectate.

- Extrage date de pe site-uri dinamice.

- Permite importarea și exportarea sitemap-urilor.

19. Scrapy

Scrapy este un framework open-source de web scraping bazat pe Python.

- Oferă instrumentele necesare pentru extragerea rapidă a datelor de pe site-uri web, analiza și salvarea acestora în formatul dorit.

- Este ideal pentru proiecte mari de data scraping care necesită eficiență și flexibilitate.

- Datele pot fi exportate în formate JSON, CSV sau XML.

- Este compatibil cu Linux, Mac OS X și Windows.

- Se bazează pe tehnologia de rețea asincronă Twisted.

- Se remarcă prin ușurința în utilizare, documentația extinsă și comunitatea activă.

20. ScrapeHero Cloud

ScrapeHero a transformat ani de experiență în crawling web în crawlere și API-uri prefabricate, economice și ușor de utilizat, pentru extragerea datelor de pe site-uri precum Amazon, Google și Walmart.

- Crawlerele ScrapeHero Cloud includ proxy-uri cu rotire automată și posibilitatea de a rula mai multe crawlere simultan.

- Nu este necesară descărcarea sau învățarea utilizării instrumentelor de scraping.

- Permite extragerea instantanee a datelor și exportul în formate JSON, CSV sau Excel.

- Oferă asistență prin e-mail pentru planurile Free și Lite, iar planurile superioare beneficiază de suport prioritar.

- Crawlerele pot fi configurate pentru a satisface cerințele specifice ale clienților.

- Este un web scraper bazat pe browser, compatibil cu orice browser web.

- Nu necesită cunoștințe de programare.

21. Data Scraper

Data Scraper este o aplicație gratuită de web scraping care extrage datele de pe o singură pagină web și le salvează ca fișiere CSV sau XSL.

- Este o extensie de browser care convertește datele într-un format tabelar ordonat.

- Necesită instalarea în browser-ul Google Chrome.

- Versiunea gratuită permite scraping-ul a 500 de pagini pe lună; pentru un volum mai mare, este necesară actualizarea la un plan plătit.

22. Visual Web Ripper

Visual Web Ripper este un instrument automat de colectare a datelor de pe site-uri web.

- Extrage structuri de date de pe site-uri web sau din rezultatele căutărilor.

- Permite exportul datelor în fișiere CSV, XML și Excel.

- Este compatibil cu site-uri web dinamice, cum ar fi cele care utilizează AJAX.

- Necesită doar configurarea câtorva șabloane, restul fiind automatizat.

- Oferă opțiuni de programare și trimite notificări prin e-mail în caz de eșec al unui proiect.

23. Octoparse

Octoparse este o aplicație de web scraping ușor de utilizat, cu o interfață vizuală. Este un instrument de top pentru web scraping gratuit.

- Interfața sa de tip punct-și-clic simplifică selecția informațiilor de extras. Octoparse gestionează atât pagini web statice, cât și dinamice, utilizând tehnologii precum AJAX, JavaScript și cookie-uri.

- Oferă servicii cloud avansate pentru extragerea unor cantități mari de date.

- Datele extrase pot fi salvate în formate TXT, CSV, HTML sau XLSX.

- Versiunea gratuită permite construirea a până la 10 crawlere; planurile plătite includ funcții precum un API și un număr mare de proxy IP anonimi.

24. Web Harvey

WebHarvey include un browser încorporat pentru web scraping. Este un instrument de top pentru web scraping.

- Oferă o interfață de tip punct-și-clic pentru selectarea articolelor.

- Nu necesită scrierea de cod.

- Permite salvarea datelor în fișiere CSV, JSON și XML.

- Oferă posibilitatea de a salva datele și într-o bază de date SQL.

- Dispune de o funcție de colectare a datelor pe mai multe niveluri.

- Permite utilizarea expresiilor regulate.

- Suportă configurarea serverelor proxy.

25. PySpider

PySpider este un crawler web bazat pe Python, fiind un instrument excelent pentru web scraping gratuit.

- Dispune de arhitectură distribuită și suport pentru paginile JavaScript.

- Permite rularea mai multor crawlere simultan.

- Poate stoca date pe diverse back-end-uri, precum MongoDB, MySQL și Redis.

- Suportă cozi de mesaje, inclusiv RabbitMQ și Beanstalk.

- Oferă o interfață simplă pentru modificarea scripturilor, monitorizarea activităților și examinarea rezultatelor.

- Datele pot fi descărcate în formate JSON și CSV.

- Este potrivit pentru site-uri web cu o interfață bazată pe web, inclusiv cele care utilizează AJAX.

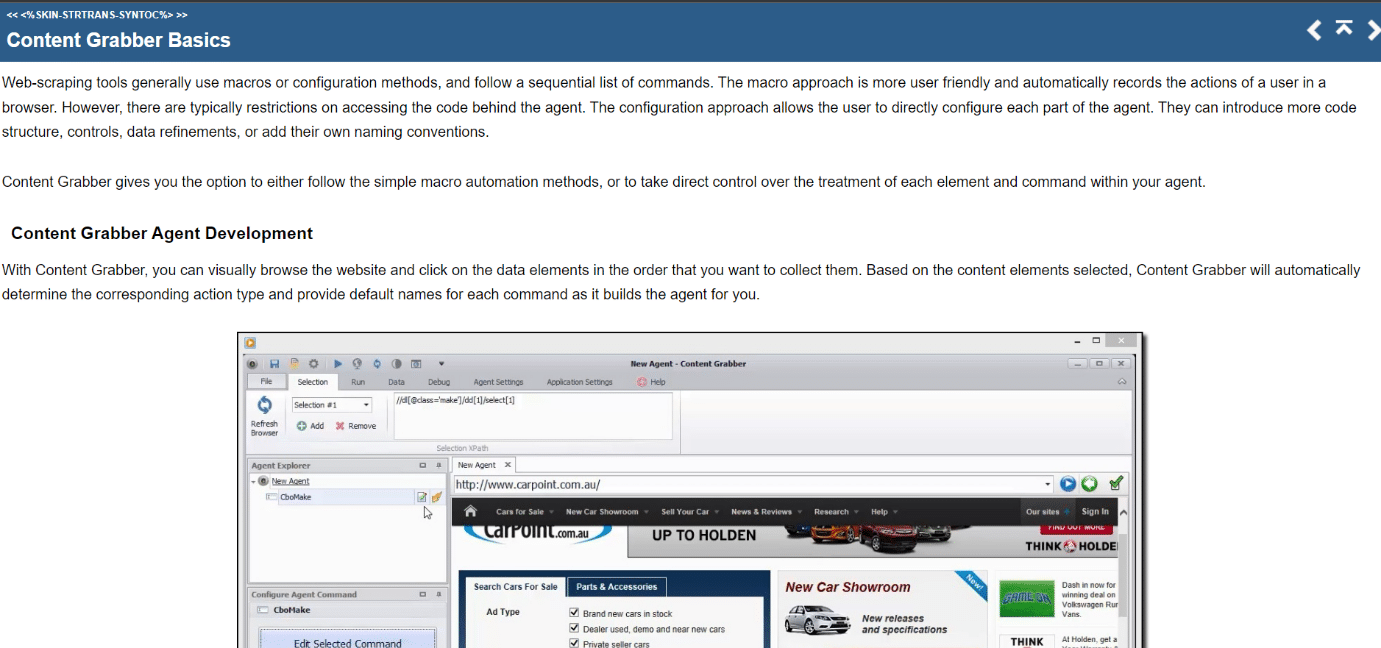

26. Content Grabber

Content Grabber este un instrument vizual de web scraping cu o interfață de tip punct-și-clic.

- Permite exportul datelor în formate CSV, XLSX, JSON și PDF.

- Necesită abilități de programare intermediare.

- Permite paginarea, paginile de defilare fără limite și ferestrele pop-up.

- Oferă procesare AJAX/JavaScript, o soluție captcha, suport pentru expresii regulate și rotație IP.

27. Kimurai

Kimurai este un framework Ruby pentru web scraping, fiind un instrument de top pentru web scraping gratuit.

- Permite interacțiunea cu paginile web create cu JavaScript, folosind Headless Chromium/Firefox, PhantomJS sau HTTP.

- Oferă opțiuni configurabile, inclusiv setarea unei întârzieri, rotația agenților utilizator și antete implicite.

- Interacționează cu paginile web folosind framework-ul de testare Capybara.

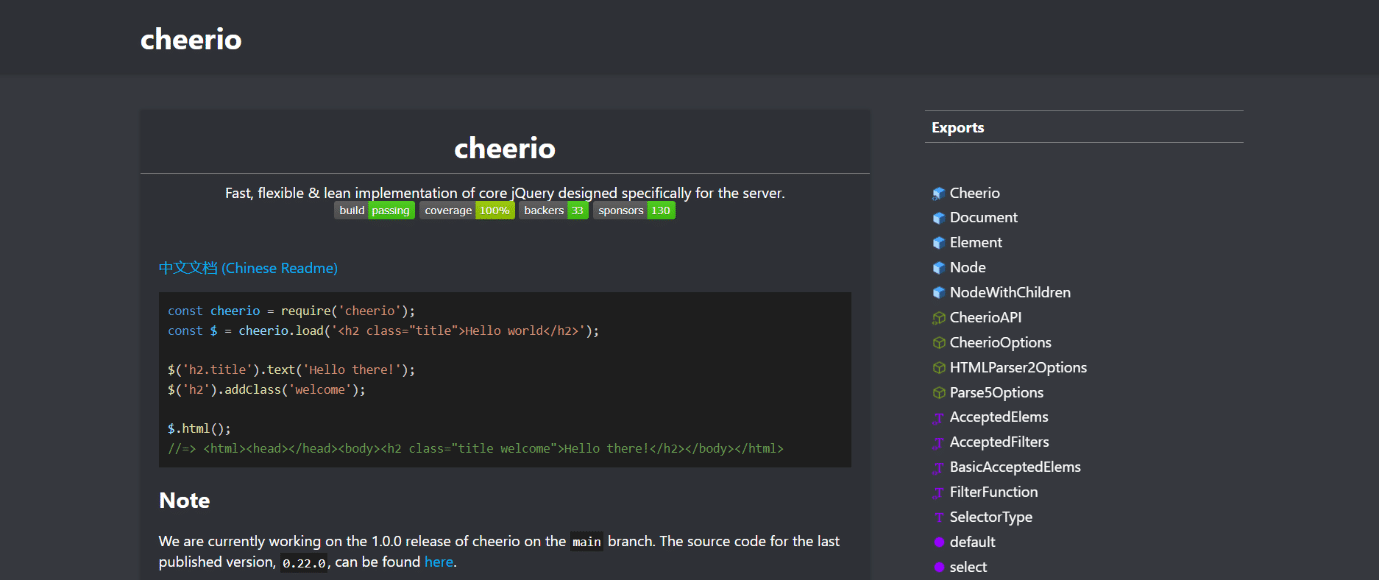

28. Cheerio

Cheerio este un pachet care analizează documente HTML și XML și permite manipularea datelor descărcate folosind sintaxa jQuery.

- Oferă o soluție rapidă pentru analiza, modificarea și afișarea datelor în web scraper-ele JavaScript.

- Nu afișează rezultatul într-un browser web, nu aplică CSS, nu încarcă resurse externe sau nu rulează JavaScript.

- Pentru aceste funcționalități suplimentare, se recomandă utilizarea PhantomJS sau JSDom.

29. Puppeteer

Puppeteer este un pachet Node care vă permite să controlați browser-ul Chrome fără interfață grafică, folosind un API simplu, dar puternic.

- Funcționează în fundal, executând comenzi printr-un API.

- Un browser fără interfață grafică este capabil să trimită și să primească solicitări, dar nu are o interfață cu utilizatorul.

- Este recomandat dacă informațiile sunt generate folosind o combinație de date API și cod Javascript