Căutați instrumente pentru a vă îmbunătăți clasarea SEO, expunerea și conversiile? Pentru a face acest lucru, aveți nevoie de un instrument de crawler web. Un web crawler este un program de calculator care scanează Internetul. Păianjenii web, software-ul de extragere a datelor web și programele de răzuire a site-urilor web sunt exemple de tehnologii de accesare cu crawlere pe internet. Este cunoscut și ca spider bot sau spider. Astăzi, ne vom uita la câteva instrumente gratuite de crawler web de descărcat.

Cuprins

Cele mai bune 25 de instrumente gratuite de crawler web

Instrumentele web crawler oferă o mulțime de informații pentru extragerea și analiza datelor. Scopul său principal este de a indexa paginile web de pe Internet. Poate detecta link-uri întrerupte, conținut duplicat și titluri lipsă ale paginilor și poate identifica probleme grave de SEO. Recuperarea datelor online poate aduce beneficii afacerii dvs. într-o varietate de moduri.

- Mai multe aplicații de crawler web pot accesa cu crawlere corect date de la orice adresă URL a site-ului web.

- Aceste programe vă ajută să îmbunătățiți structura site-ului dvs., astfel încât motoarele de căutare să-l poată înțelege și să vă îmbunătățească clasamentul.

În lista cu instrumentele noastre de top, am compilat o listă de descărcare gratuită a instrumentelor de crawler web, precum și caracteristicile și costurile acestora, din care puteți alege. Lista include și aplicațiile plătibile.

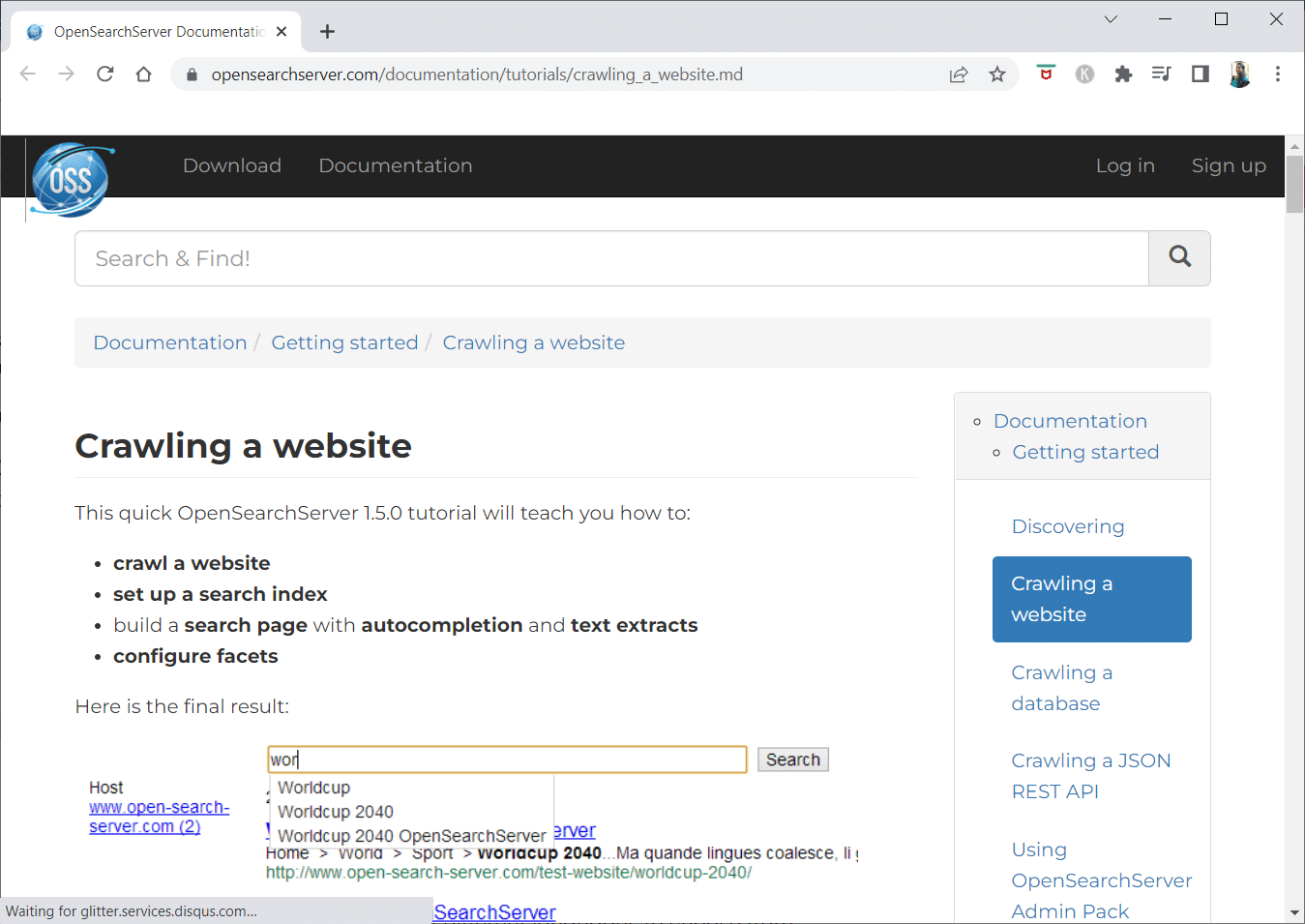

1. Deschideți Search Server

OpenSearchServer este un crawler web gratuit și are una dintre cele mai bune evaluări de pe Internet. Una dintre cele mai bune alternative disponibile.

- Este o soluție complet integrată.

- Open Search Server este un motor de căutare și accesare cu crawlere pe web care este gratuit și open source.

- Este o soluție unică și rentabilă.

- Vine cu un set cuprinzător de capabilități de căutare și posibilitatea de a vă construi propria strategie de indexare.

- Crawlerele pot indexa aproape orice.

- Există căutări full-text, booleene și fonetice din care puteți alege.

- Puteți alege din 17 limbi diferite.

- Se fac clasificări automate.

- Puteți crea un orar pentru lucrurile care se întâmplă frecvent.

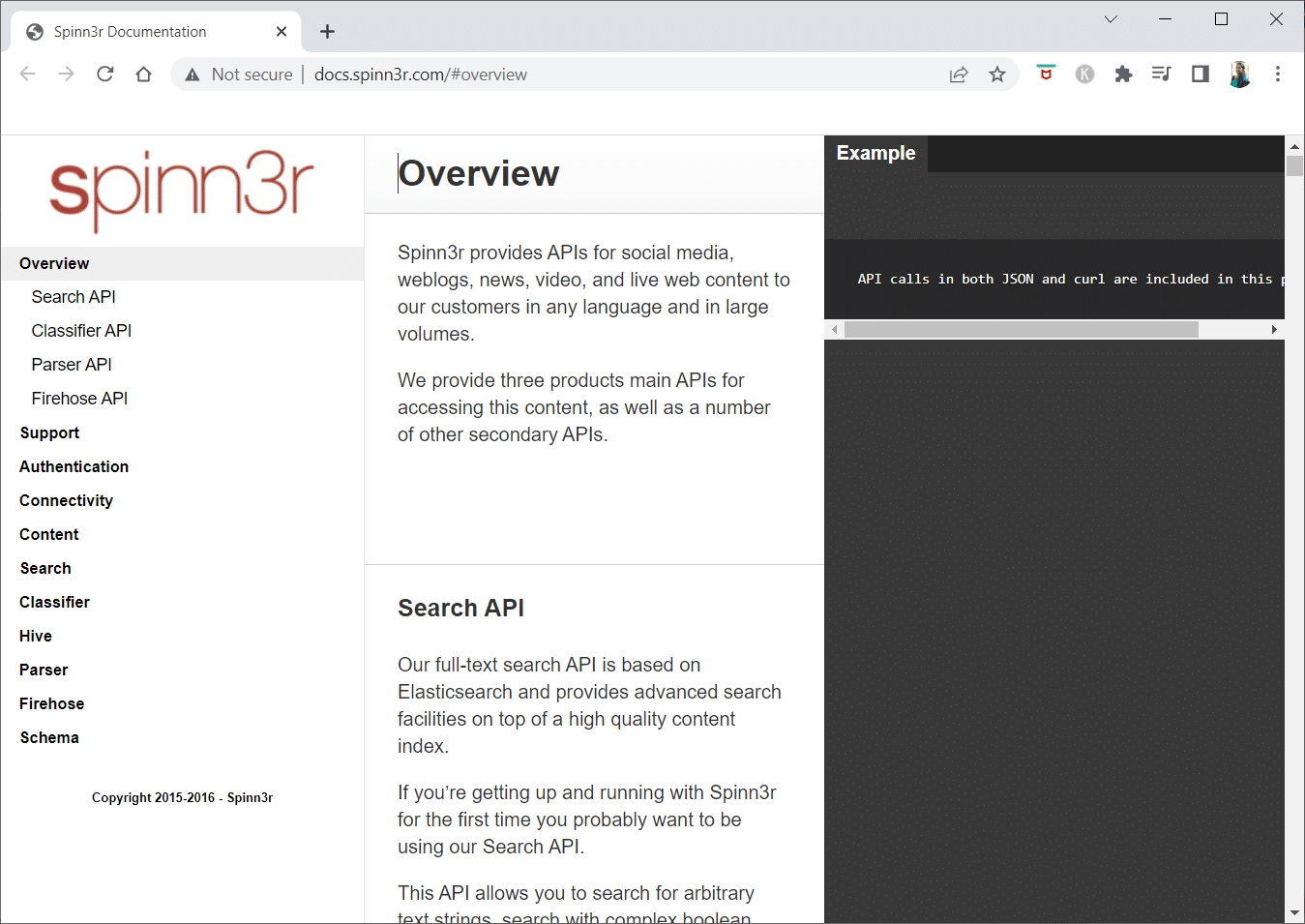

2. Spinn3r

Programul de crawler web Spinn3r vă permite să extrageți complet conținut de pe bloguri, știri, site-uri de rețele sociale, fluxuri RSS și fluxuri ATOM.

- Vine cu un API fulgerător care se ocupă de 95% din munca de indexare.

- Protecția avansată împotriva spamului este inclusă în această aplicație de accesare cu crawlere, care elimină spam-ul și utilizarea necorespunzătoare a limbii, îmbunătățind securitatea datelor.

- Web scraper-ul caută continuu web-ul pentru actualizări din numeroase surse pentru a vă prezenta conținut în timp real.

- Acesta indexează conținutul în același mod ca și Google, iar datele extrase sunt salvate ca fișiere JSON.

- API-ul Parser vă permite să analizați și să gestionați rapid informații pentru adrese URL web arbitrare.

- API-ul Firehose este proiectat pentru acces în masă la volume enorme de date.

-

Antetele HTTP simple sunt folosite pentru a autentifica toate API-urile Spinn3r.

- Acesta este un instrument de crawler web pentru descărcare gratuită.

- API-ul Clasificator le permite dezvoltatorilor să transmită text (sau adrese URL) pentru a fi etichetate de tehnologia noastră de învățare automată.

3. Import.io

Import.io vă permite să răzuiți milioane de pagini web în câteva minute și să construiți peste 1000 de API-uri bazate pe nevoile dvs. fără a scrie o singură linie de cod.

- Acum poate fi operat în mod programatic, iar datele pot fi acum recuperate automat.

- Extrageți date din multe pagini cu o apăsare a unui buton.

- Poate recunoaște automat listele paginate sau puteți face clic pe pagina următoare.

- Puteți încorpora date online în aplicația sau site-ul dvs. web cu doar câteva clicuri.

- Creați toate adresele URL de care aveți nevoie în câteva secunde utilizând modele precum numerele de pagini și numele categoriilor.

- Import.io simplifică demonstrarea modului de extragere a datelor dintr-o pagină. Pur și simplu selectați o coloană din setul de date și indicați spre ceva de pe pagină care vă atrage atenția.

- Este posibil să primiți o cotație pe site-ul lor.

- Link-urile de pe paginile de listă conduc la pagini detaliate cu informații suplimentare.

- Puteți folosi Import.io pentru a vă alătura acestora pentru a obține simultan toate datele din paginile de detalii.

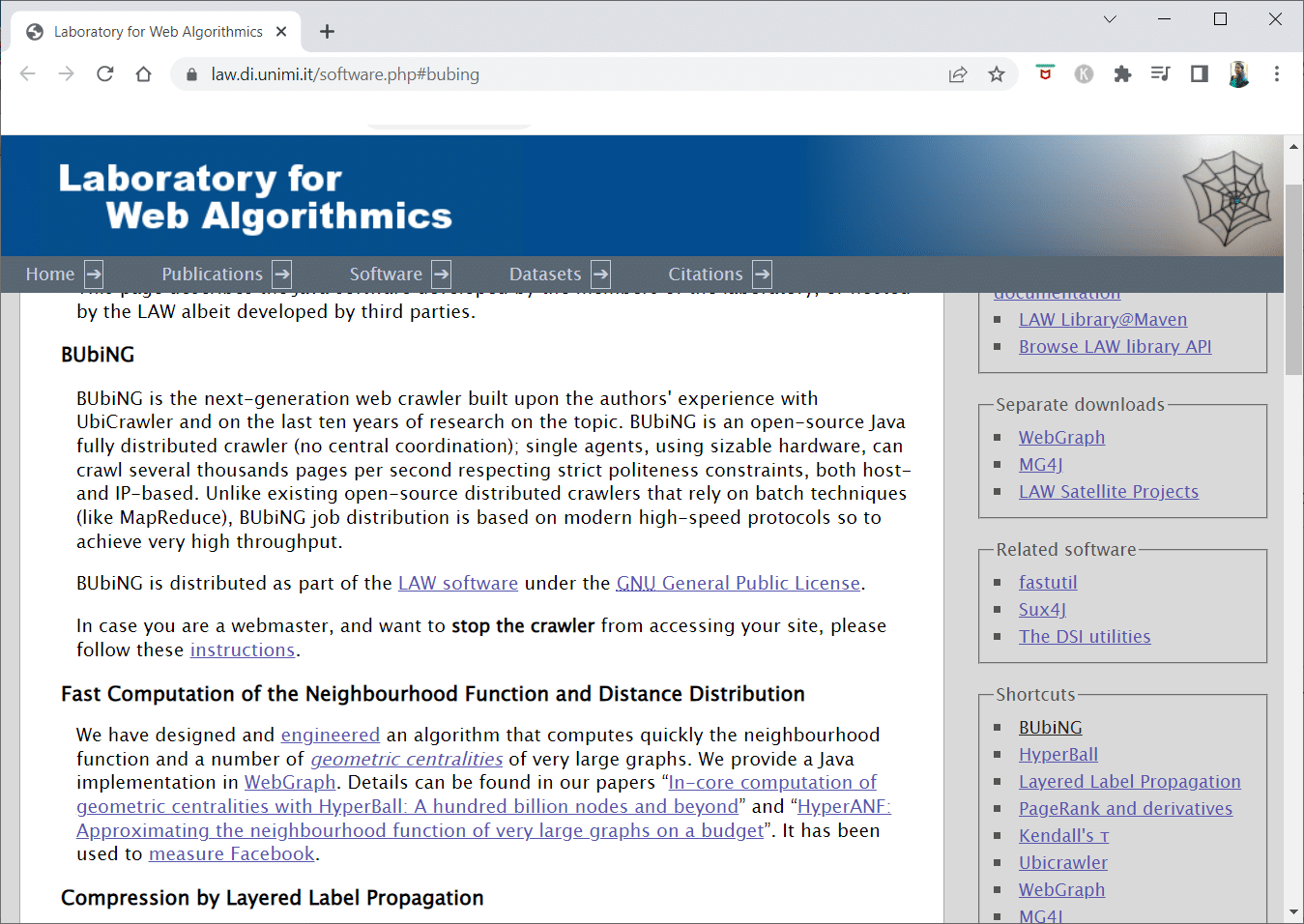

4. BUBING

BUbiNG, un instrument de crawler web de ultimă generație, este punctul culminant al experienței autorilor cu UbiCrawler și a zece ani de cercetare pe acest subiect.

- Mii de pagini pe secundă pot fi accesate cu crawlere de un singur agent, respectând în același timp standardele stricte de politețe, atât pe gazdă, cât și pe IP.

- Distribuția sa de locuri de muncă este construită pe protocoale contemporane de mare viteză pentru a oferi un debit foarte mare, spre deosebire de crawlerele distribuite open-source anterioare care depind de tehnicile batch.

- Folosește amprenta unei pagini îndepărtate pentru a detecta aproape duplicatele.

- BUbiNG este un crawler Java cu sursă deschisă complet distribuit.

- Are multe paralelisme.

- Există o mulțime de oameni care folosesc acest produs.

- Este rapid.

- Permite accesarea cu crawlere pe scară largă.

5. GNU Wget

GNU Wget este un instrument de crawler web gratuit disponibil și este un program software open-source scris în C care vă permite să obțineți fișiere prin HTTP, HTTPS, FTP și FTPS.

- Unul dintre cele mai distinctive aspecte ale acestei aplicații este capacitatea de a crea fișiere de mesaje bazate pe NLS în diferite limbi.

- Puteți reporni descărcările care au fost oprite utilizând REST și RANGE.

- De asemenea, poate transforma link-uri absolute din documentele descărcate în link-uri relative, dacă este necesar.

- Folosiți recursiv caracterele metalice în numele fișierelor și directoarele oglindă.

- Fișiere de mesaje bazate pe NLS pentru o varietate de limbi.

- În timpul reflectării, marcajele de timp ale fișierelor locale sunt evaluate pentru a determina dacă documentele trebuie să fie re-descărcate.

6. Webhose.io

Webhose.io este o aplicație fantastică de crawler web care vă permite să scanați date și să extrageți cuvinte cheie în mai multe limbi, folosind diferite filtre care acoperă o gamă largă de surse.

- De asemenea, arhiva permite utilizatorilor să vizualizeze datele anterioare.

- În plus, descoperirile de date de crawling ale webhose.io sunt disponibile în până la 80 de limbi.

- Toate informațiile de identificare personală care au fost compromise pot fi găsite într-un singur loc.

- Investigați rețelele întunecate și aplicațiile de mesagerie pentru amenințările cibernetice.

-

Formatele XML, JSON și RSS sunt, de asemenea, accesibile pentru datele răzuite.

- Este posibil să primiți o cotație pe site-ul lor.

- Utilizatorii pot indexa și căuta pur și simplu datele structurate pe Webhose.io.

- În toate limbile, poate monitoriza și analiza instituțiile media.

- Este posibil să urmăriți discuțiile pe forumuri și forumuri.

- Vă permite să urmăriți postările cheie de pe blog de pe tot web.

7. Norconex

Norconex este o resursă excelentă pentru companiile care caută o aplicație de crawler web open-source.

- Acest colector cu funcții complete poate fi utilizat sau integrat în programul dumneavoastră.

- De asemenea, poate lua imaginea prezentată a unei pagini.

- Norconex vă oferă posibilitatea de a accesa cu crawlere conținutul oricărui site web.

- Este posibil să utilizați orice sistem de operare.

- Acest software de crawler web poate accesa cu crawlere milioane de pagini pe un singur server de capacitate medie.

- De asemenea, include un set de instrumente pentru modificarea conținutului și a metadatelor.

- Obțineți metadatele pentru documentele la care lucrați în prezent.

-

Paginile redate prin JavaScript sunt acceptate.

- Permite detectarea mai multor limbi.

- Permite asistență pentru traducere.

- Viteza cu care te târâști poate fi modificată.

- Sunt identificate documentele care au fost modificate sau eliminate.

- Acesta este un program de crawler web complet gratuit.

8. Dexi.io

Dexi.io este o aplicație de crawler web bazată pe browser, care vă permite să răzuiți informații de pe orice site web.

-

Extractoarele, șenilele și țevile sunt cele trei tipuri de roboți pe care le puteți utiliza pentru a efectua o operație de răzuire.

- Evoluțiile pieței sunt prognozate folosind rapoartele Delta.

- Datele dvs. colectate vor fi păstrate timp de două săptămâni pe serverele Dexi.io înainte de arhivare, sau puteți exporta imediat datele extrase ca fișiere JSON sau CSV.

- Este posibil să primiți o cotație pe site-ul lor.

- Sunt oferite servicii profesionale, cum ar fi asigurarea calității și întreținerea continuă.

- Oferă servicii comerciale pentru a vă ajuta să vă îndepliniți nevoile de date în timp real.

- Este posibil să urmăriți stocul și prețurile pentru un număr nelimitat de SKU/produse.

- Vă permite să integrați datele folosind tablouri de bord live și analize complete ale produselor.

- Vă ajută să pregătiți și să clătiți datele despre produse organizate și gata de utilizare bazate pe web.

9. Zyte

Zyte este un instrument de extragere a datelor bazat pe cloud care ajută zeci de mii de dezvoltatori să găsească informații esențiale. Este, de asemenea, una dintre cele mai bune aplicații gratuite de crawler web.

- Utilizatorii pot răzui pagini web folosind aplicația sa de scraping vizual open-source fără să cunoască codificare.

-

Crawlera, un rotator proxy complex folosit de Zyte, permite utilizatorilor să acceseze cu crawlere site-uri mari sau protejate de bot cu ușurință, evitând contramăsurile botului.

- Informațiile dvs. online sunt livrate la timp și în mod constant. În consecință, în loc să gestionați proxy-urile, vă puteți concentra pe obținerea de date.

- Datorită capacităților și redării inteligente ale browserului, antiboții care vizează stratul de browser pot fi acum gestionați cu ușurință.

- Pe site-ul lor, puteți obține o cotație.

- Utilizatorii pot accesa cu crawlere din numeroase IP-uri și regiuni folosind un simplu API HTTP, eliminând necesitatea întreținerii proxy.

- Vă ajută să generați numerar, economisind și timp prin obținerea informațiilor de care aveți nevoie.

- Vă permite să extrageți date web la scară largă, economisind în același timp timp la codificare și întreținerea spider.

10. Apache Nutch

Apache Nutch este, fără îndoială, în fruntea listei pentru cea mai bună aplicație de crawler web open source.

- Poate funcționa pe o singură mașină. Cu toate acestea, funcționează cel mai bine pe un cluster Hadoop.

- Pentru autentificare, se utilizează protocolul NTLM.

- Are un sistem de fișiere distribuit (prin Hadoop).

- Este un proiect software de extragere a datelor online, cu sursă deschisă bine-cunoscut, care este adaptabil și scalabil pentru extragerea datelor.

- Mulți analiști de date îl folosesc, oameni de știință, dezvoltatori de aplicații și specialiști în minerit de text web din întreaga lume.

- Este o soluție multiplatformă bazată pe Java.

- În mod implicit, preluarea și analizarea se fac independent.

- Datele sunt mapate folosind XPath și spații de nume.

- Conține o bază de date cu grafice de legături.

11. VisualScraper

VisualScraper este un alt fantastic web scraper non-coding pentru extragerea datelor de pe Internet.

- Oferă o interfață de utilizator simplă de tip point-and-click.

- De asemenea, oferă servicii de scraping online, cum ar fi diseminarea datelor și construirea de extractoare de software.

- Îți ține un ochi și pe concurenții tăi.

- Utilizatorii își pot programa proiectele să ruleze la o anumită oră sau să li se repete secvența în fiecare minut, zi, săptămână, lună și an cu Visual Scraper.

- Este mai puțin costisitor și mai eficient.

- Nu există nici măcar un cod pentru a vorbi.

- Acesta este un program de crawler web complet gratuit.

- Datele în timp real pot fi extrase din mai multe pagini web și salvate ca fișiere CSV, XML, JSON sau SQL.

- Utilizatorii îl pot folosi pentru a extrage în mod regulat știri, actualizări și postări pe forum.

- Datele sunt 100% exacte și personalizate.

12. WebSphinx

WebSphinx este o aplicație fantastică de crawler web gratuită, care este ușor de configurat și utilizat.

- Este conceput pentru utilizatorii web sofisticați și programatori Java care doresc să scaneze automat o porțiune limitată a Internetului.

- Această soluție de extragere a datelor online include o bibliotecă de clase Java și un mediu de programare interactiv.

- Paginile pot fi concatenate pentru a face un singur document care poate fi răsfoit sau tipărit.

-

Extrageți tot textul care se potrivește unui model dat dintr-o secvență de pagini.

- Crawlerele web pot fi acum scrise în Java datorită acestui pachet.

- Crawler Workbench și biblioteca de clase WebSPHINX sunt ambele incluse în WebSphinx.

- Crawler Workbench este o interfață grafică cu utilizatorul care vă permite să personalizați și să operați un crawler web.

- Un grafic poate fi realizat dintr-un grup de pagini web.

- Salvați paginile pe discul dvs. local pentru citire offline.

13. OutWit Hub

Platforma OutWit Hub constă dintr-un nucleu cu o bibliotecă extinsă de capacități de recunoaștere și extracție a datelor, pe care pot fi create un număr nesfârșit de aplicații diferite, fiecare utilizând caracteristicile nucleului.

- Această aplicație web crawler poate scana prin site-uri și poate păstra datele pe care le descoperă într-un mod accesibil.

- Este o mașină de recoltat multifuncțională, cu cât mai multe funcții posibil pentru a se potrivi diferitelor cerințe.

- Hub-ul există de mult timp.

- A evoluat într-o platformă utilă și diversă pentru utilizatorii non-tehnici și profesioniștii IT care știu să codifice, dar recunosc că PHP nu este întotdeauna opțiunea ideală pentru extragerea datelor.

- OutWit Hub oferă o interfață unică pentru scraping cantități modeste sau masive de date, în funcție de cerințele dvs.

- Vă permite să răzuiți orice pagină web direct din browser și să construiți agenți automatizați care preiau date și le pregătesc în funcție de cerințele dumneavoastră.

- Este posibil să primiți o cotație pe site-ul lor.

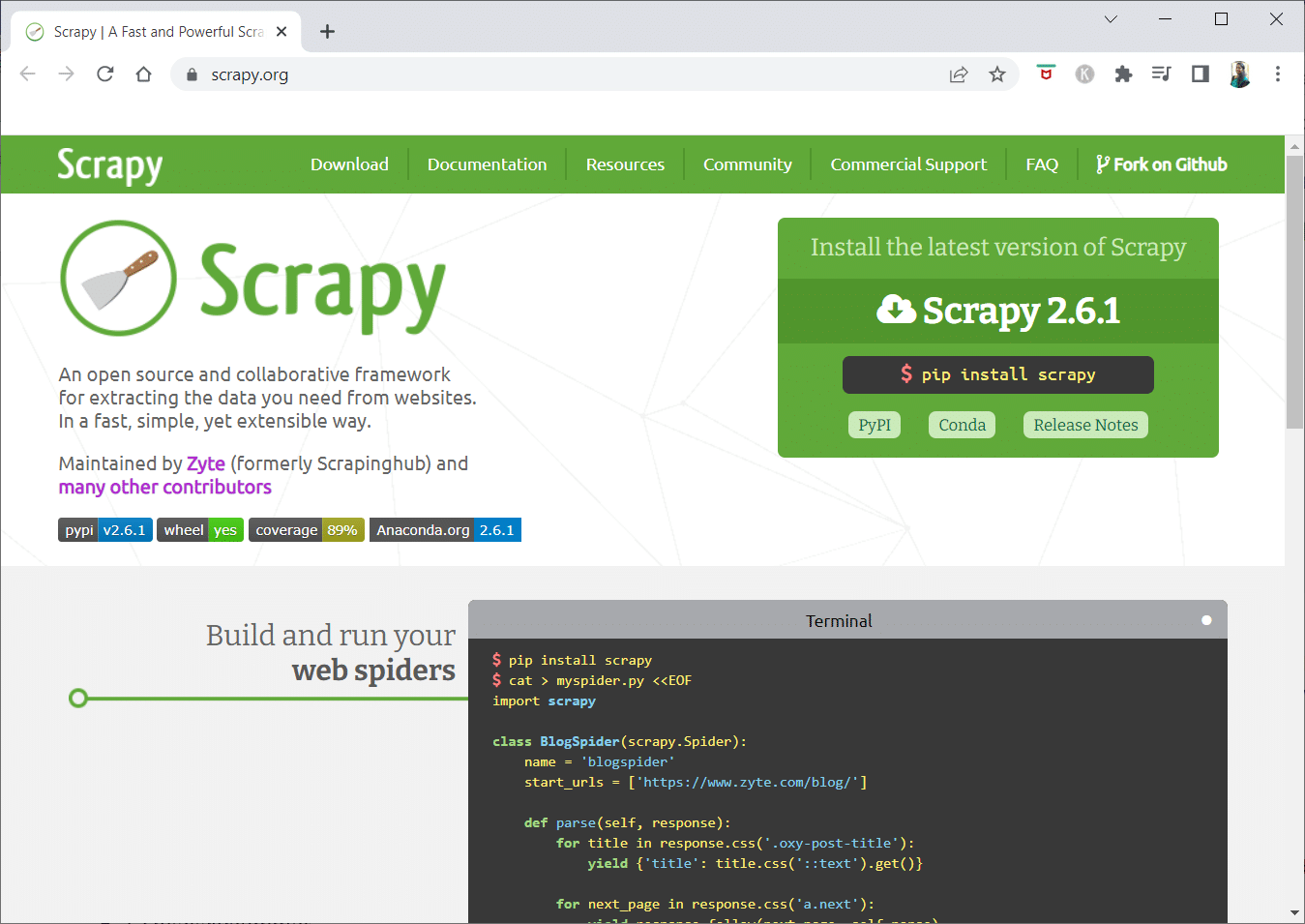

14. Scrapy

Scrapy este un cadru de scraping online Python pentru construirea de crawler-uri web scalabile.

- Este un cadru complet de crawling web care se ocupă de toate caracteristicile care fac crawlerele web dificil de creat, cum ar fi middleware-ul proxy și întrebările de interogare.

- Puteți scrie regulile pentru extragerea datelor și apoi lăsați Scrapy să se ocupe de restul.

- Este ușor să adăugați funcții noi fără a modifica nucleul, deoarece este conceput astfel.

- Este un program bazat pe Python care funcționează pe sisteme Linux, Windows, Mac OS X și BSD.

- Acesta este un utilitar complet gratuit.

- Biblioteca sa oferă programatorilor o structură gata de utilizare pentru personalizarea unui crawler web și extragerea datelor de pe web la scară mare.

15. Mozenda

Mozenda este, de asemenea, cea mai bună aplicație gratuită de crawler web. Este un program de web scraping, bazat pe cloud, orientat spre afaceri. Mozenda are peste 7 miliarde de pagini răzuite și are clienți corporativi din întreaga lume.

- Tehnologia web scraping de la Mozenda elimină cerințele pentru scripturi și angajarea de ingineri.

- Accelerează colectarea datelor de cinci ori.

- Puteți extrage text, fișiere, imagini și informații PDF de pe site-uri web cu capacitatea Mozenda de a indica și face clic.

- Prin organizarea fișierelor de date, le puteți pregăti pentru publicare.

- Puteți exporta direct în TSV, CSV, XML, XLSX sau JSON folosind API-ul Mozeda.

- Puteți utiliza Data Wrangling sofisticat de la Mozenda pentru a vă organiza informațiile astfel încât să puteți lua decizii vitale.

- Puteți folosi una dintre platformele partenerilor Mozenda pentru a integra date sau pentru a stabili integrări personalizate de date în câteva platforme.

16. Cyotek Webcopy

Cyotek Webcopy este un instrument gratuit de crawler web care vă permite să descărcați automat conținutul unui site web pe dispozitivul local.

- Conținutul site-ului web ales va fi scanat și descărcat.

- Puteți alege ce părți ale unui site web să clonați și cum să utilizați structura sa complexă.

- Noua rută locală va redirecționa link-uri către resursele site-ului web, cum ar fi foi de stil, imagini și alte pagini.

- Se va uita la marcajul HTML al unui site web și va încerca să găsească orice resurse conectate, cum ar fi alte site-uri web, fotografii, videoclipuri, descărcări de fișiere și așa mai departe.

- Este posibil să acceseze cu crawlere un site web și să descarce orice vede pentru a face o copie acceptabilă a originalului.

17. Crawl comun

Common Crawl a fost destinat oricărei persoane interesate să exploreze și să analizeze date pentru a obține informații utile.

- Este o organizație nonprofit 501(c)(3) care se bazează pe donații pentru a-și desfășura operațiunile corect.

- Oricine dorește să utilizeze Common Crawl poate face acest lucru fără a cheltui bani sau a cauza probleme.

- Common Crawl este un corpus care poate fi utilizat pentru predare, cercetare și analiză.

- Ar trebui să citiți articolele dacă nu aveți abilități tehnice pentru a afla despre descoperirile remarcabile pe care le-au făcut alții utilizând datele Common Crawl.

- Profesorii pot folosi aceste instrumente pentru a preda analiza datelor.

18. Semrush

Semrush este o aplicație de crawler pentru site-uri web care examinează paginile și structura site-ului dvs. pentru probleme tehnice SEO. Remedierea acestor probleme vă poate ajuta să vă îmbunătățiți rezultatele căutării.

- Are instrumente pentru SEO, cercetare de piață, marketing pe rețelele sociale și publicitate.

- Are o interfață de utilizator ușor de utilizat.

-

Vor fi examinate metadatele, HTTP/HTTPS, directivele, codurile de stare, conținutul duplicat, viteza de răspuns a paginii, legăturile interne, dimensiunile imaginii, datele structurate și alte elemente.

- Vă permite să vă auditați site-ul rapid și simplu.

- Ajută la analiza fișierelor jurnal.

- Acest program oferă un tablou de bord care vă permite să vizualizați cu ușurință problemele site-ului.

19. Sitechecker.pro

Sitechecker.pro este o altă aplicație gratuită de crawler web. Este un verificator SEO pentru site-uri web care vă ajută să vă îmbunătățiți clasamentul SEO.

- Puteți vizualiza cu ușurință structura unei pagini web.

- Acesta creează un raport de audit SEO pe pagină pe care clienții îl pot primi prin e-mail.

- Acest instrument de crawler web poate analiza linkurile interne și externe ale site-ului dvs. web.

- Vă ajută să determinați viteza site-ului dvs.

- De asemenea, puteți utiliza Sitechecker.pro pentru a verifica dacă există probleme de indexare pe paginile de destinație.

- Vă ajută să vă apărați împotriva atacurilor hackerilor.

20. Webharvy

Webharvy este un instrument de scraping web cu o interfață simplă punct-and-click. Este conceput pentru cei care nu știu să codifice.

- Costul unei licențe începe de la 139 USD.

- Veți folosi browserul încorporat WebHarvy pentru a încărca site-uri online și pentru a alege datele care vor fi răzuite folosind clicuri de mouse.

- Poate răzui automat text, fotografii, adrese URL și e-mailuri de pe site-uri web și le poate salva în diferite formate.

-

Serverele proxy sau un VPN pot fi folosite pentru a accesa site-urile web țintă.

- Scrapingul datelor nu necesită crearea vreunei programe sau aplicații.

- Puteți să faceți scraping în mod anonim și să împiedicați ca software-ul de web scraping să fie interzis de serverele web, utilizând servere proxy sau VPN-uri pentru a accesa site-urile web țintă.

- WebHarvy identifică automat tiparele de date pe site-uri web.

- Dacă trebuie să răzuiți o listă de obiecte dintr-o pagină web, nu trebuie să faceți nimic altceva.

21. NetSpeak Spider

NetSpeak Spider este o aplicație de crawler web desktop pentru audituri SEO zilnice, identificarea rapidă a problemelor, efectuarea de analize sistematice și eliminarea paginilor web.

- Această aplicație de crawling excelează la evaluarea paginilor web mari, minimizând în același timp utilizarea RAM.

- Fișierele CSV pot fi importate și exportate cu ușurință din datele de accesare cu crawlere pe web.

- Cu doar câteva clicuri, puteți identifica acestea și sute de alte preocupări grave legate de SEO pentru site-uri.

- Instrumentul vă va ajuta să evaluați optimizarea site-ului pe pagină, inclusiv codul de stare, instrucțiunile de accesare cu crawlere și indexare, structura site-ului web și redirecționări, printre altele.

- Datele din Google Analytics și Yandex pot fi exportate.

- Luați în considerare intervalul de date, tipul dispozitivului și segmentarea pentru paginile site-ului, trafic, conversii, ținte și chiar setările de comerț electronic.

- Abonamentele sale lunare încep de la 21 USD.

-

Link-urile și fotografiile rupte vor fi detectate de crawler-ul SEO, precum și materialele duplicate, cum ar fi paginile, textele, etichetele duplicate de titlu și meta-descriere și H1-urile.

22. UiPath

UiPath este un instrument de scraping online cu crawler web care vă permite să automatizați procedurile robotizate. Automatizează accesarea cu crawlere a datelor online și desktop pentru majoritatea programelor terțe.

- Puteți instala aplicația de automatizare a proceselor robotizate pe Windows.

- Poate extrage date în forme tabelare și bazate pe modele din multe pagini web.

- UiPath poate efectua accesări suplimentare cu crawlere imediat din cutie.

- Raportarea ține evidența roboților dvs., astfel încât să puteți consulta documentația în orice moment.

- Rezultatele dvs. vor fi mai eficiente și de succes dacă vă standardizați practicile.

-

Abonamentele lunare încep de la 420 USD.

- Cele peste 200 de componente gata făcute ale pieței oferă echipei dvs. mai mult timp în mai puțin timp.

- Roboții UiPath sporesc conformitatea urmând metoda exactă care răspunde nevoilor dumneavoastră.

- Companiile pot realiza o transformare digitală rapidă la costuri mai mici prin optimizarea proceselor, recunoașterea economiilor și oferirea de informații.

23. Razuitoare cu heliu

Helium Scraper este o aplicație vizuală de accesare cu crawlere a datelor online, care funcționează cel mai bine atunci când există o asociere mică între elemente. La un nivel de bază, ar putea satisface cerințele de crawling ale utilizatorilor.

- Nu necesită codare sau configurație.

- O interfață de utilizator clară și ușoară vă permite să selectați și să adăugați activități dintr-o listă specificată.

- Șabloanele online sunt, de asemenea, disponibile pentru cerințele de crawling specializate.

- În afara ecranului, sunt utilizate mai multe browsere web Chromium.

- Măriți numărul de browsere simultane pentru a obține cât mai multe date posibil.

- Definiți-vă propriile acțiuni sau utilizați JavaScript personalizat pentru instanțe mai complexe.

- Poate fi instalat pe un computer personal sau pe un server Windows dedicat.

- Licențele sale încep de la 99 USD și cresc de acolo.

24. 80Picioare

În 2009, 80Legs a fost fondată pentru a face datele online mai accesibile. Este încă unul dintre cele mai bune instrumente gratuite de crawler web. Inițial, firma s-a concentrat pe furnizarea de servicii de crawling web către diverși clienți.

- Aplicația noastră extinsă de crawler web vă va oferi informații personalizate.

- Viteza de accesare cu crawlere este ajustată automat în funcție de traficul site-ului.

- Puteți descărca constatările în mediul local sau pe computer prin intermediul 80legs.

- Doar oferind o adresă URL, puteți accesa cu crawlere site-ul.

- Abonamentele sale lunare încep de la 29 USD pe lună.

- Prin SaaS, este posibil să construiți și să efectuați accesări cu crawlere web.

- Are multe servere care vă permit să vizualizați site-ul de la diverse adrese IP.

- Obțineți acces instantaneu la datele site-ului în loc să căutați pe web.

- Facilitează construirea și execuția de accesări web personalizate.

- Puteți utiliza această aplicație pentru a urmări tendințele online.

- Vă puteți crea șabloanele dacă doriți.

25. ParseHub

ParseHub este o aplicație excelentă de crawler web care poate colecta informații de pe site-uri web care utilizează AJAX, JavaScript, cookie-uri și alte tehnologii conexe.

- Motorul său de învățare automată poate citi, evalua și transforma conținutul online în date semnificative.

- De asemenea, puteți utiliza aplicația web încorporată în browser.

- Este posibilă obținerea de informații de la milioane de site-uri web.

- ParseHub va căuta automat prin mii de link-uri și cuvinte.

- Datele sunt colectate și stocate automat pe serverele noastre.

-

Pachetele lunare încep de la 149 USD.

- Ca shareware, puteți construi doar cinci proiecte publice pe ParseHub.

- Îl puteți folosi pentru a accesa meniurile derulante, pentru a vă conecta la site-uri web, pentru a face clic pe hărți și pentru a gestiona paginile web folosind derulare infinită, file și ferestre pop-up.

- Clientul desktop ParseHub este disponibil pentru Windows, Mac OS X și Linux.

- Puteți achiziționa datele răzuite în orice format pentru analiză.

- Puteți stabili cel puțin 20 de proiecte private de scraping cu niveluri de membru premium.

***

Sperăm că acest articol a fost util și că ați ales instrumentul de crawler web gratuit preferat. Împărtășiți-vă gândurile, întrebările și sugestiile în secțiunea de comentarii de mai jos. De asemenea, ne puteți sugera instrumentele lipsă. Spune-ne ce vrei să înveți în continuare.